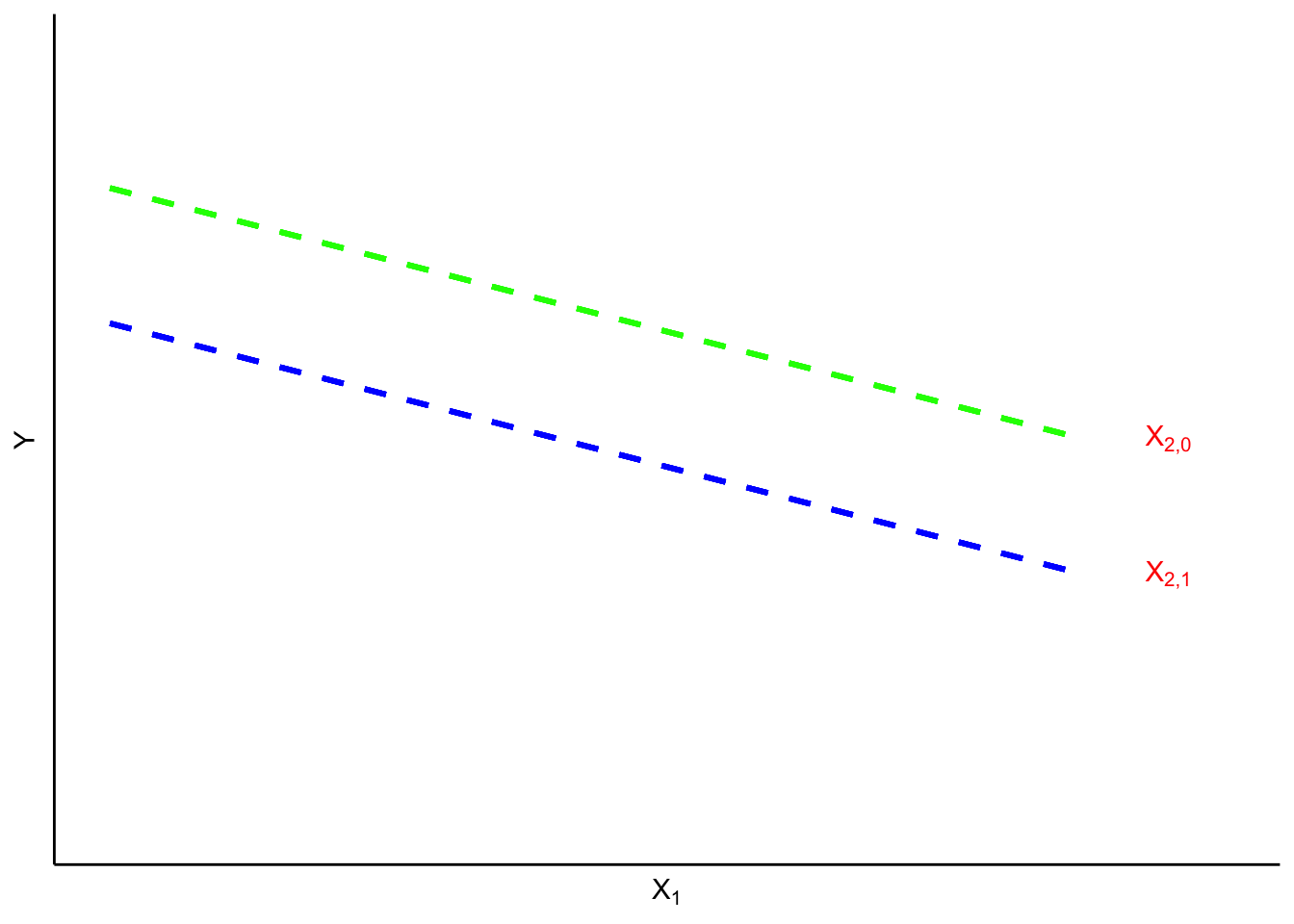

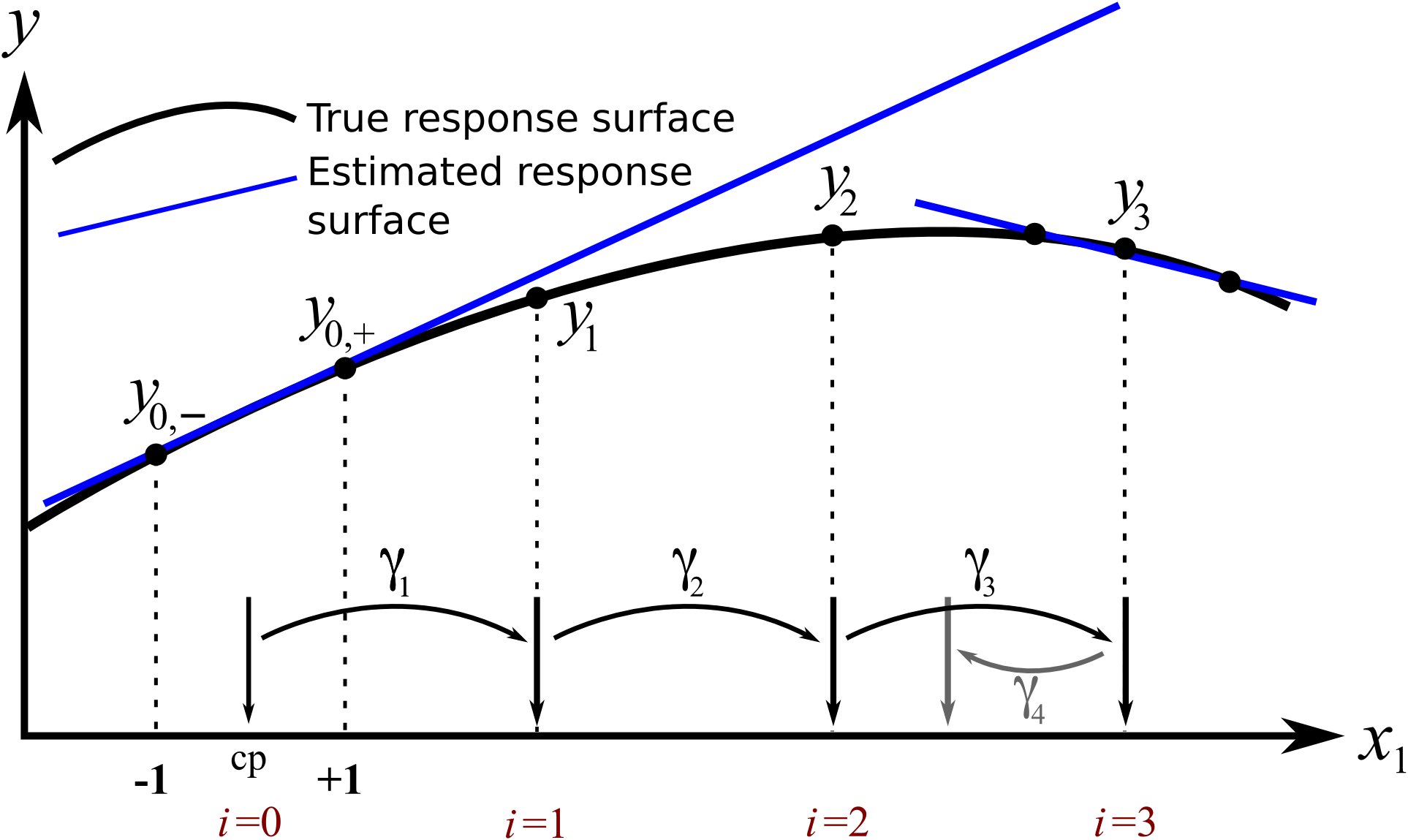

MSR pour une seule variable

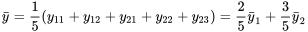

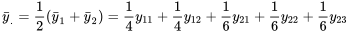

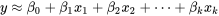

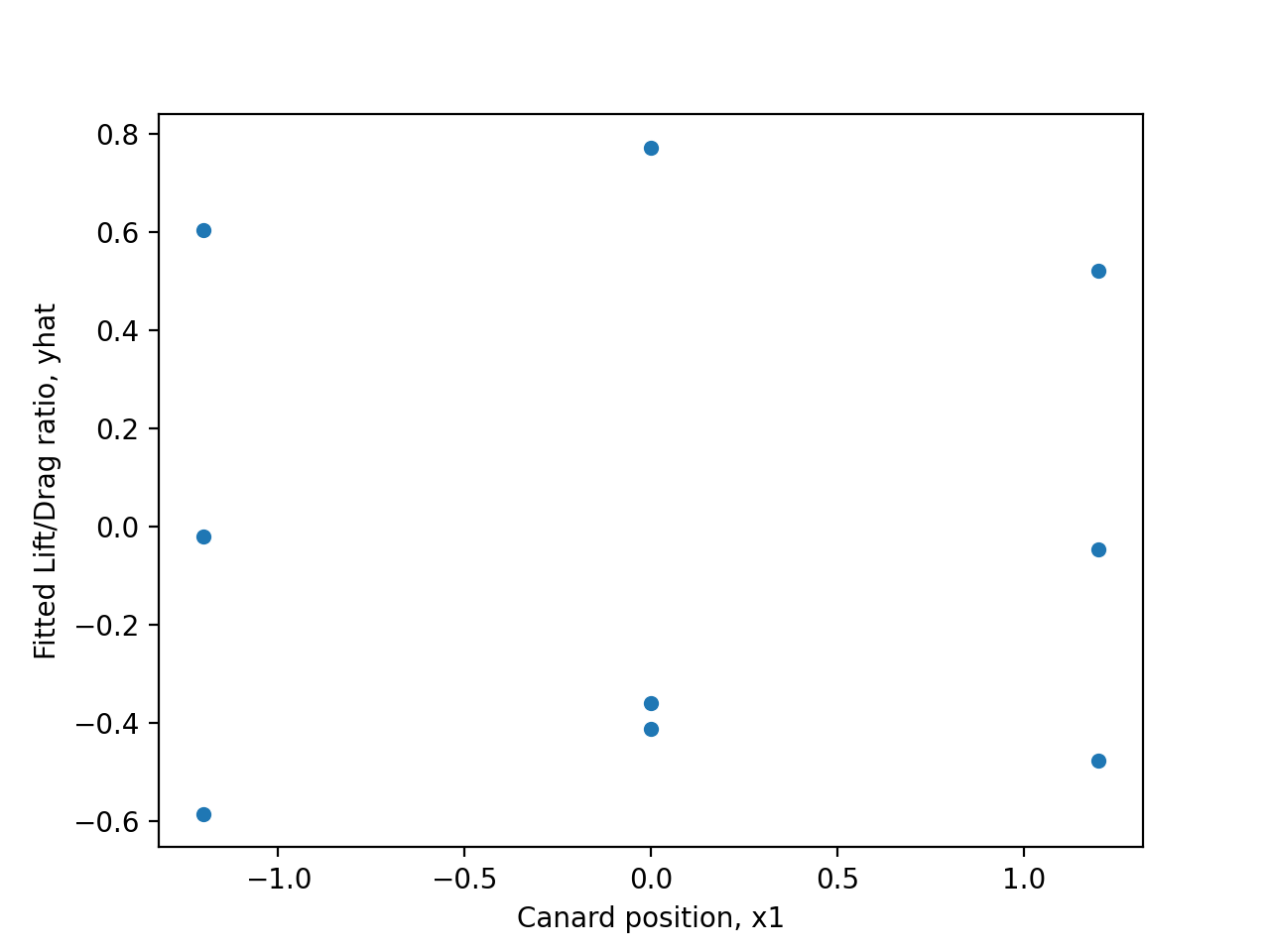

Examinons d’abord l’effet d’un seul facteur  sur la réponse,

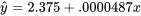

sur la réponse,  . Cet exemple servira à illustrer le principe général du processus de surface de réponse.

. Cet exemple servira à illustrer le principe général du processus de surface de réponse.

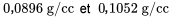

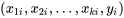

Le point  sert de point de référence initial (pc = point de centrage). Puis, on exécute une expérience à deux niveaux, au-dessous (à – 1) et au-dessus (à 1) de ce point de référence, et on obtient des valeurs de réponse correspondantes de

sert de point de référence initial (pc = point de centrage). Puis, on exécute une expérience à deux niveaux, au-dessous (à – 1) et au-dessus (à 1) de ce point de référence, et on obtient des valeurs de réponse correspondantes de  et

et  . À partir de là, on peut estimer la droite de régression et la suivre dans la direction croissante

. À partir de là, on peut estimer la droite de régression et la suivre dans la direction croissante  . Notez que l’inclinaison de la pente d’une droite tangente correspond à la trajectoire de pente maximale. On effectue un pas de

. Notez que l’inclinaison de la pente d’une droite tangente correspond à la trajectoire de pente maximale. On effectue un pas de  unités le long de

unités le long de  , puis on mesure la réponse,

, puis on mesure la réponse,  . Puisque la variable de la réponse a augmenté, on poursuit dans cette direction.

. Puisque la variable de la réponse a augmenté, on poursuit dans cette direction.

On effectue un nouveau pas, cette fois-ci de unités dans la direction où

unités dans la direction où  est croissant. On mesure la réponse,

est croissant. On mesure la réponse,  , qui est encore croissante. Ce résultat nous encourage à effectuer un nouveau pas de

, qui est encore croissante. Ce résultat nous encourage à effectuer un nouveau pas de  . Les pas

. Les pas  doivent être suffisamment grands pour causer une variation de la réponse lors d’un nombre raisonnable d’expériences, sans toutefois être si grands qu’ils nous feraient passer à côté d’un optimum.

doivent être suffisamment grands pour causer une variation de la réponse lors d’un nombre raisonnable d’expériences, sans toutefois être si grands qu’ils nous feraient passer à côté d’un optimum.

Le nouveau point,  , a environ la même valeur que

, a environ la même valeur que  , ce qui indique qu’on a atteint un plateau. À ce stade, on peut se lancer dans une démarche exploratoire et réajuster la tangente (qui est maintenant de pente inverse). On peut aussi utiliser les points de données accumulés pour faire une régression non linéaire. Dans les deux cas, on peut alors estimer un nouveau pas de progression de

, ce qui indique qu’on a atteint un plateau. À ce stade, on peut se lancer dans une démarche exploratoire et réajuster la tangente (qui est maintenant de pente inverse). On peut aussi utiliser les points de données accumulés pour faire une régression non linéaire. Dans les deux cas, on peut alors estimer un nouveau pas de progression de  pour se rapprocher de l’optimum.

pour se rapprocher de l’optimum.

Cette approche convient lorsque la réponse ne dépend que d’un seul facteur. Cependant, dans la plupart des systèmes, la réponse est influencée par plusieurs facteurs, ce qui nous oblige à adapter cette méthode pour trouver les optimums du système.

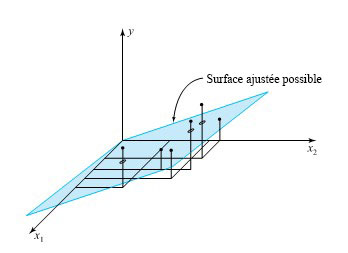

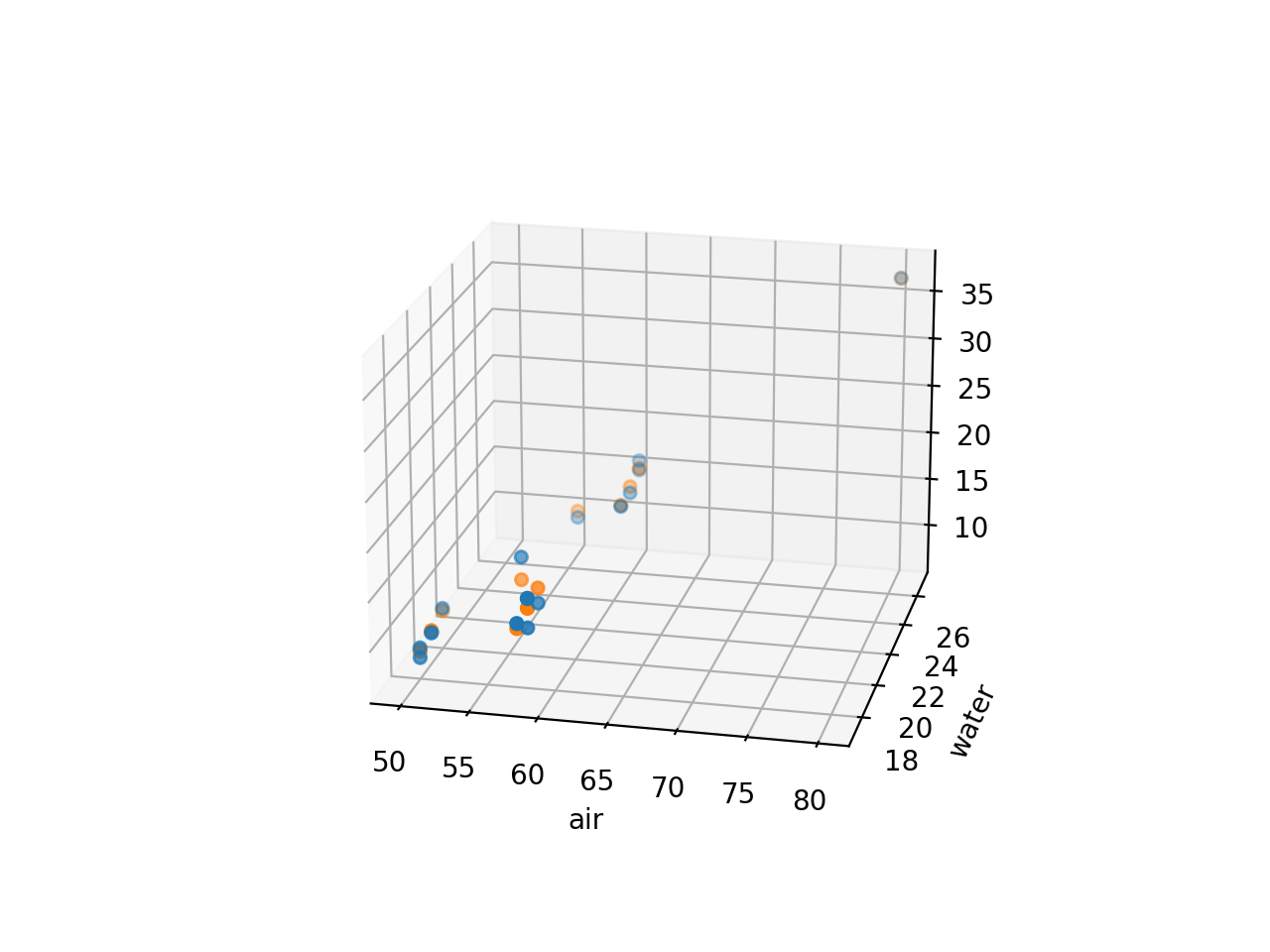

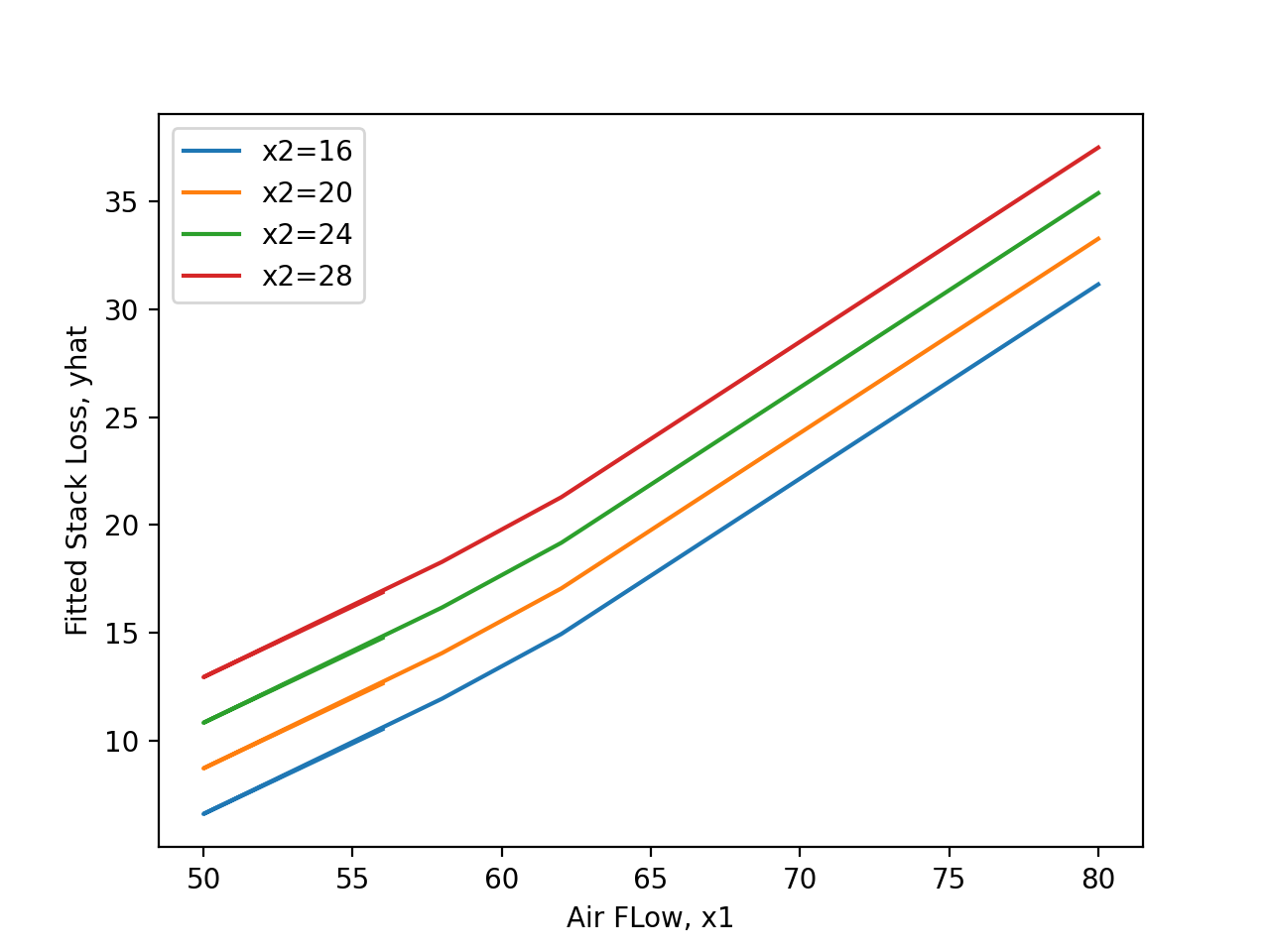

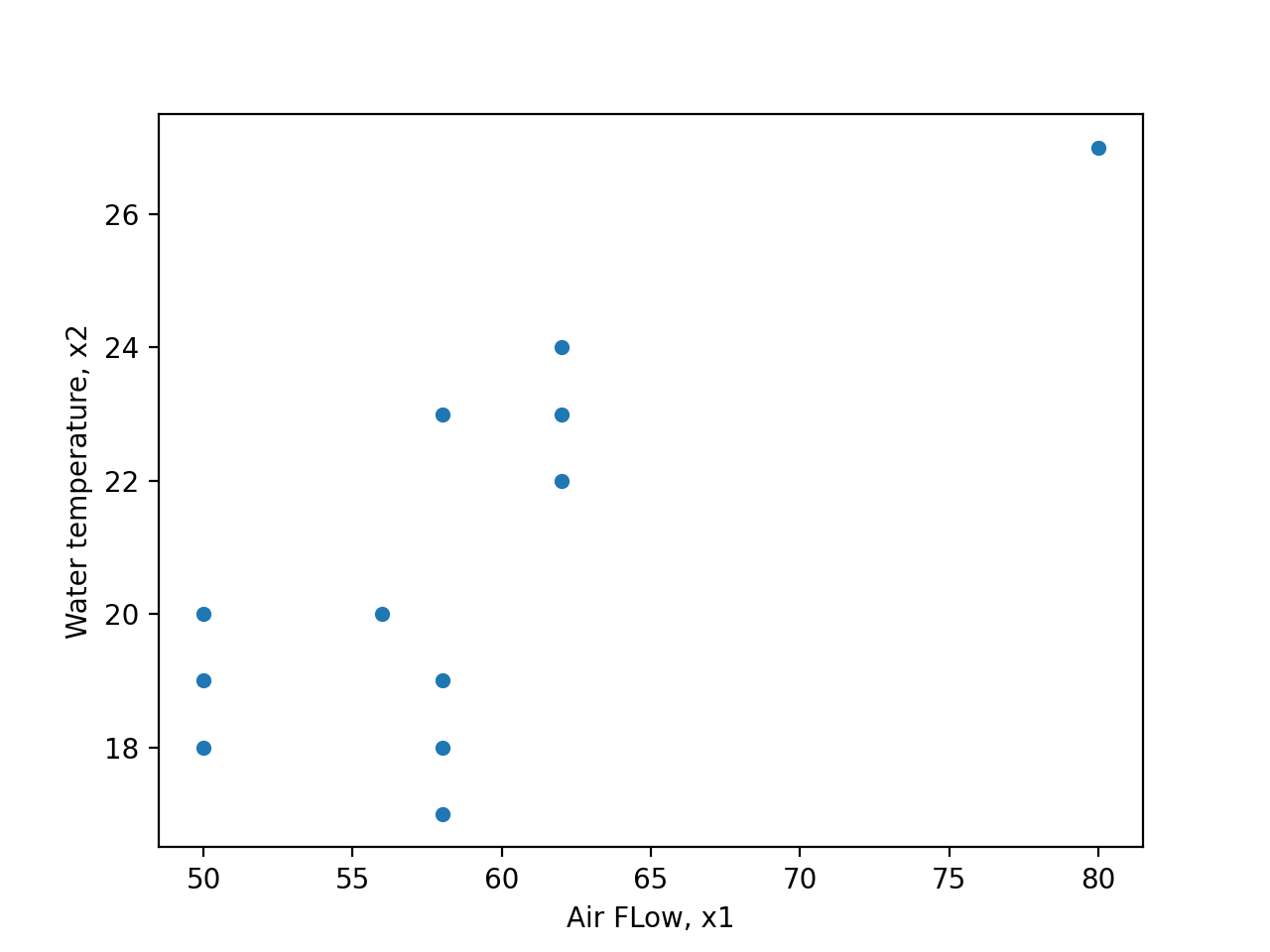

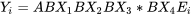

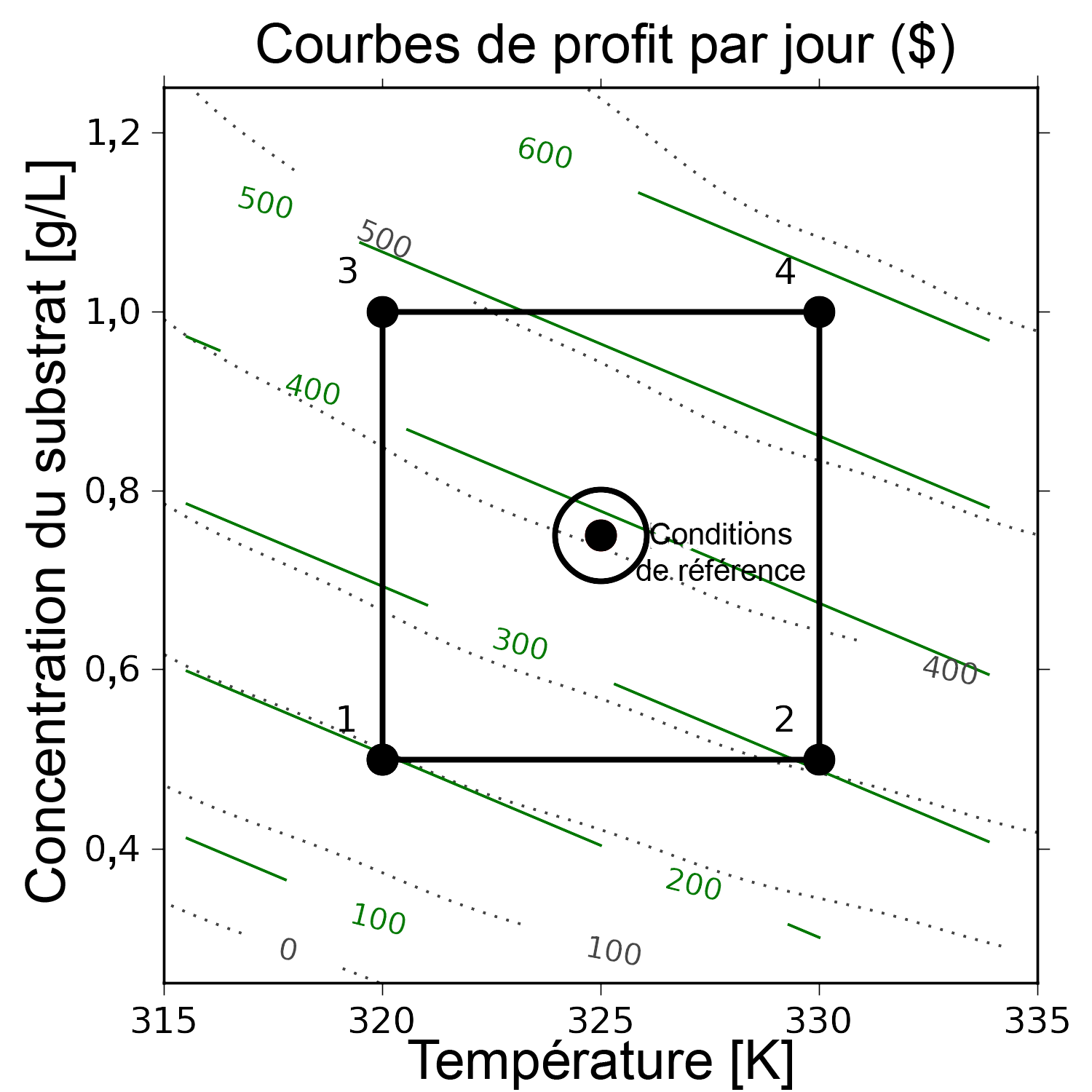

9.3.2. Optimisation d’un système à deux variables

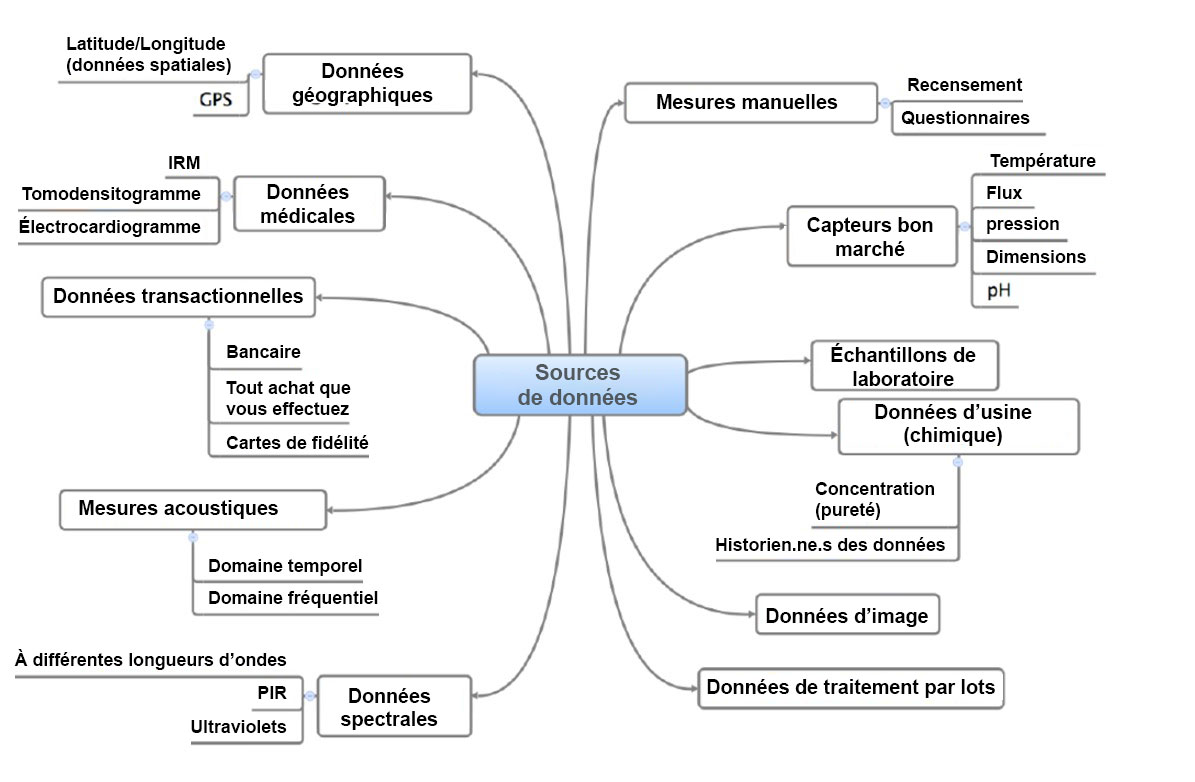

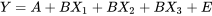

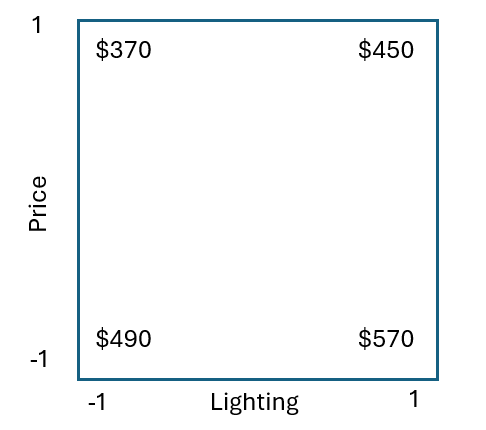

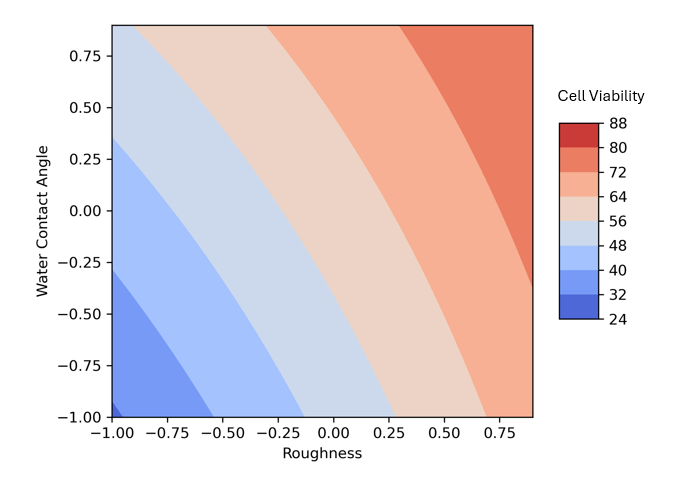

Supposons qu’on cherche à optimiser un bioréacteur dont le rendement est affecté par deux facteurs, la température T et la concentration en substrat S. Or, le résultat qui nous intéresse dans ce contexte, c’est le profit total, qui prend en compte les coûts énergétiques, les coûts des matières premières et autres facteurs pertinents. La figure 9.3.2.1 illustre en gris clair des courbes (hypothétiques) de profit. En pratique, ces courbes sont souvent inconnues. Le système fonctionne actuellement dans les conditions suivantes (conditions de référence) :

- T = 325 K

- S = 0,75 g/L

- Profit = 407 $ par jour

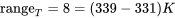

On crée une analyse factorielle complète à partir de ces conditions en choisissant  K, et

K, et  g/L, sachant que ces pas sont suffisamment grands pour révéler une différence dans la valeur de la réponse (voir le tableau 9.3.2.1), sans toutefois être si grands qu’ils exploreraient un tout autre régime du bioréacteur.

g/L, sachant que ces pas sont suffisamment grands pour révéler une différence dans la valeur de la réponse (voir le tableau 9.3.2.1), sans toutefois être si grands qu’ils exploreraient un tout autre régime du bioréacteur.

| Expérience | T (réelle) | S (réelle) | T (codée) | S (codée) | Profit |

|---|---|---|---|---|---|

| Conditions de référence | 325 K | 0,75 g/L | 0 | 0 | 407 |

| 1 | 320 K | 0,50 g/L | – | – | 193 |

| 2 | 330 K | 0,50 g/L | + | – | 310 |

| 3 | 320 K | 1,0 g/L | – | + | 468 |

| 4 | 330 K | 1,0 g/L | + | + | 571 |

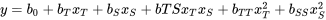

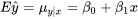

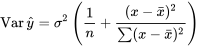

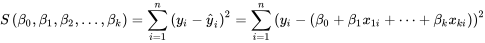

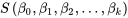

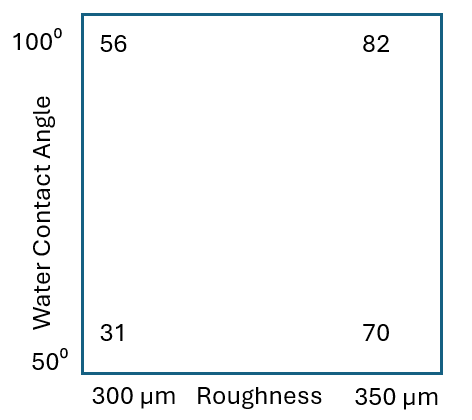

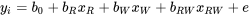

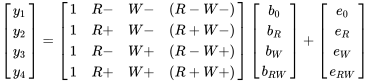

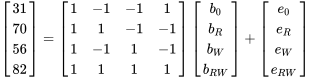

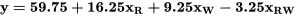

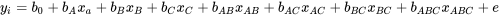

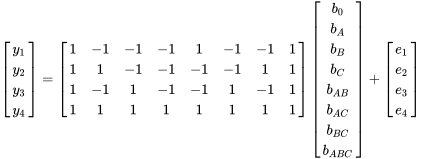

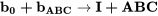

Il apparaît clairement qu’on peut maximiser les profits en opérant à des températures plus élevées et en utilisant de plus fortes concentrations de substrat. Néanmoins, la seule manière de mesurer ce taux d’augmentation est d’établir un modèle linéaire du système à partir des données factorielles :

où

où

et  .

.

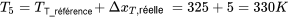

Le modèle démontre que l’on peut s’attendre à une hausse de profit de 55 $ par jour pour une augmentation d’une unité de T. En unités réelles, il faudrait augmenter la température de  pour atteindre cet objectif. Ce facteur d’échelle provient du codage que nous avons utilisé :

pour atteindre cet objectif. Ce facteur d’échelle provient du codage que nous avons utilisé :

\Delta x_T &= \displaystyle \frac{\Delta x_{T,\text{réelle}}}{\Delta_T / 2}\end{split}\]

Au même titre, on peut augmenter \(S\) par  pour obtenir une hausse de profit de 134 $ par jour.

pour obtenir une hausse de profit de 134 $ par jour.

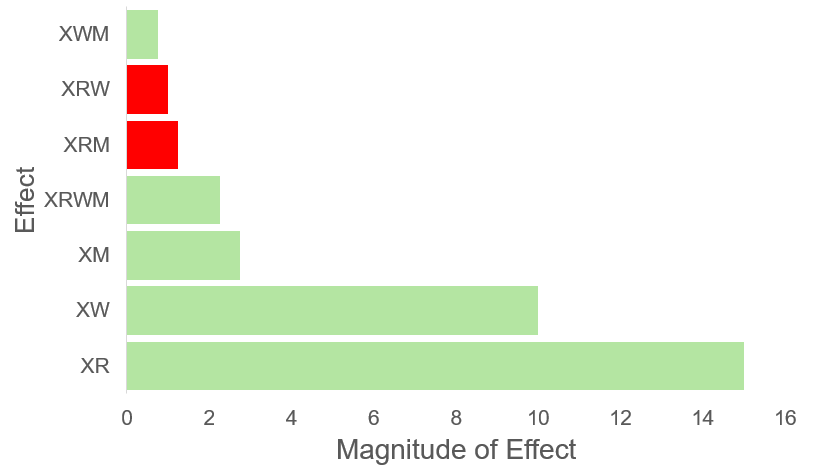

Le terme d’interaction est faible, ce qui suggère que la surface de réponse est plutôt linéaire dans cette région. La figure 9.3.2.1 illustre les contours du modèle (lignes droites vertes). Observez que les contours du modèle représentent une bonne approximation des contours réels (en pointillé, gris clair), lesquels restent inconnus en pratique.

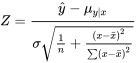

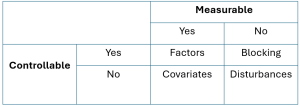

Pour accroître le profit de manière optimale, on se déplace le long de la surface du modèle estimé, dans la direction de la pente maximale. Pour obtenir cette direction, il suffit de prendre les dérivées partielles de la fonction du modèle en ignorant le terme d’interaction (qui est négligeable).

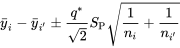

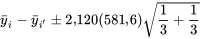

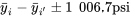

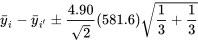

Cela signifie que pour chaque déplacement  unités codées selon

unités codées selon  , il faut égaglement faire un déplacement selon

, il faut égaglement faire un déplacement selon  de

de  unités codées. Mathématiquement :

unités codées. Mathématiquement :

Le plus simple, c’est de choisir le pas de l’une des variables, puis d’ajuster l’autre en conséquence.

Ainsi, on choisit d’augmenter de  unité codée, ce qui signifie :

unité codée, ce qui signifie :

\Delta x_{T,\text{réelle}} &= 5 \,\text{K} \\

\Delta x_S &= \frac{b_S}{b_T} \Delta x_T = \frac{134}{55} \Delta x_T \\

\text{mais comme}\qquad\qquad \Delta x_S &= \frac{x_{S,\text{réelle}}}{\Delta_S / 2} \\

\Delta x_{S,\text{réelle}} &= \frac{134}{55} \times 1 \times \Delta_S / 2\,\, \text{en comparant les deux lignes précédentes} \\

\Delta x_{S,\text{réelle}} &= \frac{134}{55} \times 1 \times 0,5 / 2 = \bf{0,61}\,\,\text{g/L}\\\end{split}\]

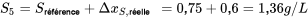

On mène donc l’expérience suivante selon ces conditions, et le profit quotidien vaut y_5 = 669 $ y_5 = 669 $. Il s’agit d’une amélioration substantielle par rapport aux conditions de référence.

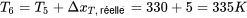

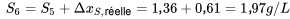

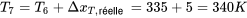

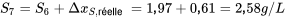

On décide d’effectuer un autre déplacement, dans la même direction de pente maximale, c’est-à-dire le long du vecteur qui pointe dans la direction  . On augmente la température de 5K (mais le pas aurait pu être plus grand ou plus petit), et on obtient les conditions suivantes pour l’expérience 6 :

. On augmente la température de 5K (mais le pas aurait pu être plus grand ou plus petit), et on obtient les conditions suivantes pour l’expérience 6 :

Cette fois, le profit est de  . La croissance se poursuit, mais dans une proportion moindre. Elle commence peut-être à se stabiliser. On décide toutefois d’encore monter la température de 5 K et d’augmenter la concentration de substrat en conséquence. On obtient ainsi les conditions suivantes pour l’expérience 7 :

. La croissance se poursuit, mais dans une proportion moindre. Elle commence peut-être à se stabiliser. On décide toutefois d’encore monter la température de 5 K et d’augmenter la concentration de substrat en conséquence. On obtient ainsi les conditions suivantes pour l’expérience 7 :

Cette fois, le profit est de  . Nous sommes allés trop loin, puisque les profits ont chuté. Il faut donc revenir au meilleur point précédent, parce que la surface a manifestement changé, et réajuster le modèle avec une nouvelle analyse factorielle dans ce voisinage :

. Nous sommes allés trop loin, puisque les profits ont chuté. Il faut donc revenir au meilleur point précédent, parce que la surface a manifestement changé, et réajuster le modèle avec une nouvelle analyse factorielle dans ce voisinage :

| Expérience | T (réelle) | S (réelle) | T (codée) | S (codée) | Profit |

|---|---|---|---|---|---|

| 6 | 335 K | 1,97 g/L | 0 | 0 | 688 $ |

| 8 | 331 K | 1,77 g/L | - | - | 694 $ |

| 9 | 339 K | 1,77 g/L | + | - | 725 $ |

| 10 | 331 K | 2,17 g/L | - | + | 620 $ |

| 11 | 339 K | 2,17 g/L | + | + | 642 $ |

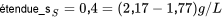

Pour se déplacer plus lentement le long de la surface, on opte pour de plus petites étendues dans la factorielle :  et

et  .

.

Un modèle des moindres carrés basé sur les quatre points factoriels (les expériences 8, 9, 10 et 11, exécutées dans un ordre aléatoire), suggère que la tendance la plus favorable serait d’augmenter la température tout en réduisant la concentration de substrat.

\hat{y} &= 673,8 + 13,25 x_T - 39,25 x_S - 2,25 x_T x_S\end{split}\]

Comme auparavant, on avance dans la direction la pente maximale en faisant un pas de  unités le long de la direction

unités le long de la direction et de

et de  unités le long de la direction

unités le long de la direction  . On choisi à nouveau

. On choisi à nouveau  unité. (Rappelons qu’on pourrait opter pour un pas plus petit ou plus grand, si nécessaire.) Par conséquent :

unité. (Rappelons qu’on pourrait opter pour un pas plus petit ou plus grand, si nécessaire.) Par conséquent :

\Delta x_S &= \frac{-39}{13} \times 1\\

\Delta x_{S, \text{réelle}} &= \frac{-39}{13} \times 1 \times 0,4 /2 = -0,6\,\text{g/L}\\

\Delta x_{T, \text{réelle}} &= 4\,\text{K}\\\end{split}\]

On détermine que le profit s’élève alors à 716 $. Or, l’analyse factorielle précédente présentait une valeur de profit de 725 $ à l’un des coins. Il se pourrait qu’il y ait du bruit dans le systèmes. En effet, la différence entre 716 $ et 725 $ ne représente pas un montant très élevé; en revanche, on observe une différence de profit relativement importante entre les autres points de l’analyse factorielle.

Quelques considérations à prendre en compte lorsqu’on s’approche d’un optimum :

- La variable de réponse atteindra un plateau (rappelez-vous qu’à un optimum, la première dérivée première vaut zéro).

- Si la variable de réponse reste à peu près constante pendant deux sauts consécutifs, vous avez peut-être dépassé l’optimum.

- La variable de réponse peut diminuer, parfois très rapidement, si vous dépassez l’optimum.

- On peut aussi déduire que la surface est courbe si les termes d’interaction sont du même ordre de grandeur (ou plus grands) que les termes d’effets principaux.

En d’autres termes, les optimums présentent une certaine courbure. Ainsi, un modèle qui ne comporte que des termes linéaires ne pourra pas vous indiquer la direction de pente maximale le long de la surface de réponse réelle. Il faut ajouter des termes qui tiennent compte de cette courbure.

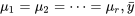

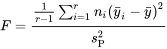

9.3.3. Vérification de la courbure

Lorsque le point de centrage mesuré diffère sensiblement du point de centrage prédit par le modèle linéaire, c’est que la surface de réponse est courbe, ce qu’il faut représenter par l’ajout de termes polynomiaux.

Le point de centrage de l’analyse factorielle peut être prédit à partir de  – c’est simplement le terme d’intersection. Dans la dernière analyse factorielle, le point de centrage prédit correspondait à

– c’est simplement le terme d’intersection. Dans la dernière analyse factorielle, le point de centrage prédit correspondait à  . Or, le point de centrage réel de l’expérience 6 affichait un profit de 688 $. Cette différence de 18 $ s’avère substantielle, surtout si on la compare aux coefficients des effets principaux.

. Or, le point de centrage réel de l’expérience 6 affichait un profit de 688 $. Cette différence de 18 $ s’avère substantielle, surtout si on la compare aux coefficients des effets principaux.

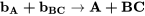

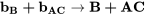

9.3.4. Plans composites centrés

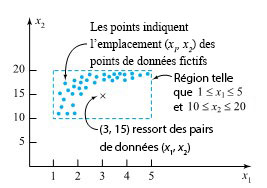

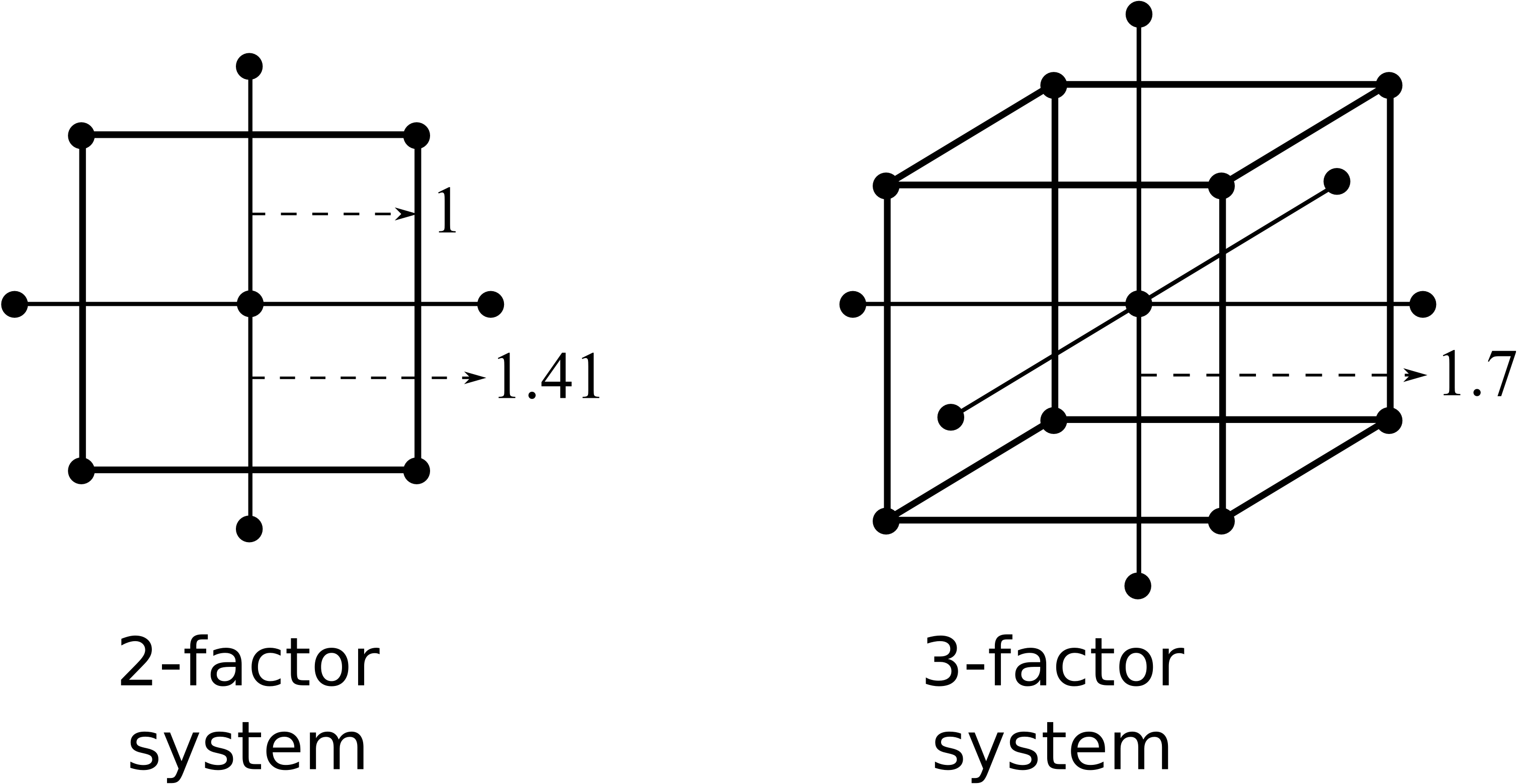

L’analyse détaillée des plans composites centrés ne sera pas abordée dans le présent manuel. Toutefois, cette partie montre quelques exemples à deux et trois variables, à partir d’une factorielle orthogonale existante à laquelle on ajoute des points axiaux. Ces points pourront être aisément ajoutés ultérieurement pour tenir compte de la non-linéarité.

Les points axiaux sont placés à  unité codée du centre pour un système à deux facteurs, et à

unité codée du centre pour un système à deux facteurs, et à  unité codée pour un système à trois facteurs.

unité codée pour un système à trois facteurs.

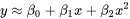

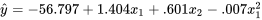

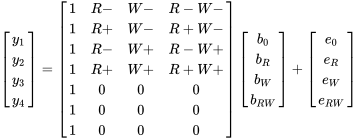

Un plan composite central a été ajouté à l’analyse factorielle dans l’exemple ci-dessus, puis les expériences ont été exécutées, de manière aléatoire, aux quatre points axiaux.

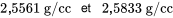

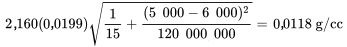

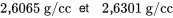

Les quatre valeurs de réponse étaient  ,

,  ,

,  et

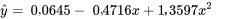

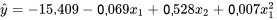

et  . Cela nous permet d’estimer un modèle contenant des termes quadratiques :

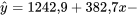

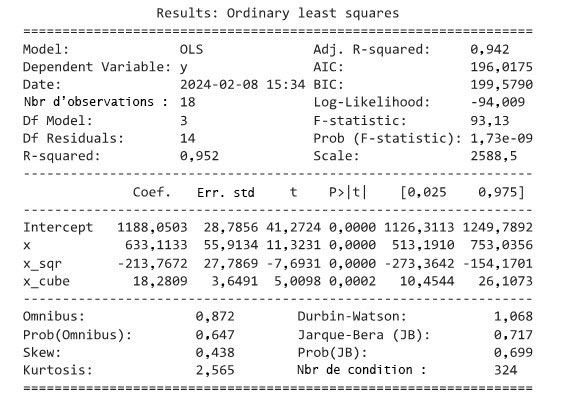

. Cela nous permet d’estimer un modèle contenant des termes quadratiques :  . Les paramètres de ce modèle s’obtiennent selon la procédure habituelle, en utilisant un modèle des moindres carrés :

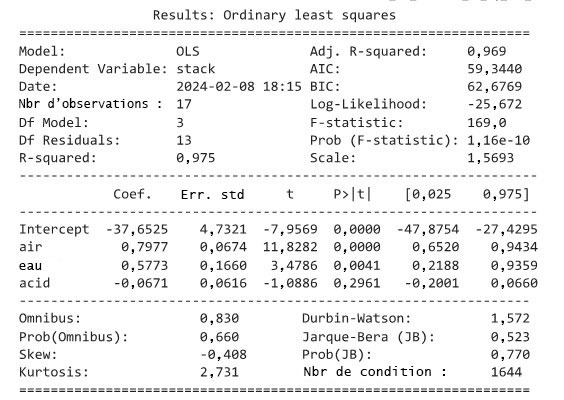

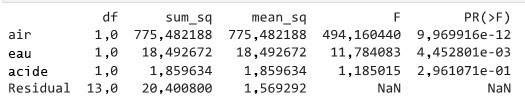

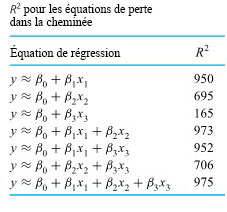

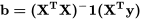

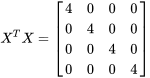

. Les paramètres de ce modèle s’obtiennent selon la procédure habituelle, en utilisant un modèle des moindres carrés :

Remarquez que les termes linéaires sont identiques à ce qu’on avait auparavant! Les effets quadratiques se révèlent assez significatifs par rapport aux autres effets; en effet, c’est ce qui a empêché le modèle linéaire de prédire le résultat de l’expérience 12.

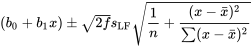

La dernière étape de la méthodologie des surfaces de réponse consiste à tracer le contour de ce modèle et à prédire où exécuter les prochaines expériences. Comme le démontrent les lignes continues de contour dans l’illustration, il faudrait exécuter les prochaines expériences approximativement à T = 343K et à S = 1,60 g/L, où le profit escompté avoisine 736 $. (Ces valeurs peuvent être obtenues de manière approximative par un examen visuel, ou de manière analytique.) Le véritable optimum du processus ne se situe pas exactement là, mais il s’en rapproche beaucoup.

Cet exemple a démontré toute la puissance de la méthode des surfaces de réponse. Un nombre minimal d’expériences a rapidement convergé vers le véritable optimum (qui était inconnu) du processus. Pour y parvenir, nous avons établi une succession de modèles des moindres carrés permettant d’obtenir une approximation de la surface sous-jacente. Ces modèles des moindres carrés se construisent avec les outils des analyse factorielles fractionnaires et complètes, ainsi qu’avec les fondements de l’optimisation. Ainsi, sommes en mesure de gravir la pente maximale.

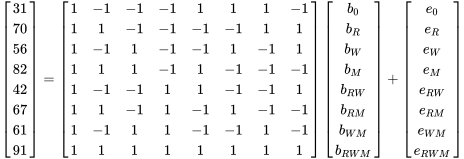

=

=

, un objet initialement au repos en chute libre se déplacera à la vitesse

, un objet initialement au repos en chute libre se déplacera à la vitesse =

=

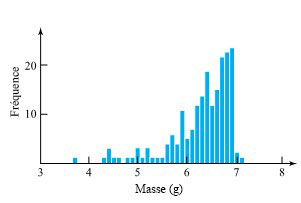

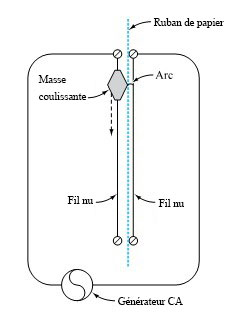

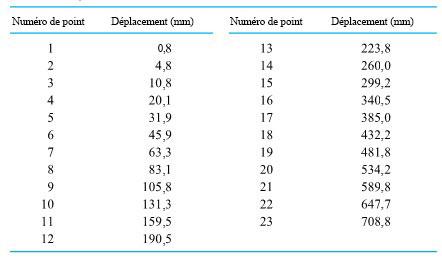

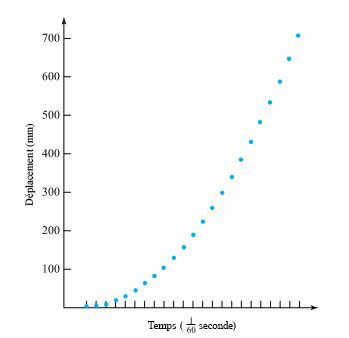

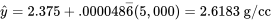

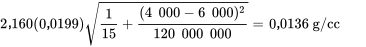

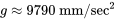

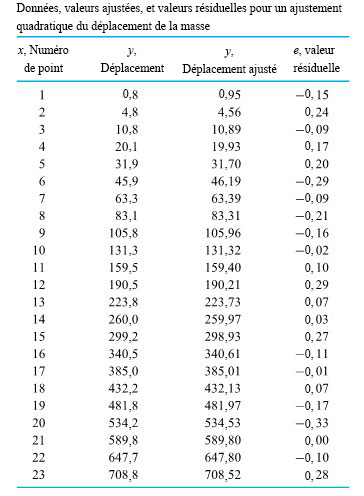

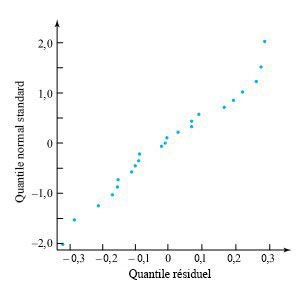

d’une seconde. Le tableau 1.1.7.1 répertorie les mesures de ces positions. (Le ruban a été fourni par Frank Peterson, du département de physique et d’astronomie de l’ISU.) Le tracé des positions de la masse dans le tableau à intervalles égaux produit le tracé approximativement quadratique illustré à la figure 1.1.7.2. Pour obtenir la valeur de

d’une seconde. Le tableau 1.1.7.1 répertorie les mesures de ces positions. (Le ruban a été fourni par Frank Peterson, du département de physique et d’astronomie de l’ISU.) Le tracé des positions de la masse dans le tableau à intervalles égaux produit le tracé approximativement quadratique illustré à la figure 1.1.7.2. Pour obtenir la valeur de  /

/ pour g, très proche de la valeur communément admise de 9,8

pour g, très proche de la valeur communément admise de 9,8

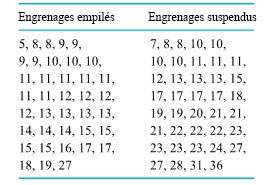

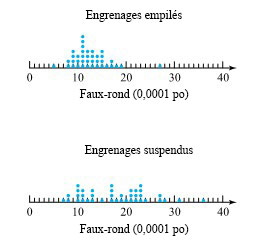

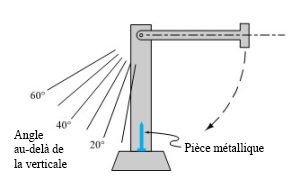

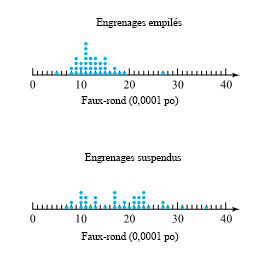

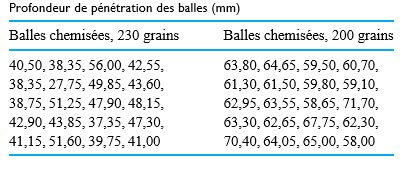

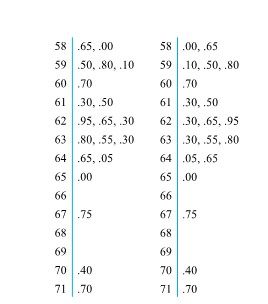

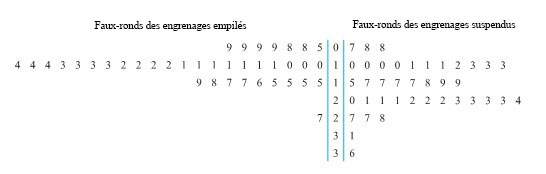

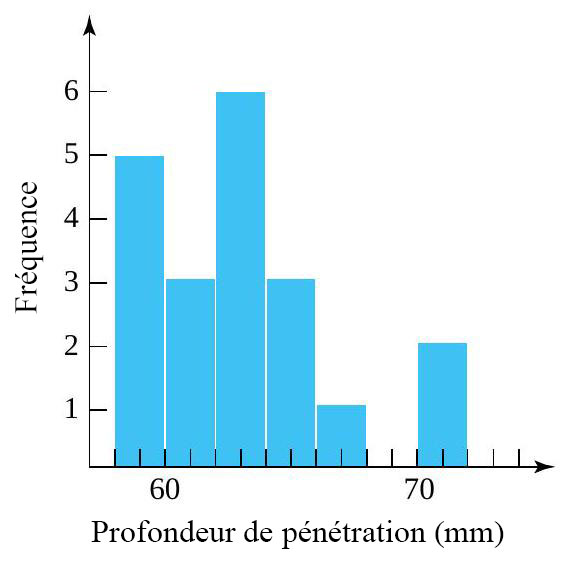

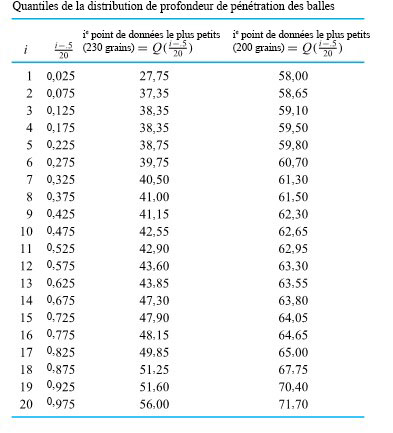

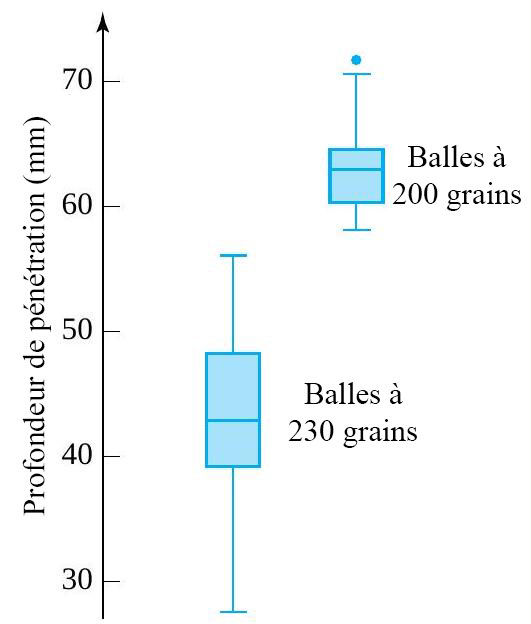

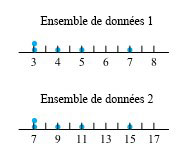

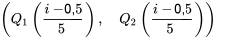

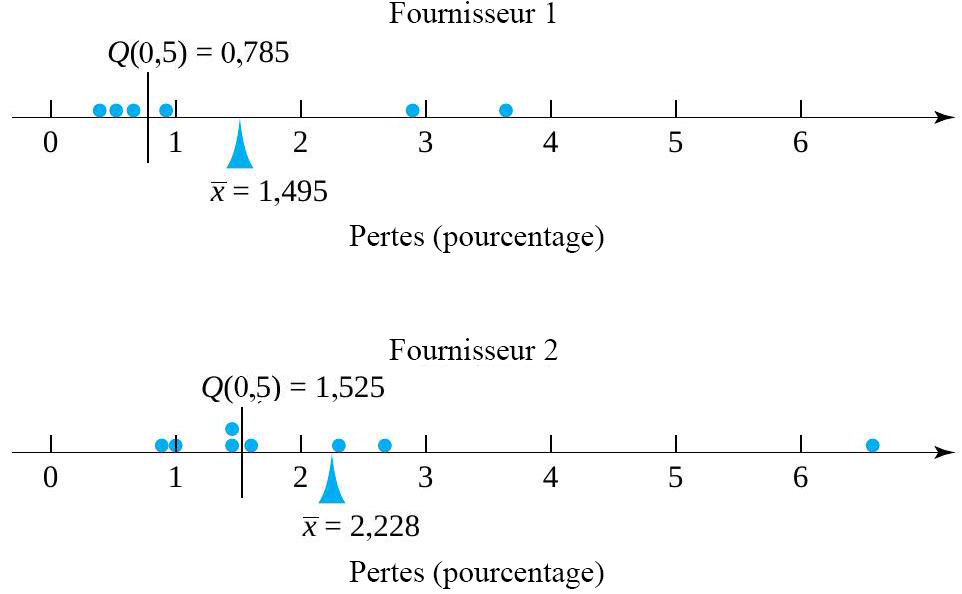

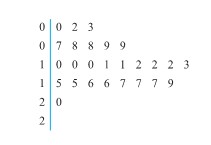

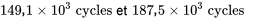

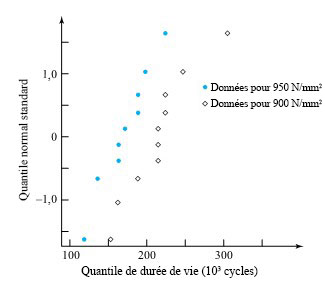

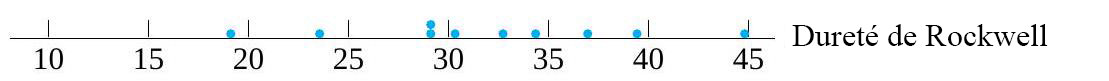

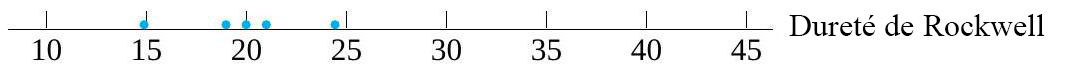

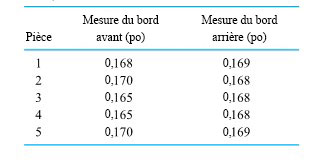

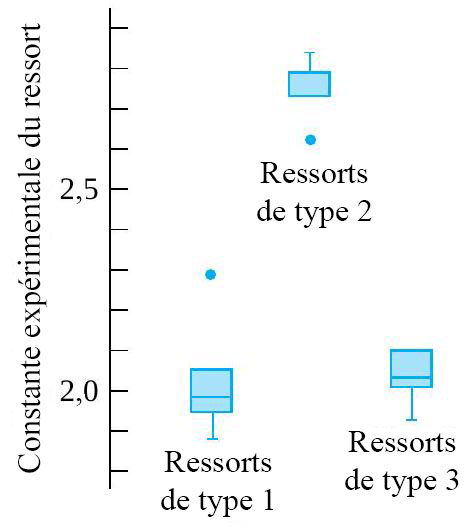

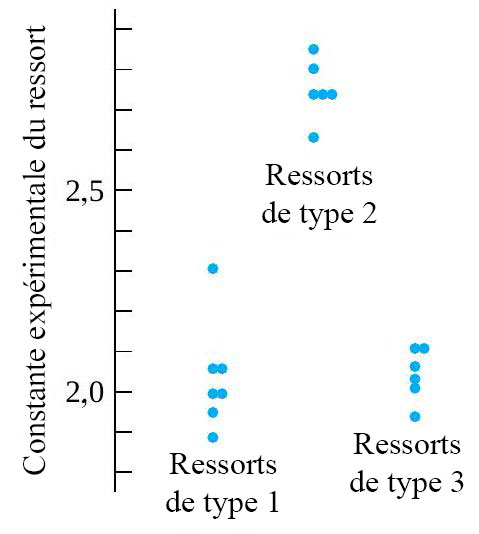

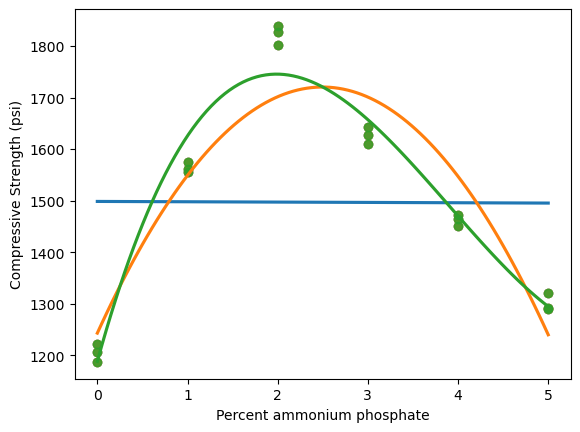

de la surface de la cible jusqu’à l’arrière des balles) pour deux types de balles. La figure 2.1.2.2 présente une paire de diagrammes à points correspondants.

de la surface de la cible jusqu’à l’arrière des balles) pour deux types de balles. La figure 2.1.2.2 présente une paire de diagrammes à points correspondants.

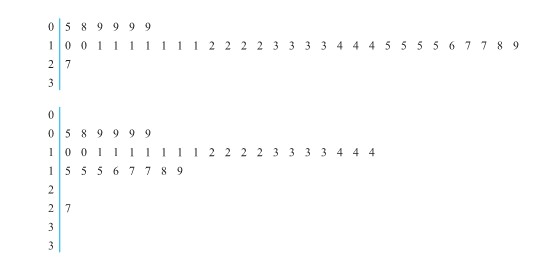

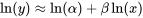

» et «

» et «  » pour chaque premier chiffre possible, au lieu d’une seule feuille «

» pour chaque premier chiffre possible, au lieu d’une seule feuille «  » pour chaque premier chiffre.

» pour chaque premier chiffre.

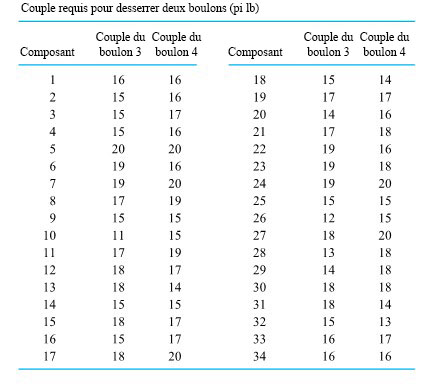

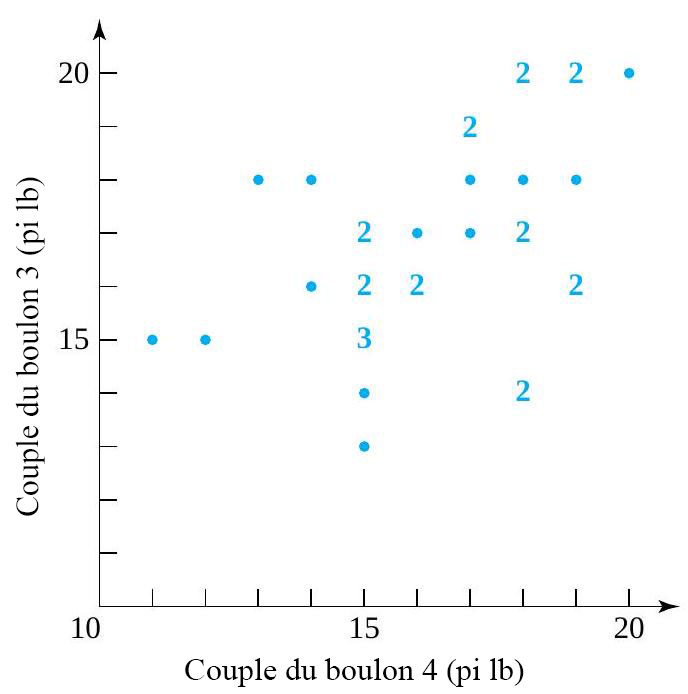

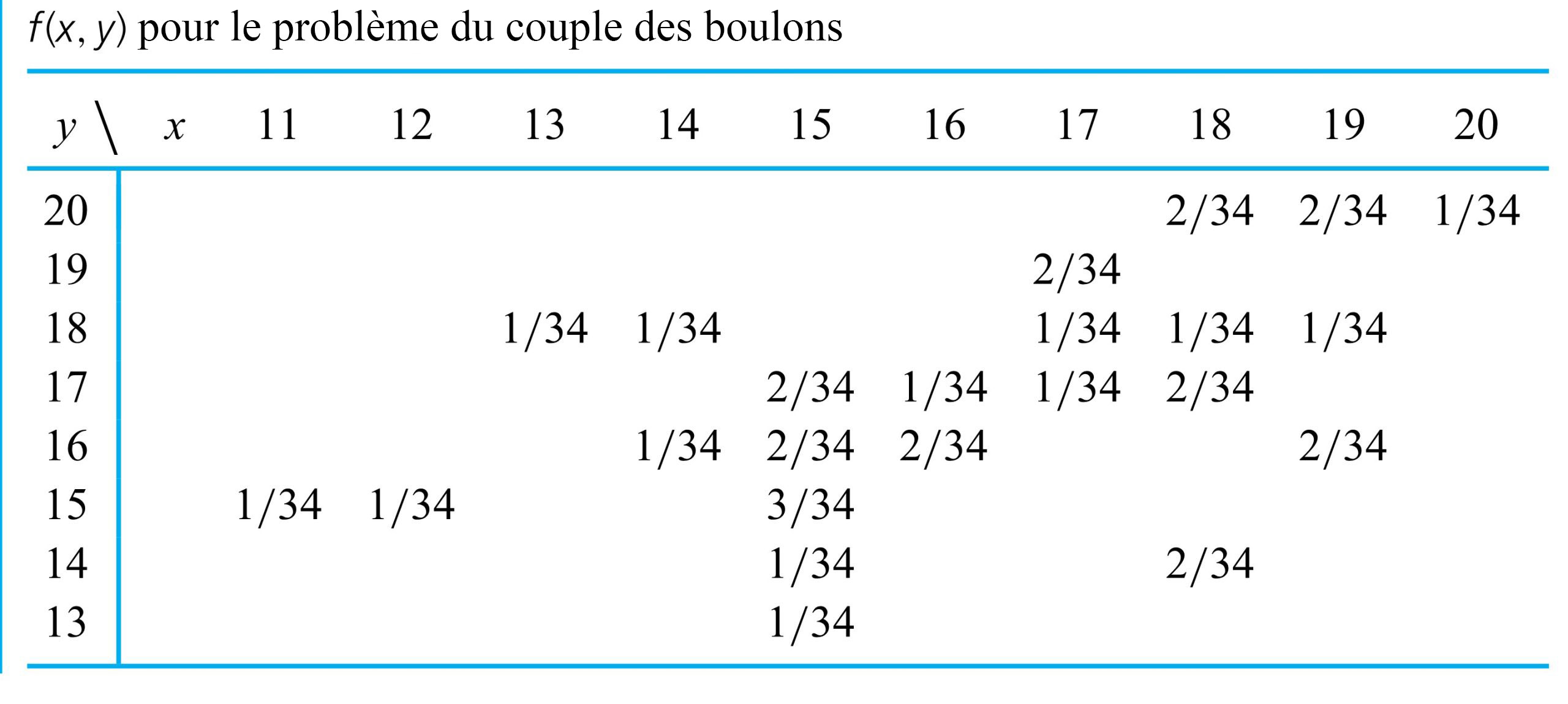

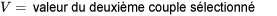

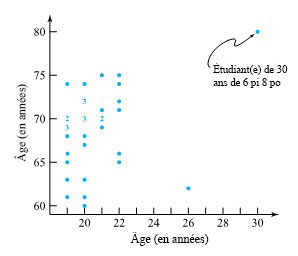

) requis pour les boulons numéros 3 et 4, respectivement, sur 34 composants différents. La figure 2.1.4.1 illustre un diagramme de dispersion des données à deux variables du tableau 2.1.4.1. Dans cette figure, s’il y avait plus d’un point au même endroit, on a indiqué le nombre de points à cet endroit.

) requis pour les boulons numéros 3 et 4, respectivement, sur 34 composants différents. La figure 2.1.4.1 illustre un diagramme de dispersion des données à deux variables du tableau 2.1.4.1. Dans cette figure, s’il y avait plus d’un point au même endroit, on a indiqué le nombre de points à cet endroit.

des personnes qui ont passé l’examen ont obtenu une moins bonne note, et

des personnes qui ont passé l’examen ont obtenu une moins bonne note, et  ont obtenu une meilleure note. Ce concept est également utile pour décrire des données d’ingénierie. Toutefois, comme il est souvent plus pratique de travailler en termes de fractions entre 0 et 1 plutôt qu’en termes de pourcentages entre 0 et 100, on utilisera une terminologie légèrement différente : on parlera de « quantiles » plutôt que de rang centiles. Après avoir soigneusement défini les quantiles d’un ensemble de données, on les utilise pour créer divers outils utiles de statistiques descriptives : diagrammes quantile, diagrammes en boîte, diagrammes

ont obtenu une meilleure note. Ce concept est également utile pour décrire des données d’ingénierie. Toutefois, comme il est souvent plus pratique de travailler en termes de fractions entre 0 et 1 plutôt qu’en termes de pourcentages entre 0 et 100, on utilisera une terminologie légèrement différente : on parlera de « quantiles » plutôt que de rang centiles. Après avoir soigneusement défini les quantiles d’un ensemble de données, on les utilise pour créer divers outils utiles de statistiques descriptives : diagrammes quantile, diagrammes en boîte, diagrammes  , et diagrammes normaux (un type de diagramme

, et diagrammes normaux (un type de diagramme  compris entre 0 et 1 , le quantile

compris entre 0 et 1 , le quantile  , à droite. Toutefois, en raison du caractère discret des ensembles finis de données, il est nécessaire d’indiquer exactement ce que l’on veut dire par là. La définition 1 donne la convention qui sera utilisée dans ce texte.

, à droite. Toutefois, en raison du caractère discret des ensembles finis de données, il est nécessaire d’indiquer exactement ce que l’on veut dire par là. La définition 1 donne la convention qui sera utilisée dans ce texte. valeurs ordonnées

valeurs ordonnées  ,

, pour un entier positif

pour un entier positif  , le quantile

, le quantile

.)

.) et

et  qui n’est pas de la forme

qui n’est pas de la forme  entier, le quantile

entier, le quantile  avec les valeurs

avec les valeurs  .

. et

et  . Pour trouver

. Pour trouver  , ce qui donne

, ce qui donne

e point de données ordonnées ».

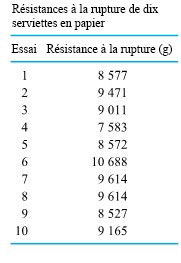

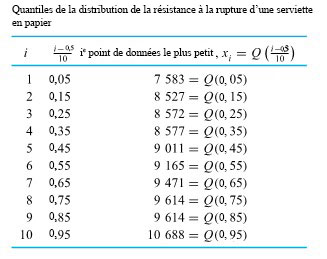

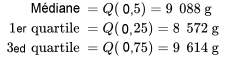

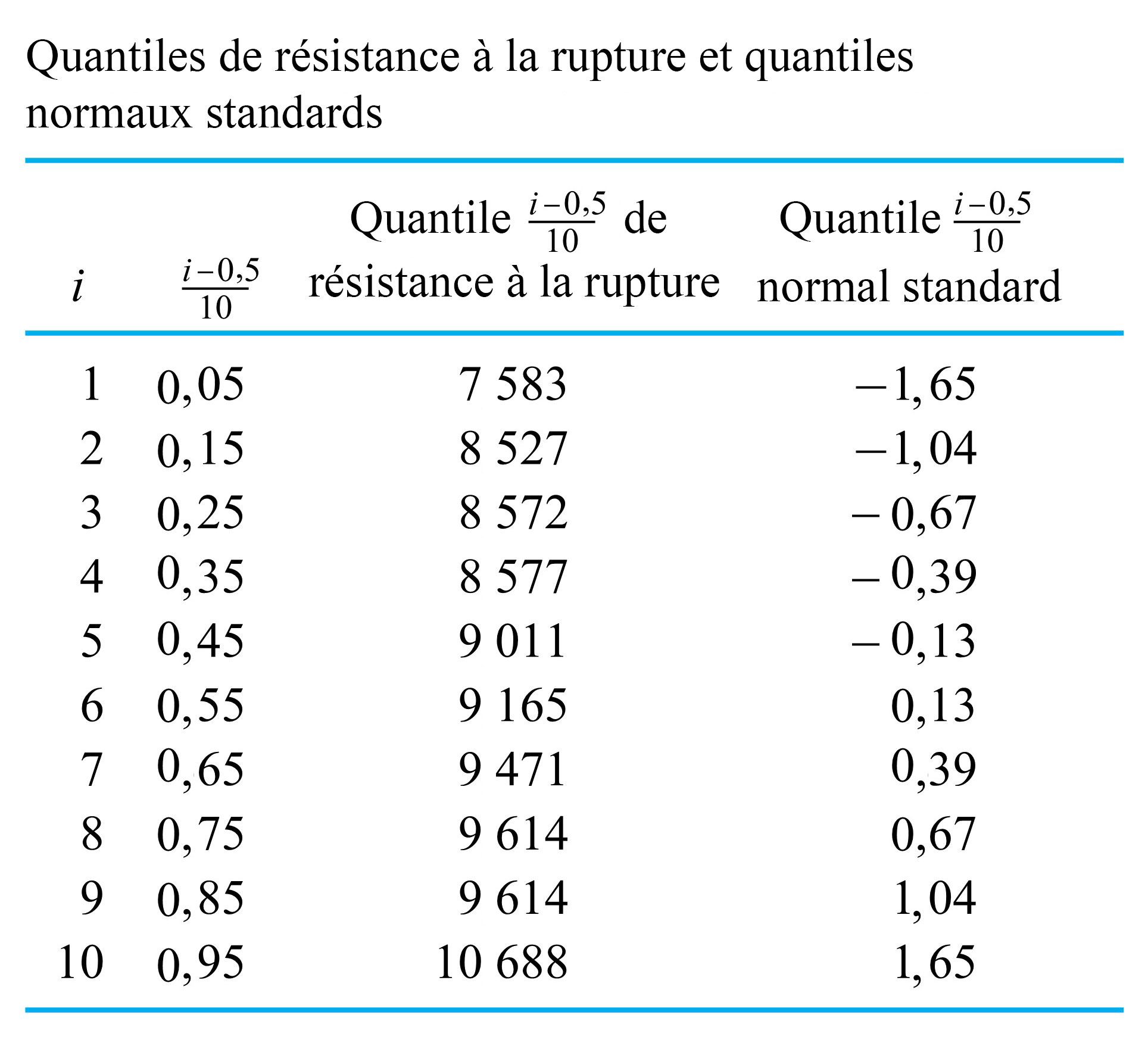

e point de données ordonnées ». , il est facile de trouver les quantiles d’ordre

, il est facile de trouver les quantiles d’ordre  et 0,95 de la répartition de la force de rupture, comme illustré au tableau 2.1.5.2.

et 0,95 de la répartition de la force de rupture, comme illustré au tableau 2.1.5.2.

points de données, chacun d’eux compte pour

points de données, chacun d’eux compte pour  de l’ensemble de données. Appliquons la convention (1) de la définition 3.1.5.1 pour trouver le quantile d’ordre 0,35 (par exemple). Les trois points de données les plus petits et la moitié du quatrième plus petit sont considérés comme se trouvant à gauche du nombre souhaité, et les six points de données les plus grands et la moitié du septième plus grand sont considérés comme se trouvant à droite. Ainsi, le quatrième point de données le plus petit doit être le quantile d’ordre 0,35, comme le montre le tableau 2.1.5.2.

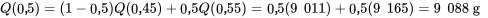

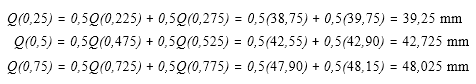

de l’ensemble de données. Appliquons la convention (1) de la définition 3.1.5.1 pour trouver le quantile d’ordre 0,35 (par exemple). Les trois points de données les plus petits et la moitié du quatrième plus petit sont considérés comme se trouvant à gauche du nombre souhaité, et les six points de données les plus grands et la moitié du septième plus grand sont considérés comme se trouvant à droite. Ainsi, le quatrième point de données le plus petit doit être le quantile d’ordre 0,35, comme le montre le tableau 2.1.5.2. unité à mi-chemin entre 0,45 et 0,55, l’interpolation linéaire donne :

unité à mi-chemin entre 0,45 et 0,55, l’interpolation linéaire donne :

unité à mi-chemin entre 0,85 et 0,93, l’interpolation linéaire donne :

unité à mi-chemin entre 0,85 et 0,93, l’interpolation linéaire donne :

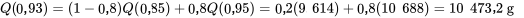

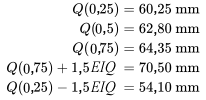

est la médiane de la distribution.

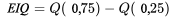

est la médiane de la distribution. et

et  sont respectivement le premier et le troisième quartiles d’une distribution.

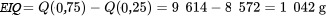

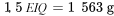

sont respectivement le premier et le troisième quartiles d’une distribution. précédemment calculée, pour la distribution de la force de rupture, on a :

précédemment calculée, pour la distribution de la force de rupture, on a :

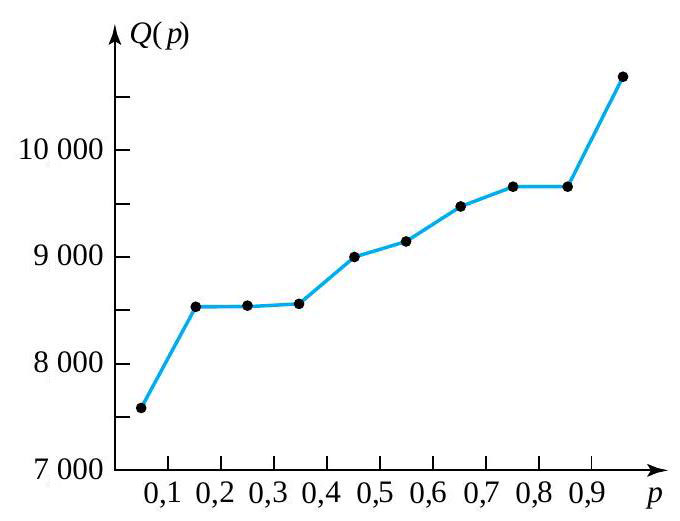

puis en reliant les points consécutifs par des segments de droite.

puis en reliant les points consécutifs par des segments de droite.

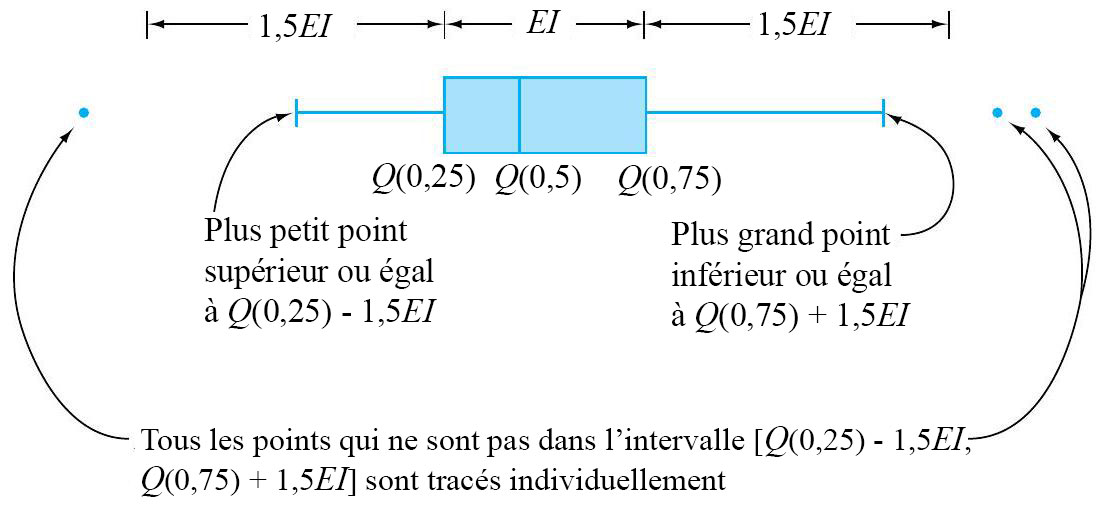

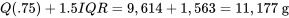

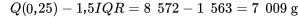

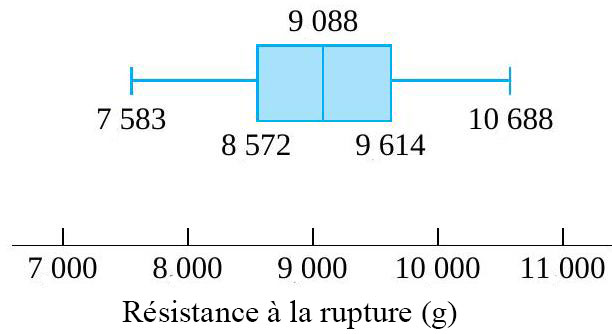

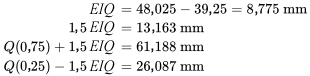

et le plus grand point des données située dans un intervalle de 1,5 EI de

et le plus grand point des données située dans un intervalle de 1,5 EI de ![[Q(0,25) - 1,5 E I, Q(0,75) + 1,5 E I] [Q(0,25) - 1,5 E I, Q(0,75) + 1,5 E I]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/826032d6cf208e4dadb71f9671c43480.png) . Ceux qui ne le sont pas sont ajoutés individuellement, ce qui indique qu’il s’agit de valeurs aberrantes ou inhabituelles.

. Ceux qui ne le sont pas sont ajoutés individuellement, ce qui indique qu’il s’agit de valeurs aberrantes ou inhabituelles.

to

to  , le diagramme en boîtes ressemble donc à la figure 2.1.6.2.

, le diagramme en boîtes ressemble donc à la figure 2.1.6.2.

du milieu de la distribution, et les moustaches. Certains éléments de la forme de la distribution sont indiqués par la symétrie (ou l’asymétrie) de la boîte et des moustaches. En outre, un espace entre l’extrémité d’une moustache et un point individuel rappelle qu’il n’y a aucune autre valeur dans cet intervalle.

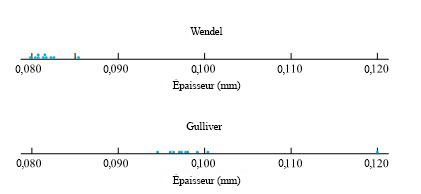

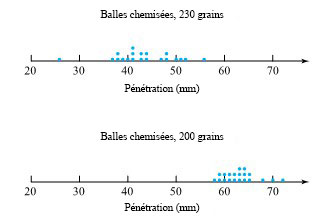

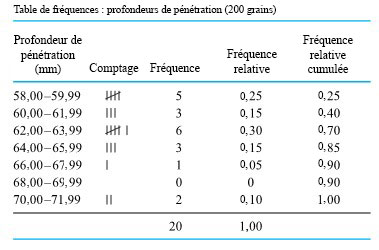

du milieu de la distribution, et les moustaches. Certains éléments de la forme de la distribution sont indiqués par la symétrie (ou l’asymétrie) de la boîte et des moustaches. En outre, un espace entre l’extrémité d’une moustache et un point individuel rappelle qu’il n’y a aucune autre valeur dans cet intervalle. des deux distributions de profondeur de pénétration des balles présentées à la section précédente. Pour les profondeurs de pénétration des balles de 230 grains, l’interpolation donne

des deux distributions de profondeur de pénétration des balles présentées à la section précédente. Pour les profondeurs de pénétration des balles de 230 grains, l’interpolation donne

.

. e plus petite valeur de l’ensemble de données 1

e plus petite valeur de l’ensemble de données 1

et

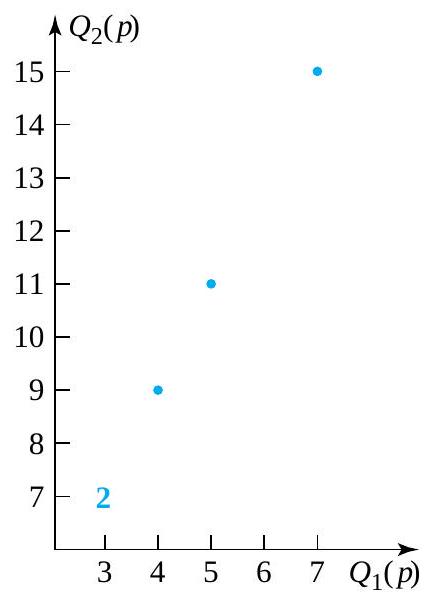

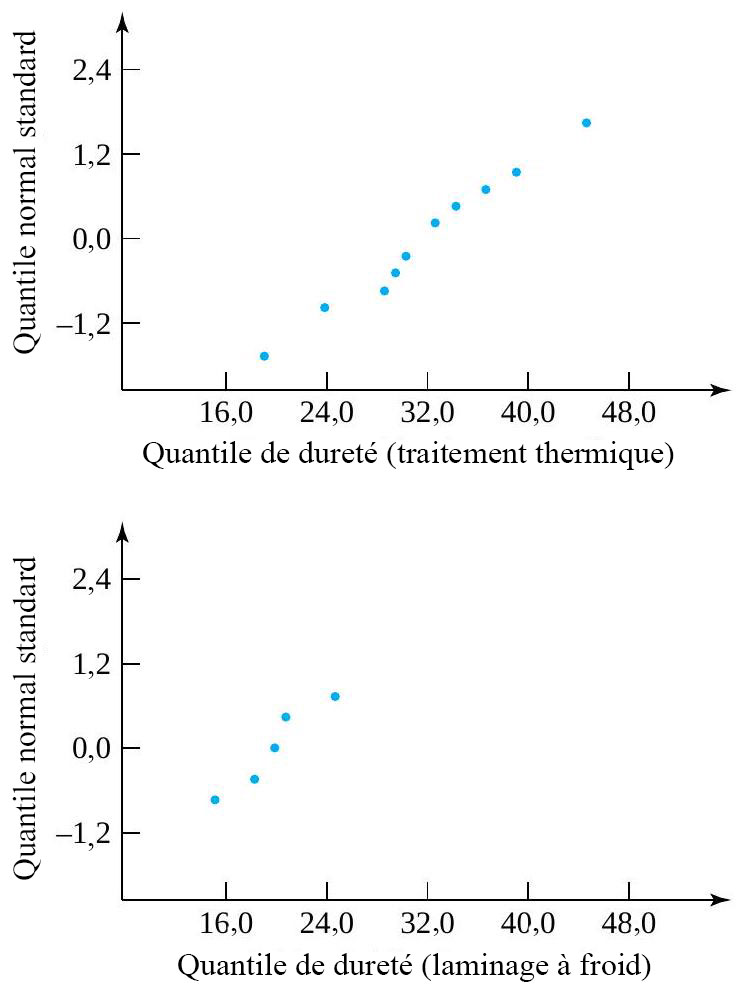

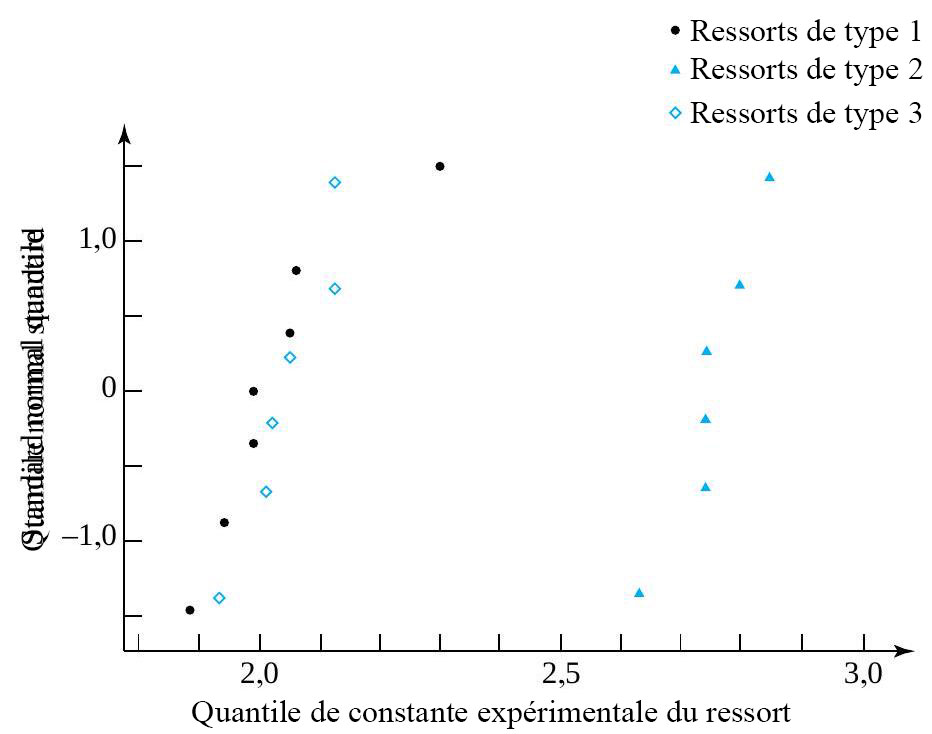

et  représenter les fonctions de quantiles des deux ensembles de données, on voit clairement à la figure 2.1.7.1 que

représenter les fonctions de quantiles des deux ensembles de données, on voit clairement à la figure 2.1.7.1 que

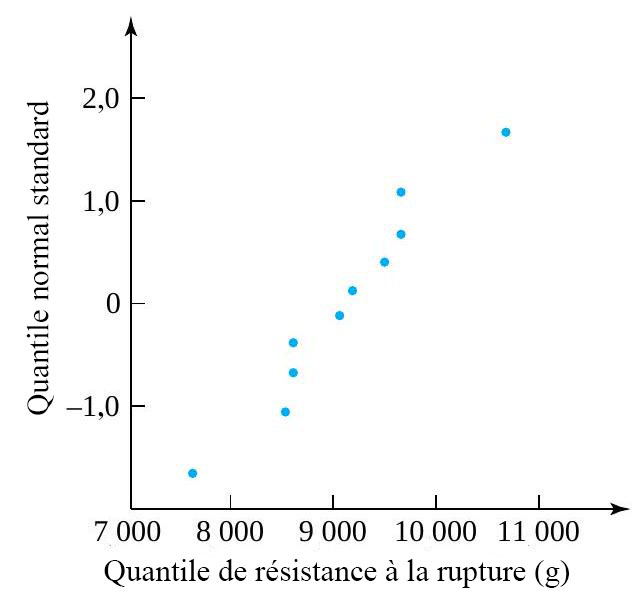

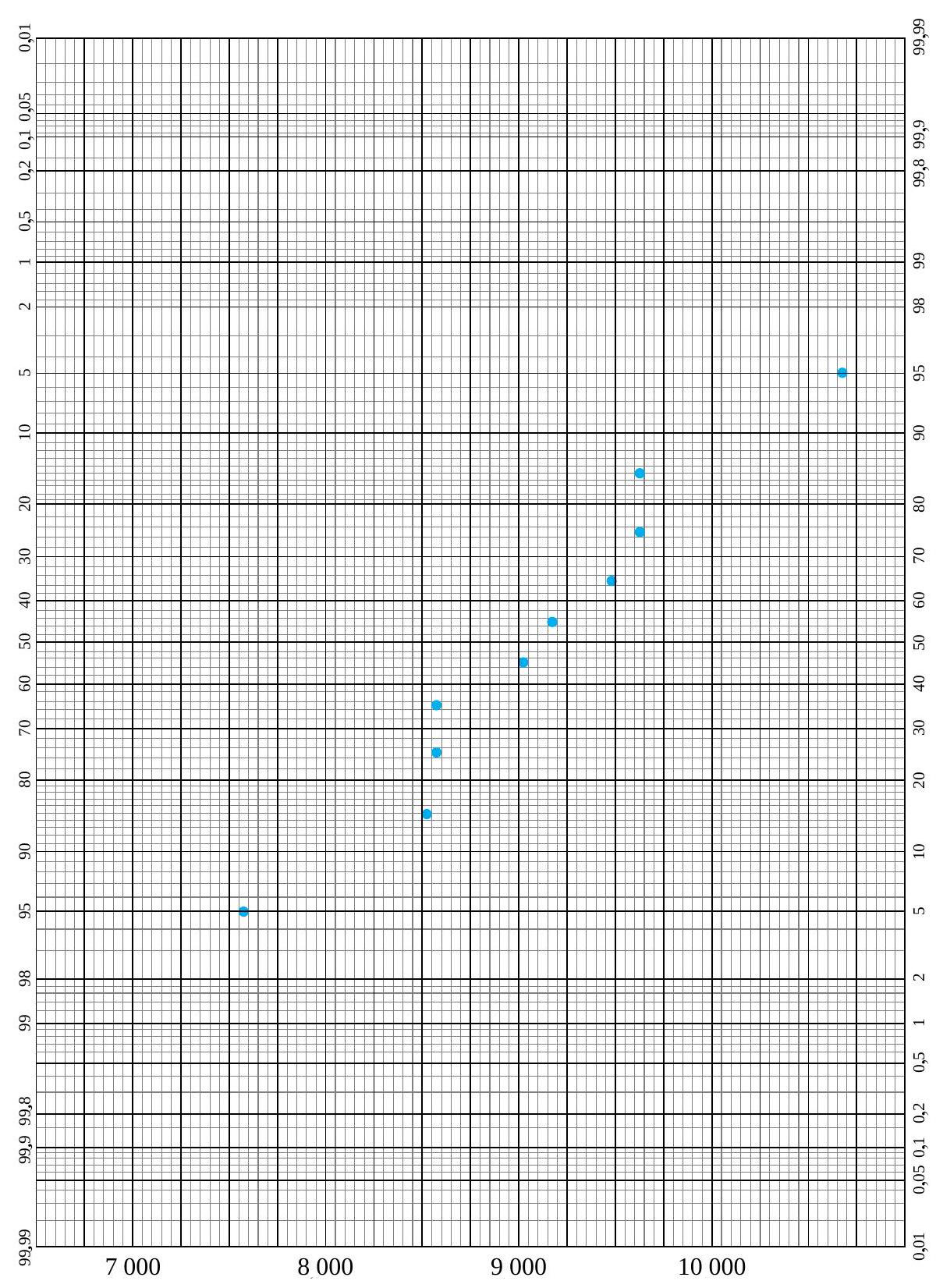

) devrait être exactement linéaire. La figure 2.1.7.2 illustre cela – en fait la figure 2.1.7.2 est un diagramme

) devrait être exactement linéaire. La figure 2.1.7.2 illustre cela – en fait la figure 2.1.7.2 est un diagramme  pour les valeurs appropriées de

pour les valeurs appropriées de  . Lorsque les ensembles de données sont de taille inégale, les valeurs de

. Lorsque les ensembles de données sont de taille inégale, les valeurs de  et

et  (pour les données des balles à 230 grains) est disproportionné par rapport à l’écart entre 63,55 et

(pour les données des balles à 230 grains) est disproportionné par rapport à l’écart entre 63,55 et  (pour les données des balles à 200 grains). Cela laisse supposer qu’il existe une différence physique fondamentale dans les mécanismes ayant causé la dispersion des données de profondeur des balles à 230 grains. Les statistiques peuvent révéler ce genre d’indice, mais pour expliquer les causes, il faut faire appel à des spécialistes de la balistique ou des matériaux.

(pour les données des balles à 200 grains). Cela laisse supposer qu’il existe une différence physique fondamentale dans les mécanismes ayant causé la dispersion des données de profondeur des balles à 230 grains. Les statistiques peuvent révéler ce genre d’indice, mais pour expliquer les causes, il faut faire appel à des spécialistes de la balistique ou des matériaux. , il existe également une différence importante dans la forme des extrémités inférieures des deux distributions. Pour remettre ce point en ligne avec le reste des points tracés, il faudrait le déplacer vers la droite (augmenter la plus petite donnée des balles à 230 grains) ou vers le bas (diminuer la plus petite observation des balles à 200 grains). En d’autres termes, par rapport à la distribution des balles à 200 grains, la distribution des balles à 230 grains présente une longue queue inférieure. (Ou, autrement dit, par rapport à la distribution des balles à 230 grains, la distribution des balles à 200 grains a une queue inférieure courte.) À noter que la différence de forme était déjà évidente dans le diagramme en boîte de la figure précédente. Encore une fois, il faudrait un spécialiste pour expliquer cette différence dans les formes de distribution.

, il existe également une différence importante dans la forme des extrémités inférieures des deux distributions. Pour remettre ce point en ligne avec le reste des points tracés, il faudrait le déplacer vers la droite (augmenter la plus petite donnée des balles à 230 grains) ou vers le bas (diminuer la plus petite observation des balles à 200 grains). En d’autres termes, par rapport à la distribution des balles à 200 grains, la distribution des balles à 230 grains présente une longue queue inférieure. (Ou, autrement dit, par rapport à la distribution des balles à 230 grains, la distribution des balles à 200 grains a une queue inférieure courte.) À noter que la différence de forme était déjà évidente dans le diagramme en boîte de la figure précédente. Encore une fois, il faudrait un spécialiste pour expliquer cette différence dans les formes de distribution.

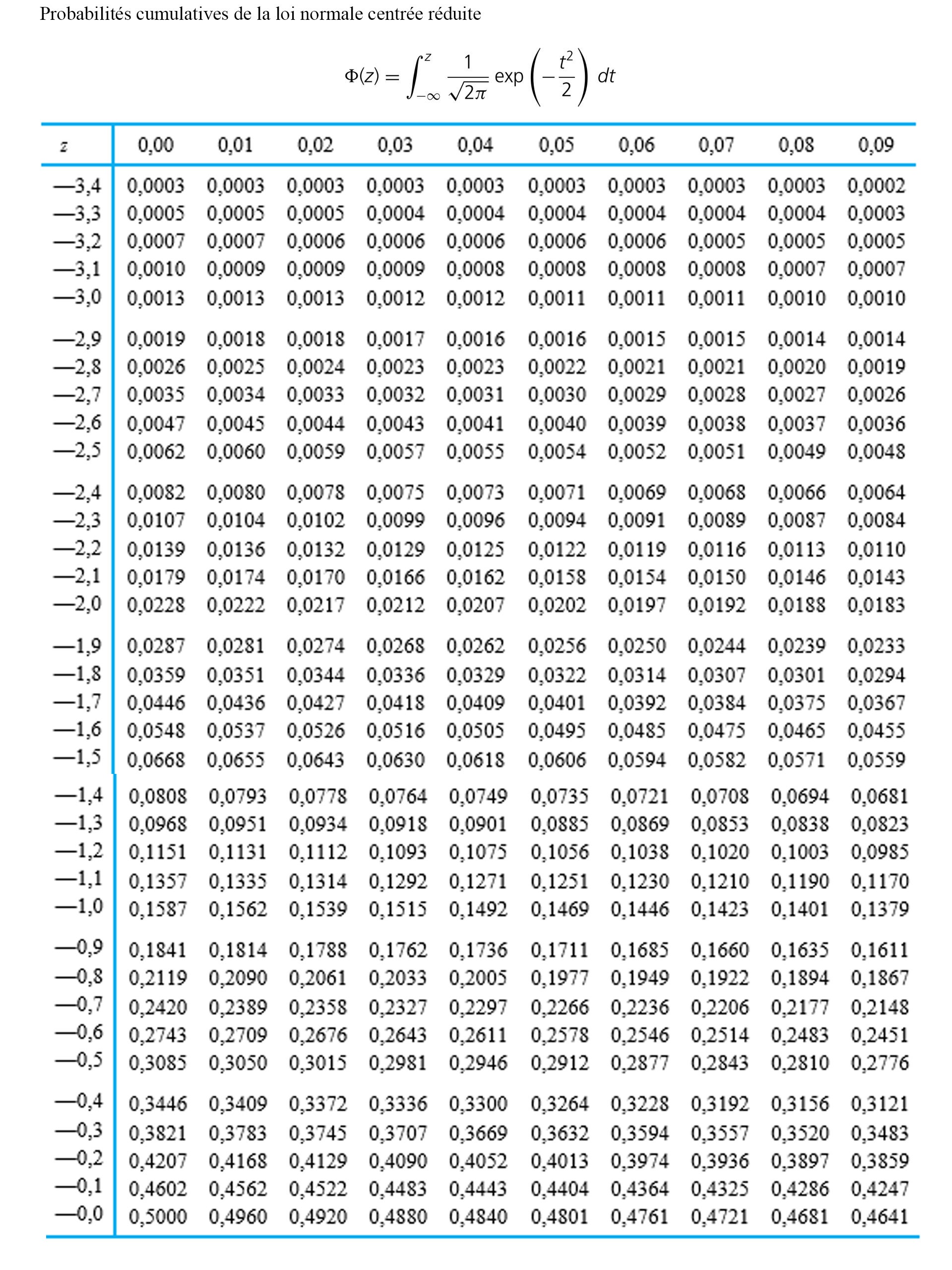

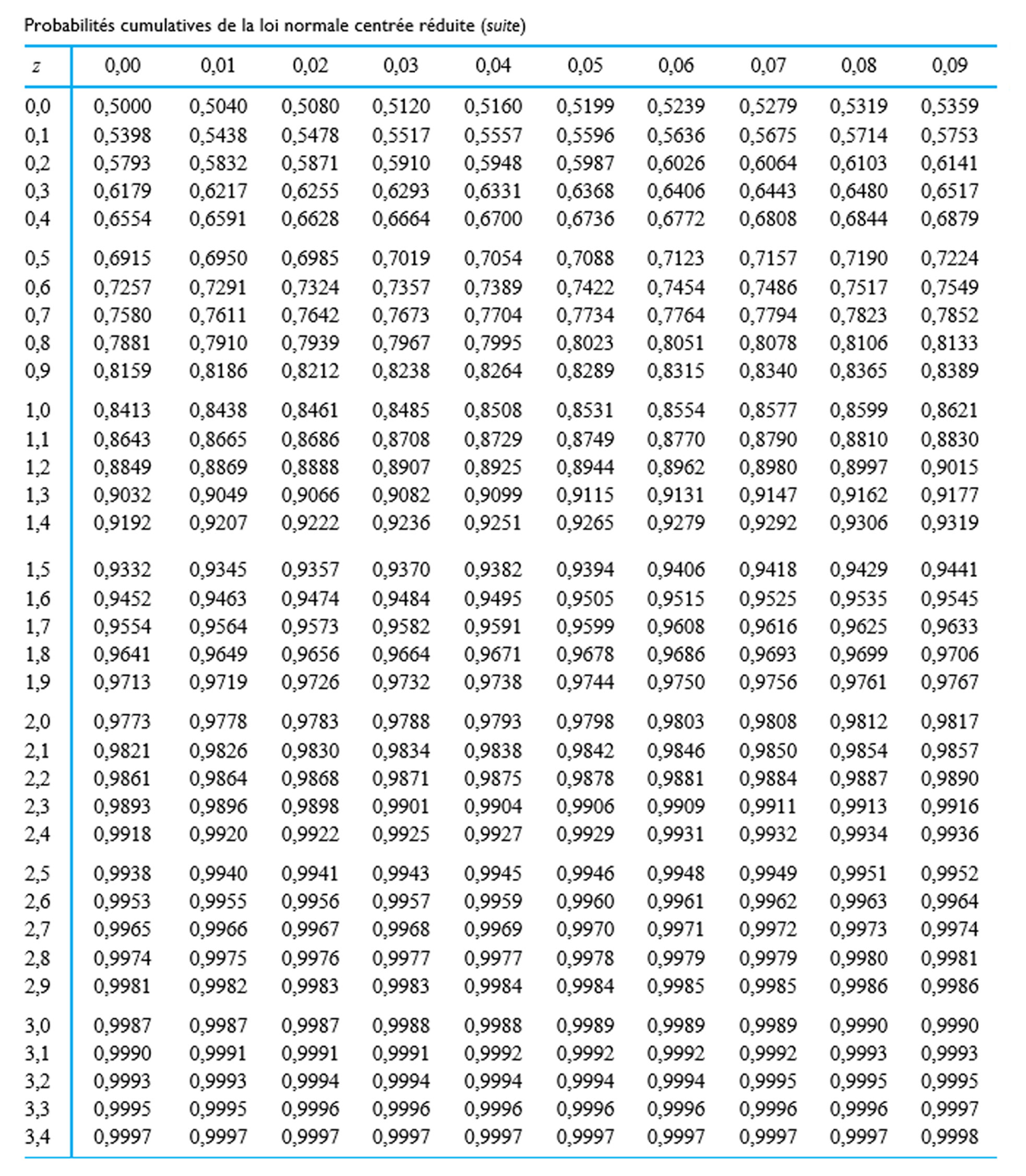

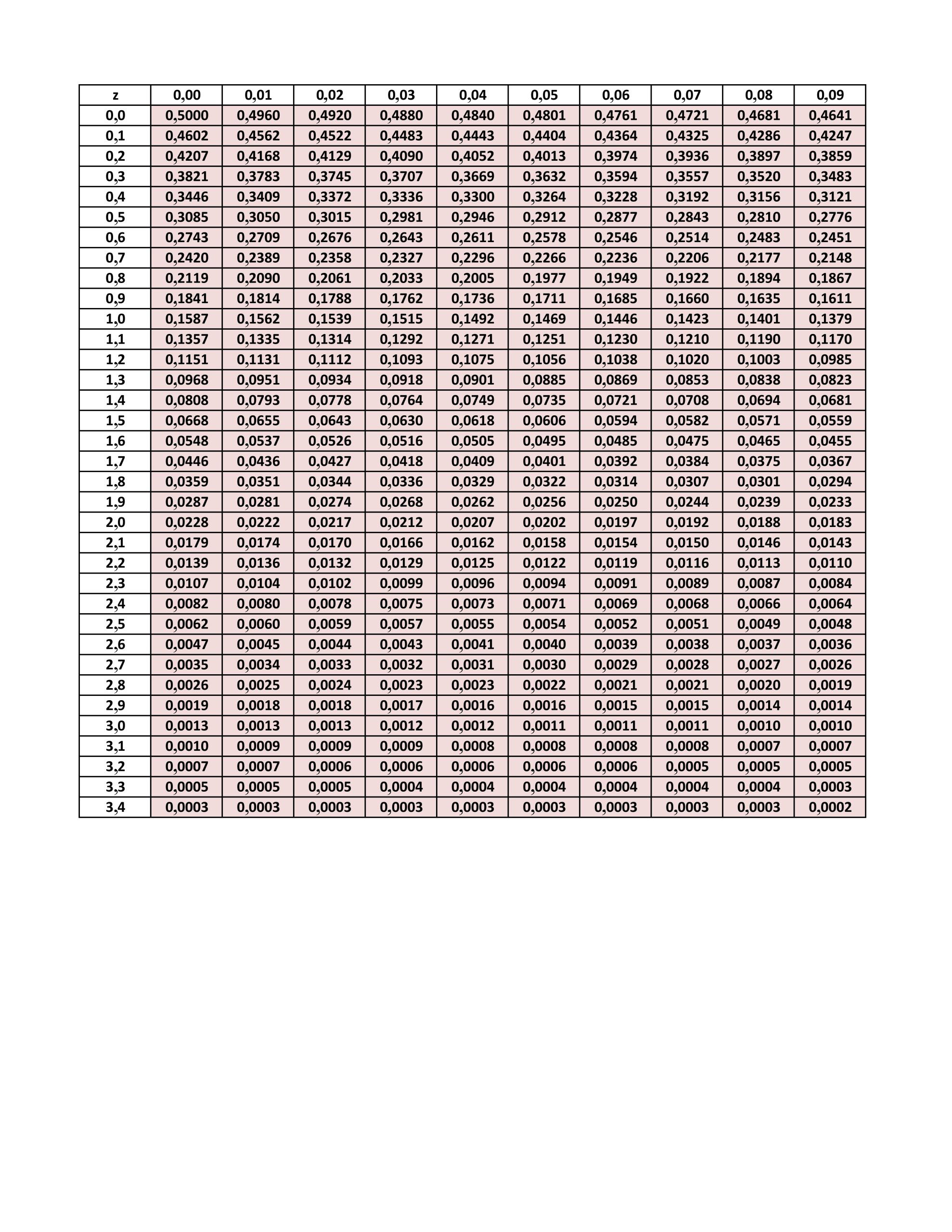

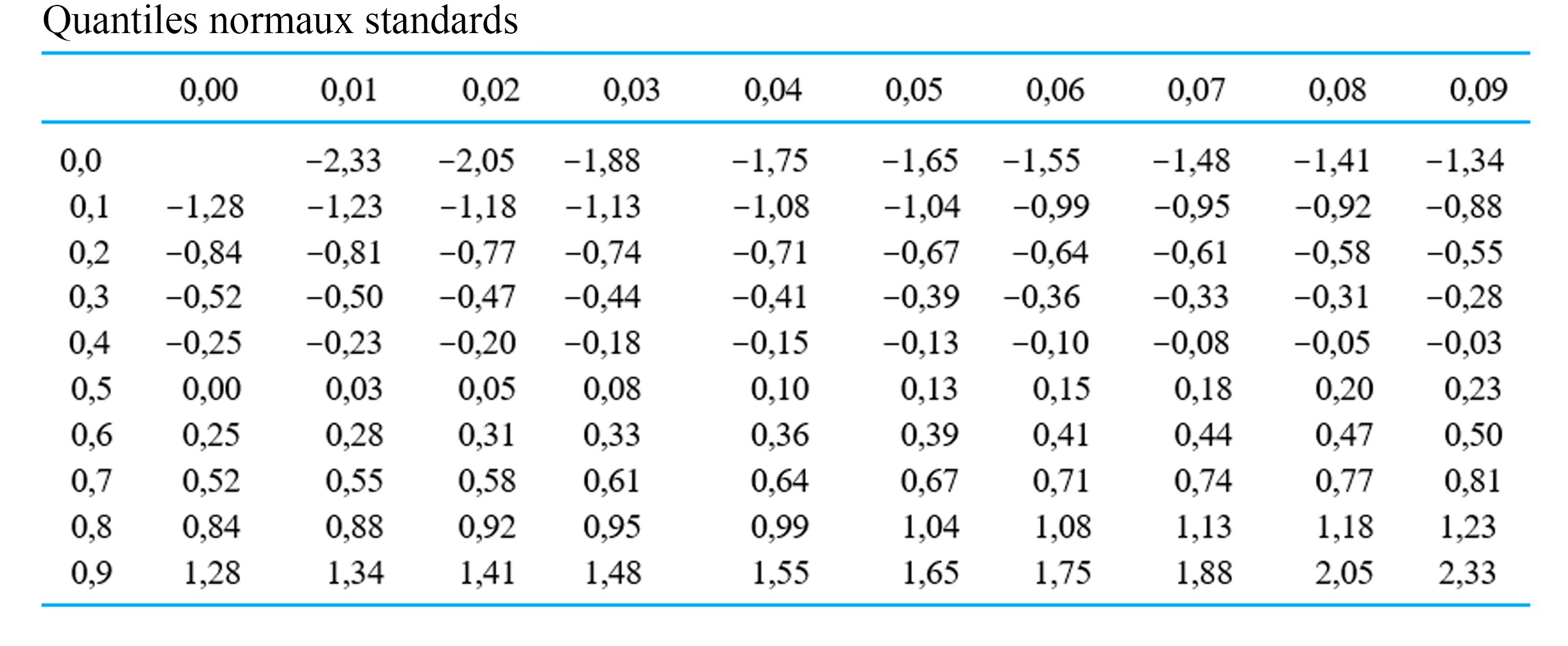

, on repère la ligne correspondant au premier chiffre après la décimale et la colonne correspondant au deuxième chiffre après la décimale. (Par exemple,

, on repère la ligne correspondant au premier chiffre après la décimale et la colonne correspondant au deuxième chiffre après la décimale. (Par exemple,  .) Pour approximer les valeurs du tableau 2.1.7.2, on peut utiliser la relation suivante :

.) Pour approximer les valeurs du tableau 2.1.7.2, on peut utiliser la relation suivante :

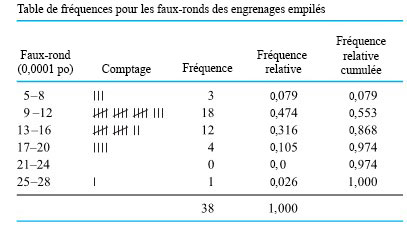

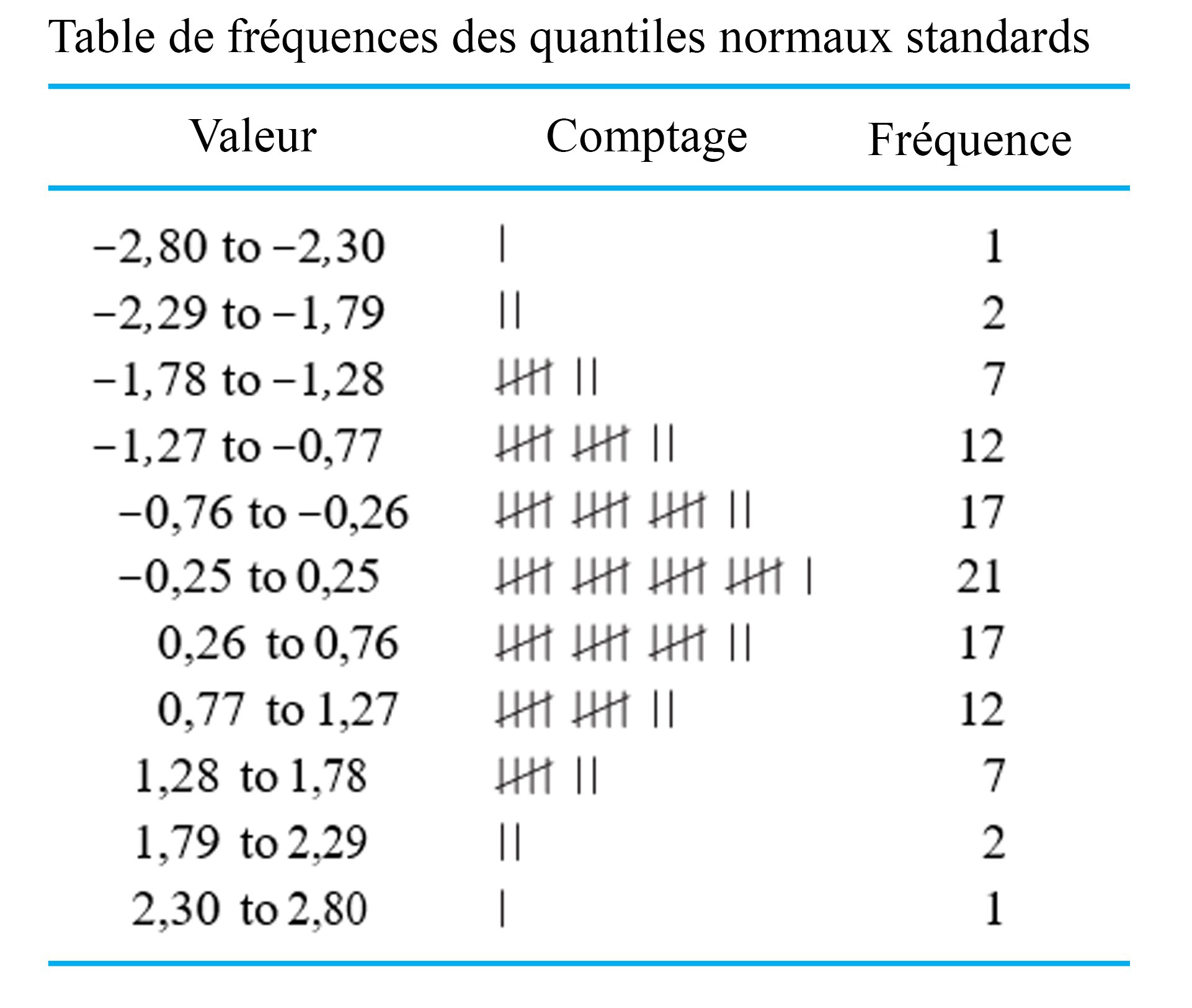

. Le tableau 2.1.7.3 présente une table de fréquences pour ces 99 points de données. La colonne Comptage du tableau 2.1.7.3 montre clairement la forme de cloche.

. Le tableau 2.1.7.3 présente une table de fréquences pour ces 99 points de données. La colonne Comptage du tableau 2.1.7.3 montre clairement la forme de cloche.

![permet d’insister sur le lien entre les graphiques de probabilités et les graphiques <img src="https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=Q-Q&fg=000000&font=TeX&svg=1" alt="Q-Q" title="Q-Q" class="latex mathjax" /> empiriques. Q-Q[/latex]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/e8180ab99492aaee8d689a75d59cbc88.png)

et si la valeur 2 est remplacée par

et si la valeur 2 est remplacée par  .

. , correspond à

, correspond à

.

.

est

est

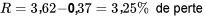

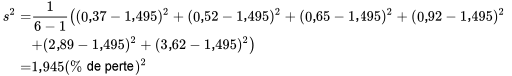

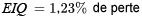

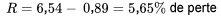

». Étant donné que l’étendue ne dépend que des valeurs du plus petit point et du plus grand point d’un ensemble de données, elle est nécessairement très sensible aux valeurs extrêmes (ou aberrantes). Parce qu’elle est facile à calculer, elle a longtemps été populaire dans les milieux industriels, notamment en tant qu’outil de contrôle statistique de la qualité.

». Étant donné que l’étendue ne dépend que des valeurs du plus petit point et du plus grand point d’un ensemble de données, elle est nécessairement très sensible aux valeurs extrêmes (ou aberrantes). Parce qu’elle est facile à calculer, elle a longtemps été populaire dans les milieux industriels, notamment en tant qu’outil de contrôle statistique de la qualité. est

est

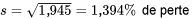

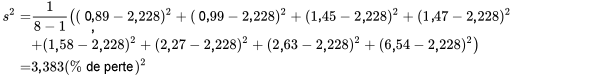

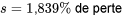

, est la racine carrée positive de la variance de l’échantillon.

, est la racine carrée positive de la variance de l’échantillon. par

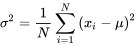

par  est la distance au carré moyenne des points de données par rapport à la valeur centrale

est la distance au carré moyenne des points de données par rapport à la valeur centrale

et

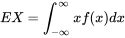

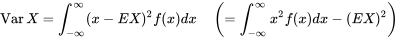

et  pour représenter la moyenne de la population et de noter :

pour représenter la moyenne de la population et de noter :

plutôt que

plutôt que  ) pour représenter la variance de la population et pour définir:

) pour représenter la variance de la population et pour définir:

correspond donc à l’écart-type de la population,

correspond donc à l’écart-type de la population,  .

.

ou

ou  qui doivent être comparées. Les diagrammes en barres et les diagrammes simples à deux variables peuvent être d’une grande aide pour résumer ces résultats.

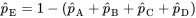

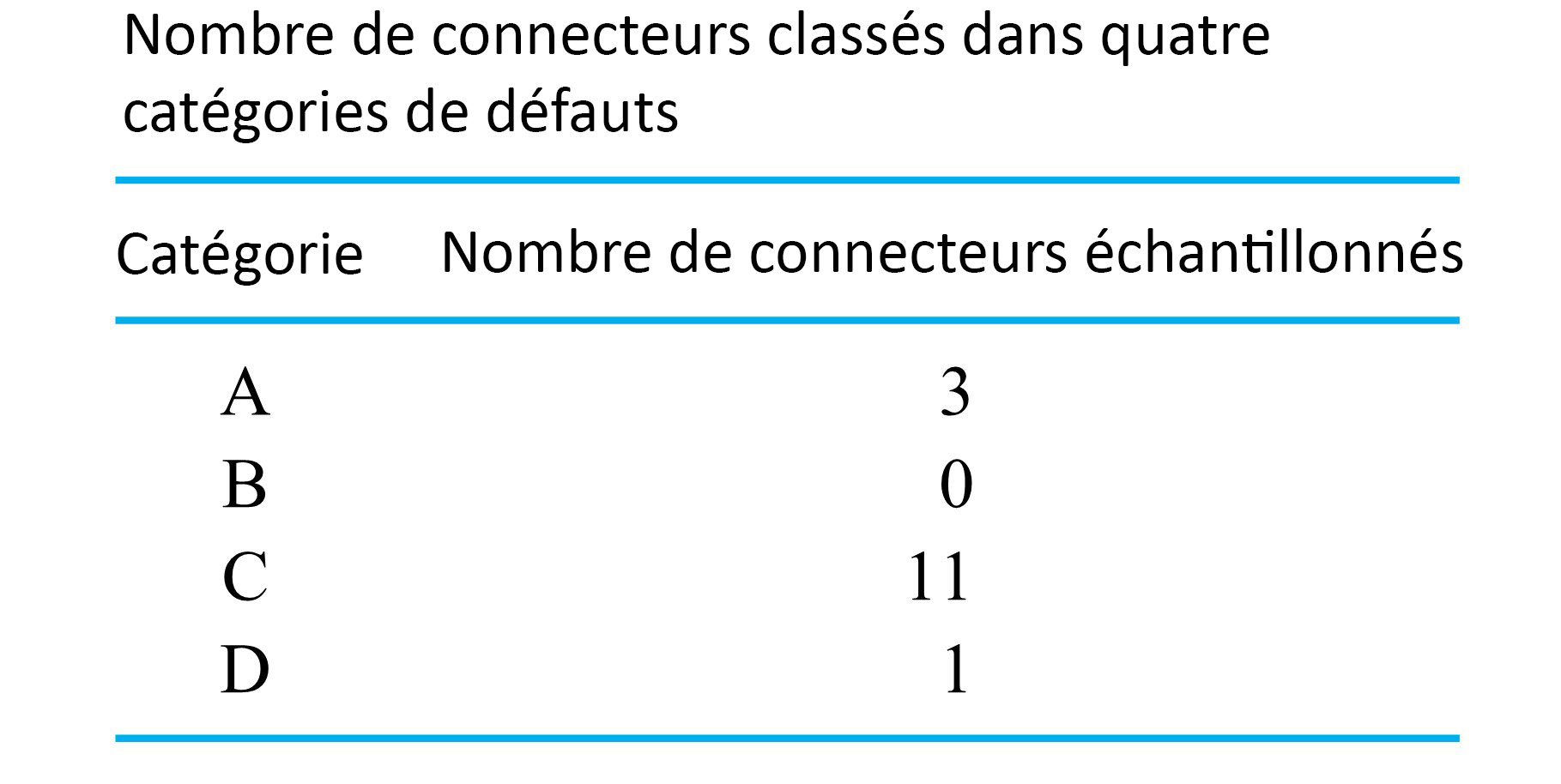

qui doivent être comparées. Les diagrammes en barres et les diagrammes simples à deux variables peuvent être d’une grande aide pour résumer ces résultats. , car les catégories A à E constituent un ensemble de catégories exhaustives et mutuellement exclusives, de sorte que la somme des

, car les catégories A à E constituent un ensemble de catégories exhaustives et mutuellement exclusives, de sorte que la somme des

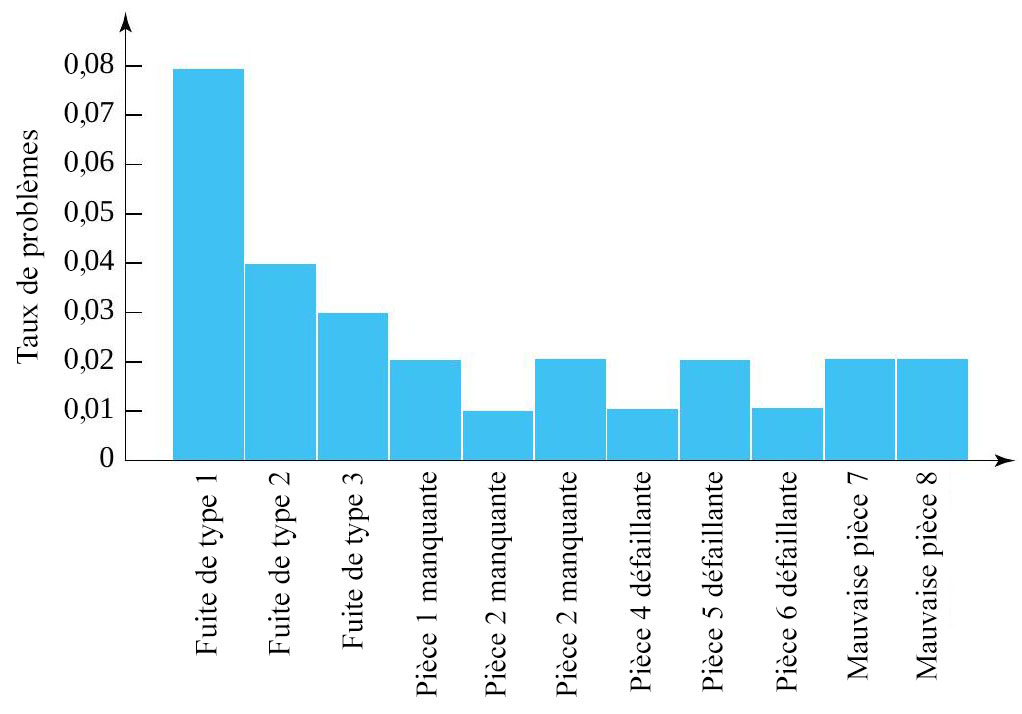

, celle des défauts modérément graves, mais ni graves ni très graves. Ce diagramme à barres présente le comportement d’une variable catégorique.

, celle des défauts modérément graves, mais ni graves ni très graves. Ce diagramme à barres présente le comportement d’une variable catégorique.

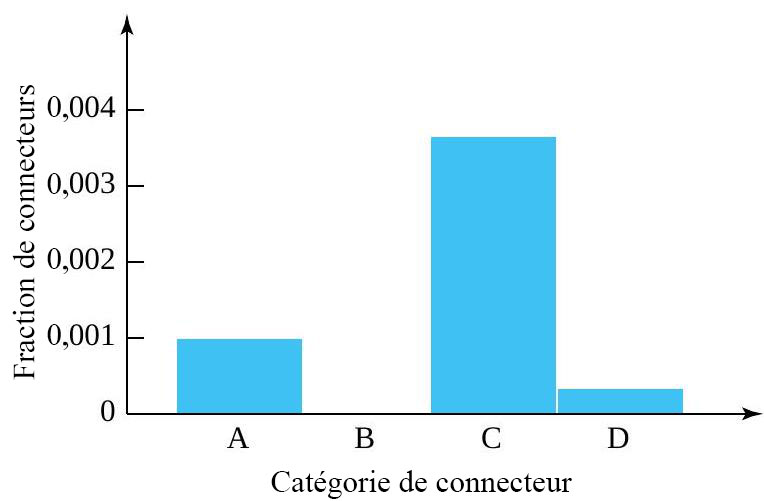

, donc la proportion d’outils ne présentant pas le type de fuite 1 est

, donc la proportion d’outils ne présentant pas le type de fuite 1 est  . Le total des valeurs

. Le total des valeurs

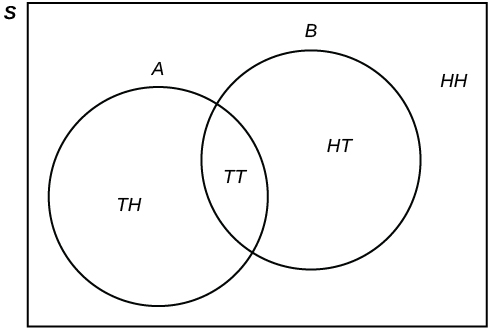

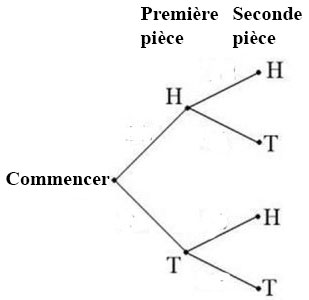

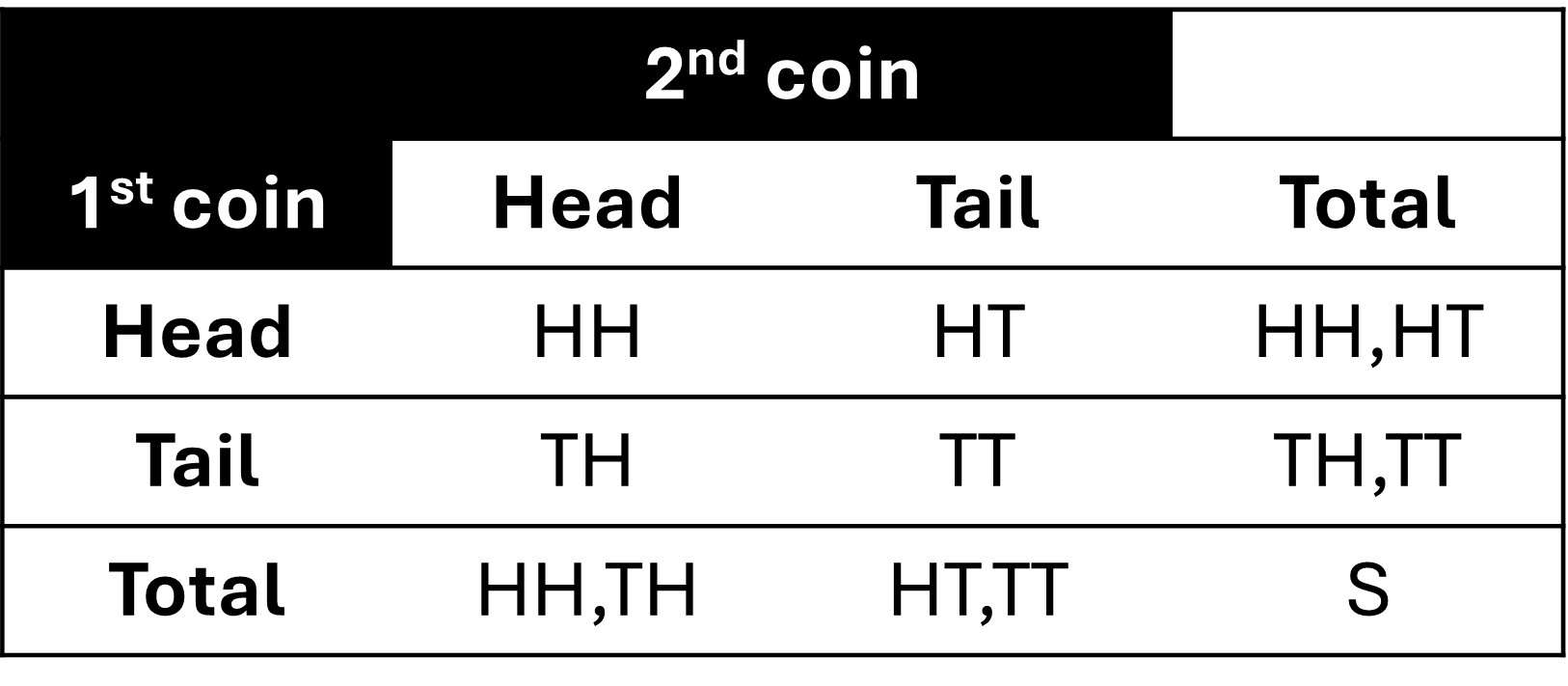

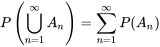

où P = pile et F = face sont les résultats. L’espace échantillon correspondant à lancer une fois deux pièces de monnaie s’exprime comme suit : S = {(PP),(PF),(FP),(FF)}. Nous utiliserons également des lettres majuscules pour désigner un événement, comme A et B. Par exemple, on peut définir l’événement A comme le fait d’obtenir pile sur la première pièce, et l’événement B, comme le fait d’obtenir pile sur la deuxième pièce. Cela se traduirait par

où P = pile et F = face sont les résultats. L’espace échantillon correspondant à lancer une fois deux pièces de monnaie s’exprime comme suit : S = {(PP),(PF),(FP),(FF)}. Nous utiliserons également des lettres majuscules pour désigner un événement, comme A et B. Par exemple, on peut définir l’événement A comme le fait d’obtenir pile sur la première pièce, et l’événement B, comme le fait d’obtenir pile sur la deuxième pièce. Cela se traduirait par  et

et  . Les diagrammes sont utiles pour représenter ensemble les opérations de plusieurs événements.

. Les diagrammes sont utiles pour représenter ensemble les opérations de plusieurs événements. n’est ni dans

n’est ni dans  ni dans

ni dans  . Le diagramme de Venn est alors représenté comme suit :

. Le diagramme de Venn est alors représenté comme suit :

et

et  . Par conséquent,

. Par conséquent,  =

=  =

=  =

=  .

.  =

=  =

=  .

.

. Les événements marginaux sont ceux qui figurent en marge du tableau et qui se produisent pour un seul événement, sans tenir compte des autres événements du tableau. Dans cet exemple, le tableau contient un événement marginal A auquel sont associés les événements conjoints

. Les événements marginaux sont ceux qui figurent en marge du tableau et qui se produisent pour un seul événement, sans tenir compte des autres événements du tableau. Dans cet exemple, le tableau contient un événement marginal A auquel sont associés les événements conjoints

.

. .

. .

. .

. est l’ensemble des résultats qui se trouvent à la fois dans

est l’ensemble des résultats qui se trouvent à la fois dans  est l’ensemble des résultats qui ne sont dans

est l’ensemble des résultats qui ne sont dans  . Par conséquent,

. Par conséquent,  est l’ensemble de résultats qui ne sont pas dans

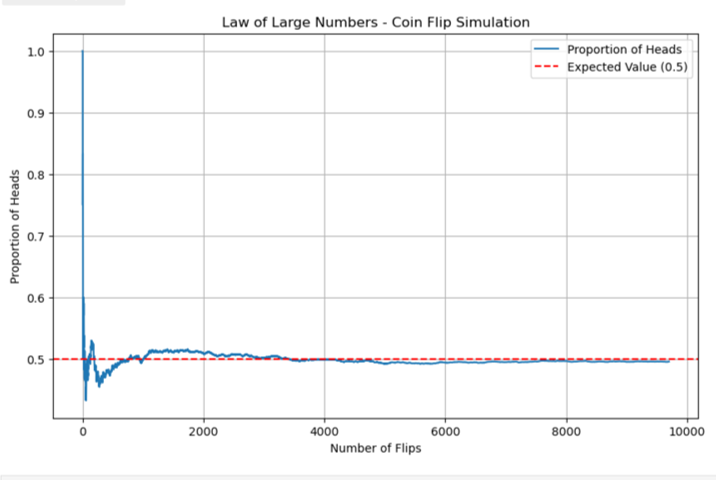

est l’ensemble de résultats qui ne sont pas dans  , où m est le nombre de résultats d’occurrences de l’événement A, et n le nombre total de résultats de l’expérience. L’approche fréquentiste affirme qu’au fur et à mesure que le nombre d’essais augmente, la variation de la fréquence relative diminue. La probabilité est donc la valeur limite des fréquences relatives correspondantes. On peut déterminer la fréquence relative soit en réalisant des expériences réelles et en trouvant une probabilité empirique (ou estimée), soit en reconnaissant le modèle théorique de l’expérience et en adoptant une probabilité théorique basée sur les événements de l’espace échantillon.

, où m est le nombre de résultats d’occurrences de l’événement A, et n le nombre total de résultats de l’expérience. L’approche fréquentiste affirme qu’au fur et à mesure que le nombre d’essais augmente, la variation de la fréquence relative diminue. La probabilité est donc la valeur limite des fréquences relatives correspondantes. On peut déterminer la fréquence relative soit en réalisant des expériences réelles et en trouvant une probabilité empirique (ou estimée), soit en reconnaissant le modèle théorique de l’expérience et en adoptant une probabilité théorique basée sur les événements de l’espace échantillon.

= 0,5.

= 0,5.

et correspond à un nombre compris entre zéro et un (inclusivement) qui décrit la proportion de fois où l’on s’attend à ce que l’événement se produise sur le long terme. P(A) = 0 signifie que l’événement A ne peut jamais se produire. P(A) = 1 signifie que l’événement A se produit toujours. P(A) = 0.5 signifie que l’événement A a la même probabilité de se produire ou de ne pas se produire. Par exemple, si vous tirez à pile ou face de manière répétée (20, 2 000 ou 20 000 fois), la fréquence relative de faces tends vers 0,5 (soit la probabilité d’obtenir face).

et correspond à un nombre compris entre zéro et un (inclusivement) qui décrit la proportion de fois où l’on s’attend à ce que l’événement se produise sur le long terme. P(A) = 0 signifie que l’événement A ne peut jamais se produire. P(A) = 1 signifie que l’événement A se produit toujours. P(A) = 0.5 signifie que l’événement A a la même probabilité de se produire ou de ne pas se produire. Par exemple, si vous tirez à pile ou face de manière répétée (20, 2 000 ou 20 000 fois), la fréquence relative de faces tends vers 0,5 (soit la probabilité d’obtenir face). est de 1 et la probabilité de l’ensemble vide est de 0. Autrement dit, P(S) = 1 et P(∅) = 0.

est de 1 et la probabilité de l’ensemble vide est de 0. Autrement dit, P(S) = 1 et P(∅) = 0.

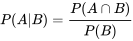

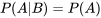

» signifie « probabilité de A, étant donné B ».

» signifie « probabilité de A, étant donné B ». .

. .

. .

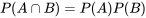

. sont mutuellement indépendants si pour tout sous-ensemble

sont mutuellement indépendants si pour tout sous-ensemble  :

:

cartes bien mélangées. Il se compose de quatre couleurs : le trèfle, le carreau, le cœur et le pique. Chaque couleur comporte

cartes bien mélangées. Il se compose de quatre couleurs : le trèfle, le carreau, le cœur et le pique. Chaque couleur comporte  cartes :

cartes : ,

,  (valet),

(valet),  (dame),

(dame),  (roi) de cette couleur.

(roi) de cette couleur. cartes restantes du jeu. Il s’agit du 3 de carreau. On met cette carte de côté, puis on choisit une troisième carte parmi dans les

cartes restantes du jeu. Il s’agit du 3 de carreau. On met cette carte de côté, puis on choisit une troisième carte parmi dans les  cartes restantes du jeu. La troisième carte est un

cartes restantes du jeu. La troisième carte est un

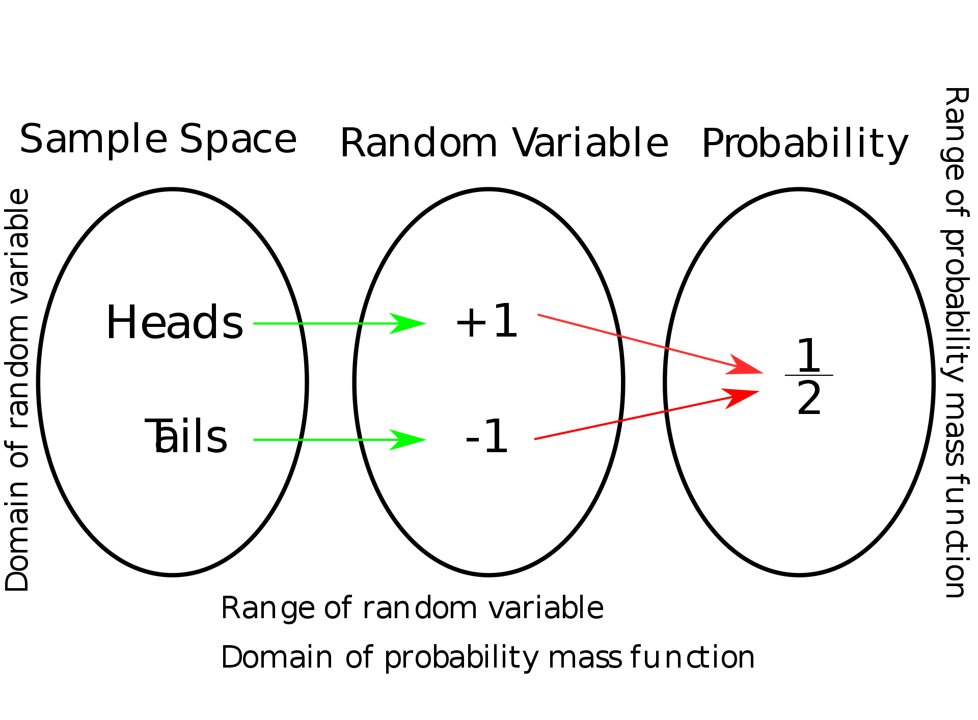

![{\displaystyle [0,1]\subseteq \mathbb {R} } {\displaystyle [0,1]\subseteq \mathbb {R} }](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/511efe69c491a34ed7846e6fe78029c8.png) associée à chacune des valeurs possibles de la variable aléatoire. Les variable aléatoires sont exprimées sous la forme de lettres latines majuscules, souvent celles de la fin de l’alphabet, comme

associée à chacune des valeurs possibles de la variable aléatoire. Les variable aléatoires sont exprimées sous la forme de lettres latines majuscules, souvent celles de la fin de l’alphabet, comme  .

. une valeur mesurable de l’espace

une valeur mesurable de l’espace  , où 1 correspond à P et -1 correspond à F, en utilisant la variable aléatoire

, où 1 correspond à P et -1 correspond à F, en utilisant la variable aléatoire  =

=  = +1, qu’on note

= +1, qu’on note  .

.

pour un événement.

pour un événement. .

.![{\displaystyle F\colon \mathbb {R} \rightarrow [0,1]} {\displaystyle F\colon \mathbb {R} \rightarrow [0,1]}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/77202eb9c5f3bc68098624bfd57bc61a.png) telle que

telle que  et

et  . Toute fonction possédant ces quatre propriétés est une FDC : pour chaque fonction de ce type, on peut définir une variable aléatoire qui a cette fonction pour fonction de distribution cumulative.

. Toute fonction possédant ces quatre propriétés est une FDC : pour chaque fonction de ce type, on peut définir une variable aléatoire qui a cette fonction pour fonction de distribution cumulative.![F(x)=P[X \leq x] F(x)=P[X \leq x]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/02661d769255dee69404659ee6e5a9c0.png)

,

, ,…, est une fonction non-négative f(x) telle que f (

,…, est une fonction non-négative f(x) telle que f ( ) donne la probabilité que X prenne la valeur

) donne la probabilité que X prenne la valeur

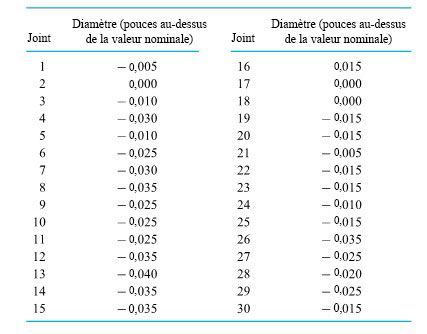

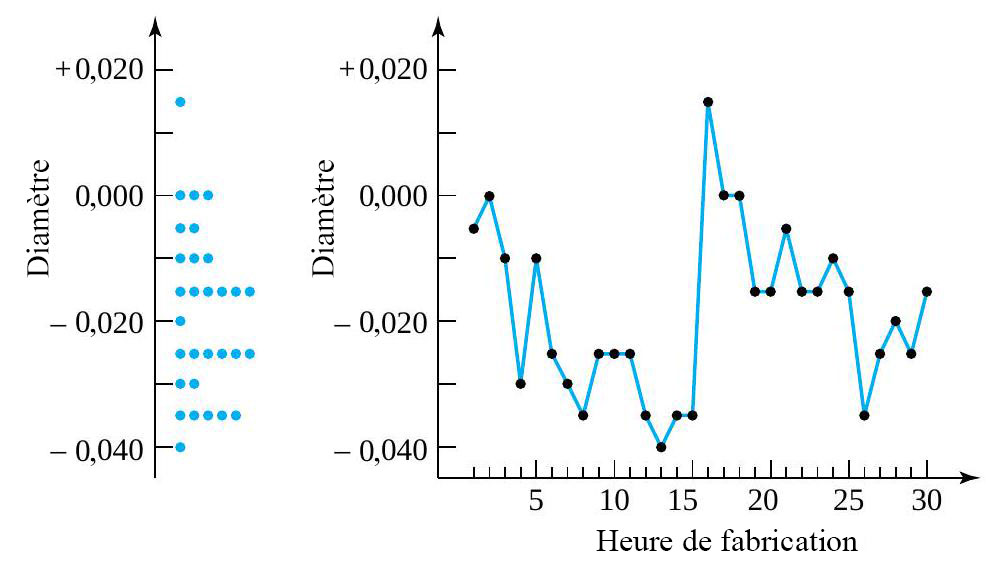

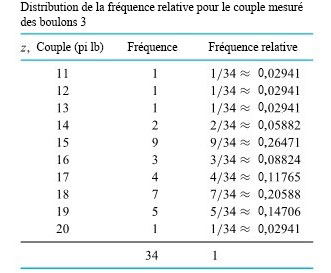

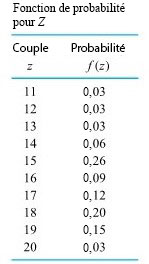

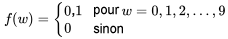

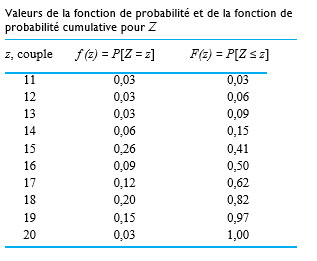

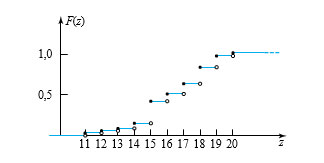

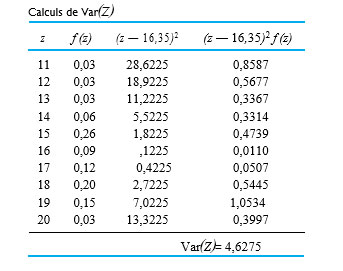

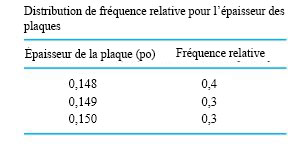

le prochain couple mesuré pour le boulon 3 (arrondi à l’entier le plus proche), que nous traiterons comme une variable aléatoire discrète. Il faut maintenant trouver une fonction de probabilité plausible pour Z. Les fréquences relatives des mesures de couple enregistrées sur le boulon 3 permettent d’établir la distribution des fréquences relative :

le prochain couple mesuré pour le boulon 3 (arrondi à l’entier le plus proche), que nous traiterons comme une variable aléatoire discrète. Il faut maintenant trouver une fonction de probabilité plausible pour Z. Les fréquences relatives des mesures de couple enregistrées sur le boulon 3 permettent d’établir la distribution des fréquences relative :

la valeur de couple sélectionnée.

la valeur de couple sélectionnée.

![F(16,3)=P[Z \leq 16,3]=P[Z \leq 16]=F(16)=0,50 F(16,3)=P[Z \leq 16,3]=P[Z \leq 16]=F(16)=0,50](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/9c1af41b6e51559dd079a4a47f1aafb9.png)

![F(32)=P[Z \leq 32]=1,00 F(32)=P[Z \leq 32]=1,00](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/c83689afaf4bfd6d03d0cabb8e1a9906.png)

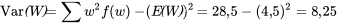

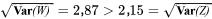

. On utilise souvent la notation

. On utilise souvent la notation  à la place de Var(X), et

à la place de Var(X), et  = 2,15 ft lb

= 2,15 ft lb

.

.

2,15=\sqrt{\operatorname{Var}(Z)} » title= »\sqrt{\operatorname{Var}(W)}=2,87>2,15=\sqrt{\operatorname{Var}(Z)} » class= »latex mathjax »>

2,15=\sqrt{\operatorname{Var}(Z)} » title= »\sqrt{\operatorname{Var}(W)}=2,87>2,15=\sqrt{\operatorname{Var}(Z)} » class= »latex mathjax »>

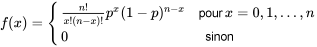

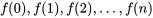

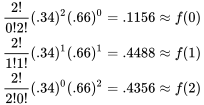

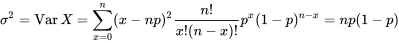

pour chaque essai produisant un échec. Le terme

pour chaque essai produisant un échec. Le terme  est un décompte du nombre de combinaisons dans lesquelles il est possible de voir

est un décompte du nombre de combinaisons dans lesquelles il est possible de voir  nomiale trouve son origine dans le fait que les valeurs

nomiale trouve son origine dans le fait que les valeurs  sont les termes du développement de

sont les termes du développement de

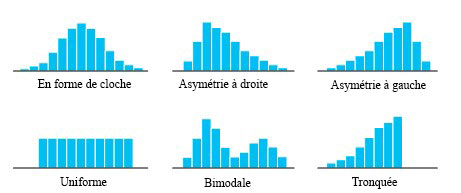

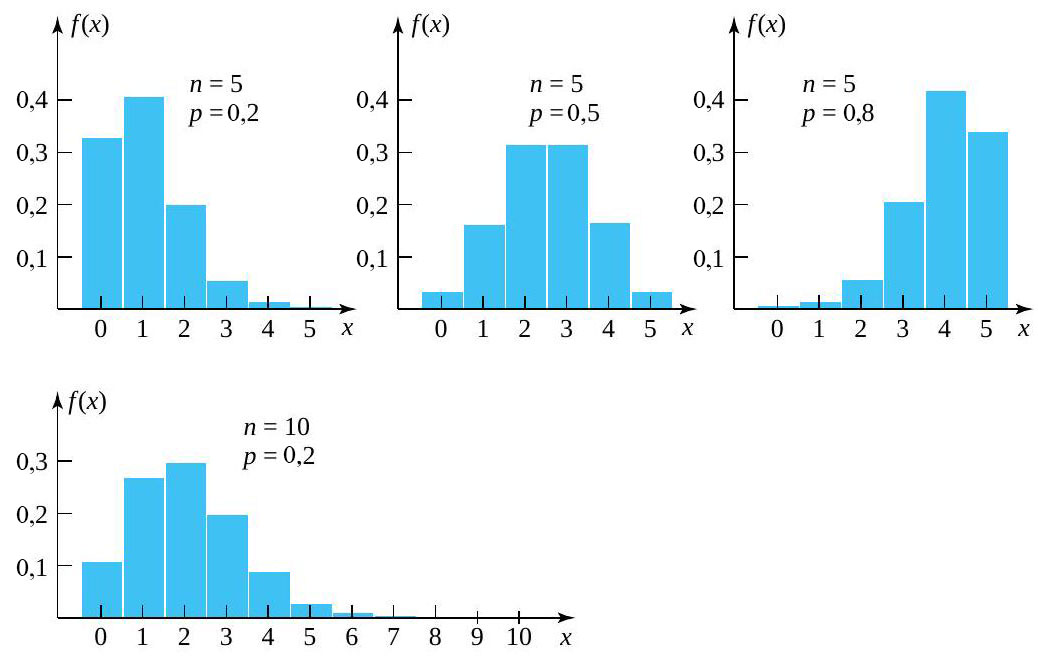

0,5" title="p>0,5" class="latex mathjax">, l’histogramme résultant est asymétrique à gauche. L’asymétrie augmente à mesure que

0,5" title="p>0,5" class="latex mathjax">, l’histogramme résultant est asymétrique à gauche. L’asymétrie augmente à mesure que

soit une probabilité crédible qu’un arbre soit réusinable. Supposons en outre qu’on inspecte

soit une probabilité crédible qu’un arbre soit réusinable. Supposons en outre qu’on inspecte

![\begin{aligned}P[\text { au moins deux arbres réusinables] } & =P[U \geq 2] \\& =f(2)+f(3)+\cdots+f(10) \\& =1-(f(0)+f(1)) \\& =1-\left(\frac{10 !}{0 ! 10 !}(0,2)^{0}(0,8)^{10 }+\frac{10 !}{1 ! 9 !}(0,2)^{1 }(0,8)^{9 }\right) \\&=0,62\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/6e6263a4d29e02e515efc04bf606f376.png) \begin{aligned}P[\text { au moins deux arbres réusinables] } & =P[U \geq 2] \\& =f(2)+f(3)+\cdots+f(10) \\& =1-(f(0)+f(1)) \\& =1-\left(\frac{10 !}{0 ! 10 !}(0,2)^{0}(0,8)^{10 }+\frac{10 !}{1 ! 9 !}(0,2)^{1 }(0,8)^{9 }\right) \\&=0,62\end{aligned}

\begin{aligned}P[\text { au moins deux arbres réusinables] } & =P[U \geq 2] \\& =f(2)+f(3)+\cdots+f(10) \\& =1-(f(0)+f(1)) \\& =1-\left(\frac{10 !}{0 ! 10 !}(0,2)^{0}(0,8)^{10 }+\frac{10 !}{1 ! 9 !}(0,2)^{1 }(0,8)^{9 }\right) \\&=0,62\end{aligned} doit être égale à 1.)

doit être égale à 1.) , et le nombre 0,62 est alors peu pertinent. (L’hypothèse de l’indépendance des essais serait inappropriée dans cette situation.)

, et le nombre 0,62 est alors peu pertinent. (L’hypothèse de l’indépendance des essais serait inappropriée dans cette situation.)

.

. .

.

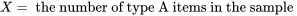

est obtenue comme suit. Les valeurs possibles pour

est obtenue comme suit. Les valeurs possibles pour ![\begin{aligned}f(0)= & P[V=0] \\= & P[\text {la première pastille sélectionnée est non conforme et } \\& \text { la deuxième pastille est également non conforme}] \\f(2)= & P[V=2] \\= & P[\text {la première pastille sélectionnée est conforme et } \\& \text { la deuxième pastille sélectionnée est également conforme}] \\f(1)= & 1-(f(0)+f(2))\end{aligned} \begin{aligned}f(0)= & P[V=0] \\= & P[\text {la première pastille sélectionnée est non conforme et } \\& \text { la deuxième pastille est également non conforme}] \\f(2)= & P[V=2] \\= & P[\text {la première pastille sélectionnée est conforme et } \\& \text { la deuxième pastille sélectionnée est également conforme}] \\f(1)= & 1-(f(0)+f(2))\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/dddd7bf74b1653017202d626851885f8.png)

vaut

vaut

à

à  . Néanmoins, à des fins pratiques,

. Néanmoins, à des fins pratiques,  . Pour s’en convaincre, il suffit de noter que

. Pour s’en convaincre, il suffit de noter que

et que p n’est pas trop extrême, la distribution binomiale est une description correcte d’une variable issue d’un échantillonnage aléatoire simple.

et que p n’est pas trop extrême, la distribution binomiale est une description correcte d’une variable issue d’un échantillonnage aléatoire simple.

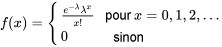

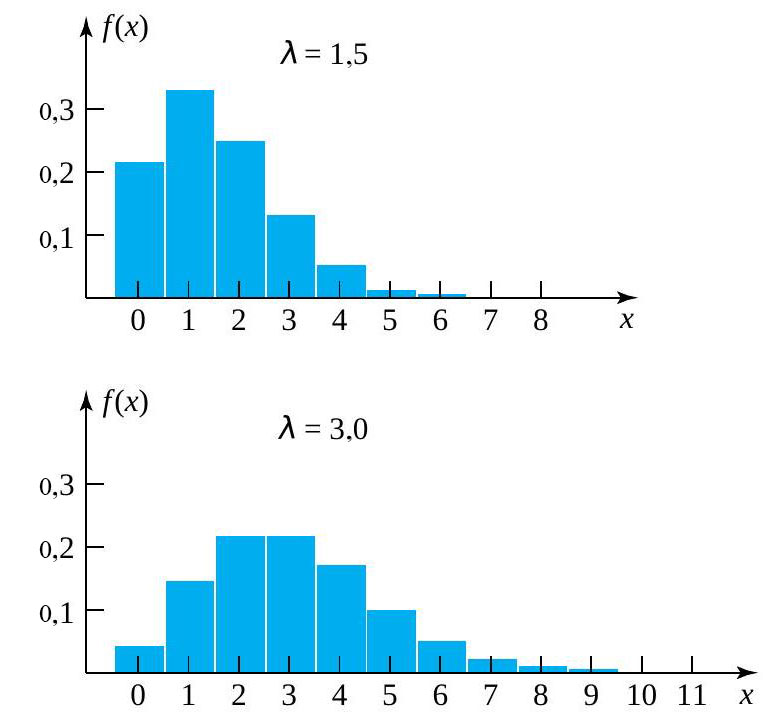

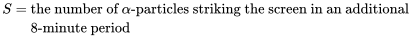

0″ title= »\lambda>0″ class= »latex mathjax »>.

0″ title= »\lambda>0″ class= »latex mathjax »>. . On obtient alors la distribution binomiale

. On obtient alors la distribution binomiale  . En fait, si

. En fait, si  se rapproche de celle donnée dans la définition 3.2.6.1. On peut donc considérer que la distribution de Poisson pour les dénombrements résulte d’un mécanisme qui présente de nombreuses possibilités d’occurrences (à très faible probabilité) ou de non-occurrences indépendantes dans un intervalle de temps ou d’espace donné.

se rapproche de celle donnée dans la définition 3.2.6.1. On peut donc considérer que la distribution de Poisson pour les dénombrements résulte d’un mécanisme qui présente de nombreuses possibilités d’occurrences (à très faible probabilité) ou de non-occurrences indépendantes dans un intervalle de temps ou d’espace donné.

, et l’histogramme de probabilité atteint un sommet près de

, et l’histogramme de probabilité atteint un sommet près de

.

.

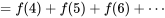

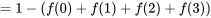

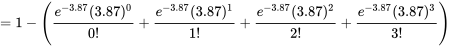

[au moins 4 particules sont enregistrées]

[au moins 4 particules sont enregistrées]![=P[S \geq 4] =P[S \geq 4]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/32e72bc46069c5e865b1358f0cb30ac6.png)

,

,

![\begin{aligned}P[10 \leq M \leq 15]= & f(10)+f(11)+f(12)+f(13)+f(14)+f(15) \\= & \frac{e^{-12,5}(12,5)^}{10 !}+\frac{e^{-12,5}(12,5)^}{11 !}+\frac{e^{-12,5}(12,5)^}{12 !} \\& +\frac{e^{-12,5}(12,5)^}{13 !}+\frac{e^{-12,5}(12,5)^}{14 !}+\frac{e^{-12,5}(12,5)^}{15 !} \\= & .60\end{aligned} \begin{aligned}P[10 \leq M \leq 15]= & f(10)+f(11)+f(12)+f(13)+f(14)+f(15) \\= & \frac{e^{-12,5}(12,5)^}{10 !}+\frac{e^{-12,5}(12,5)^}{11 !}+\frac{e^{-12,5}(12,5)^}{12 !} \\& +\frac{e^{-12,5}(12,5)^}{13 !}+\frac{e^{-12,5}(12,5)^}{14 !}+\frac{e^{-12,5}(12,5)^}{15 !} \\= & .60\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/0fb614c04715fc8cdf4a57a37d5d8dc9.png)

pour représenter la courbe.

pour représenter la courbe.  f(x) dx lorsque dx tend vers zéro. (En mécanique,

f(x) dx lorsque dx tend vers zéro. (En mécanique,  X

X f(t) dt

f(t) dt F(x) = f(x)

F(x) = f(x)

et

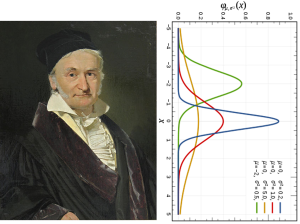

et  . P(c<x<d) est l’aire sous la courbe, entre

. P(c<x<d) est l’aire sous la courbe, entre  . La probabilité que

. La probabilité que  et

et  La probabilité étant égale à l’aire, la probabilité est donc également nulle.

La probabilité étant égale à l’aire, la probabilité est donc également nulle. , car la probabilité est égale à l’aire.

, car la probabilité est égale à l’aire. .

.

à la place de Var(X), et le symbole σ est utilisé à la place de

à la place de Var(X), et le symbole σ est utilisé à la place de

(on se rappelle que l’écart-type =

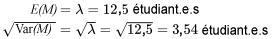

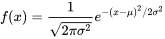

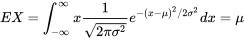

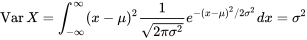

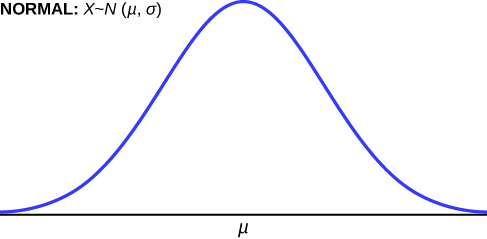

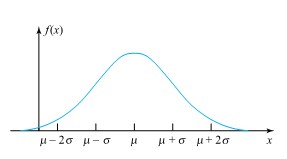

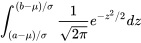

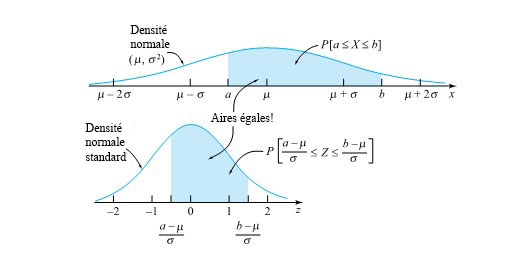

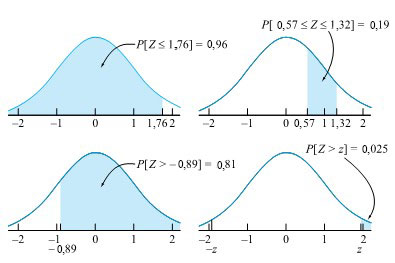

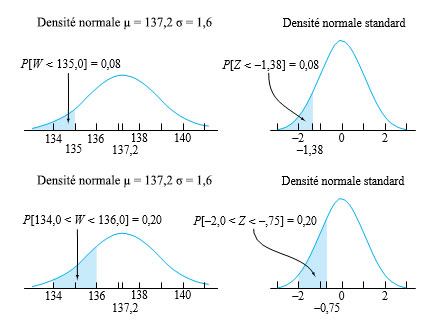

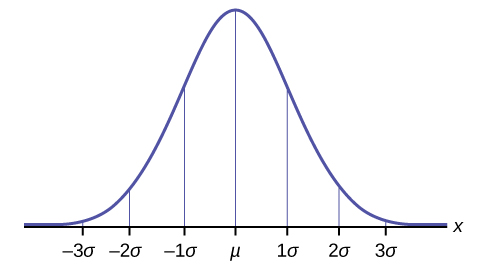

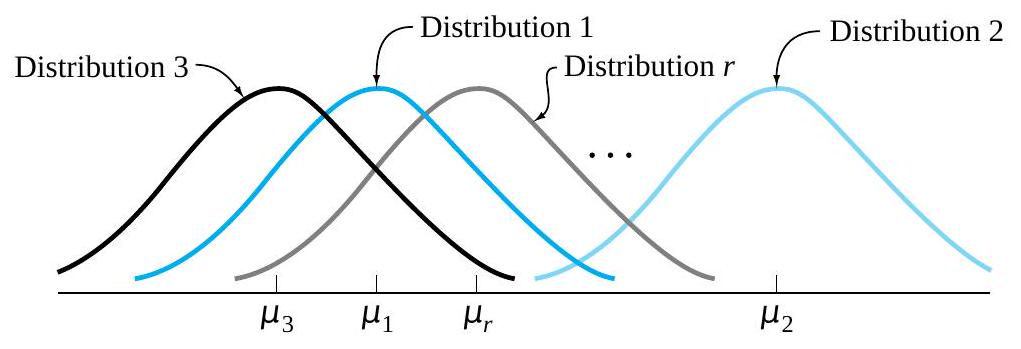

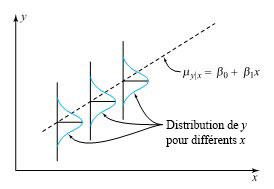

(on se rappelle que l’écart-type =  = σ). La figure 4.1.3.1 illustre la notation de la distribution normale standard et indique que la forme de la distribution dépend de ces paramètres. Comme l’aire sous la courbe doit être égale à 1, un changement dans l’écart-type σ entraîne une modification de la forme de la courbe; la courbe devient plus large ou plus étroite selon si σ augmente ou diminue, respectivement. Une modification de μ entraîne une translation du graphique vers la gauche ou la droite. En vertu de ces deux paramètres, il existe un nombre infini de distributions de probabilités normales.

= σ). La figure 4.1.3.1 illustre la notation de la distribution normale standard et indique que la forme de la distribution dépend de ces paramètres. Comme l’aire sous la courbe doit être égale à 1, un changement dans l’écart-type σ entraîne une modification de la forme de la courbe; la courbe devient plus large ou plus étroite selon si σ augmente ou diminue, respectivement. Une modification de μ entraîne une translation du graphique vers la gauche ou la droite. En vertu de ces deux paramètres, il existe un nombre infini de distributions de probabilités normales.

![P[a \leq X \leq b]=\int_a^b \frac{ 1}{\sqrt{2 \pi \sigma^2}} e^{-(x-\mu)^2 / 2 \sigma^2} d x=\int_{(a-\mu) / \sigma}^{(b-\mu) / \sigma} \frac{ 1}{\sqrt{2 \pi}} e^{-z^2 / 2} d z P[a \leq X \leq b]=\int_a^b \frac{ 1}{\sqrt{2 \pi \sigma^2}} e^{-(x-\mu)^2 / 2 \sigma^2} d x=\int_{(a-\mu) / \sigma}^{(b-\mu) / \sigma} \frac{ 1}{\sqrt{2 \pi}} e^{-z^2 / 2} d z](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/7d7d2902c84523e28fb1268b52141fbd.png)

et une valeur x associée à X on obtient la cote Z comme suit :

et une valeur x associée à X on obtient la cote Z comme suit :

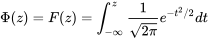

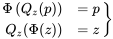

est utilisé pour représenter la fonction de probabilité normale réduite cumulative, au lieu de la lettre F, plus générique.

est utilisé pour représenter la fonction de probabilité normale réduite cumulative, au lieu de la lettre F, plus générique. , la fonction quantile normale réduite, on a :

, la fonction quantile normale réduite, on a :

sont des fonctions inverses. (En fait, la relation

sont des fonctions inverses. (En fait, la relation n’est pas une propriété particulière de la distribution normale réduite; cette identité tient

n’est pas une propriété particulière de la distribution normale réduite; cette identité tient

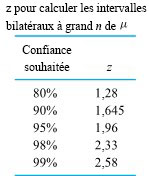

= 0,025 que z se trouve dans la queue droite de la distribution normale

= 0,025 que z se trouve dans la queue droite de la distribution normale . En repérant 0,975 dans le corps de la table, on constate que z = 1,96.

. En repérant 0,975 dans le corps de la table, on constate que z = 1,96.

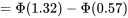

= 134,0 et w

= 134,0 et w = 136,0 :

= 136,0 :

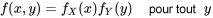

, qui calcule la probabilité que

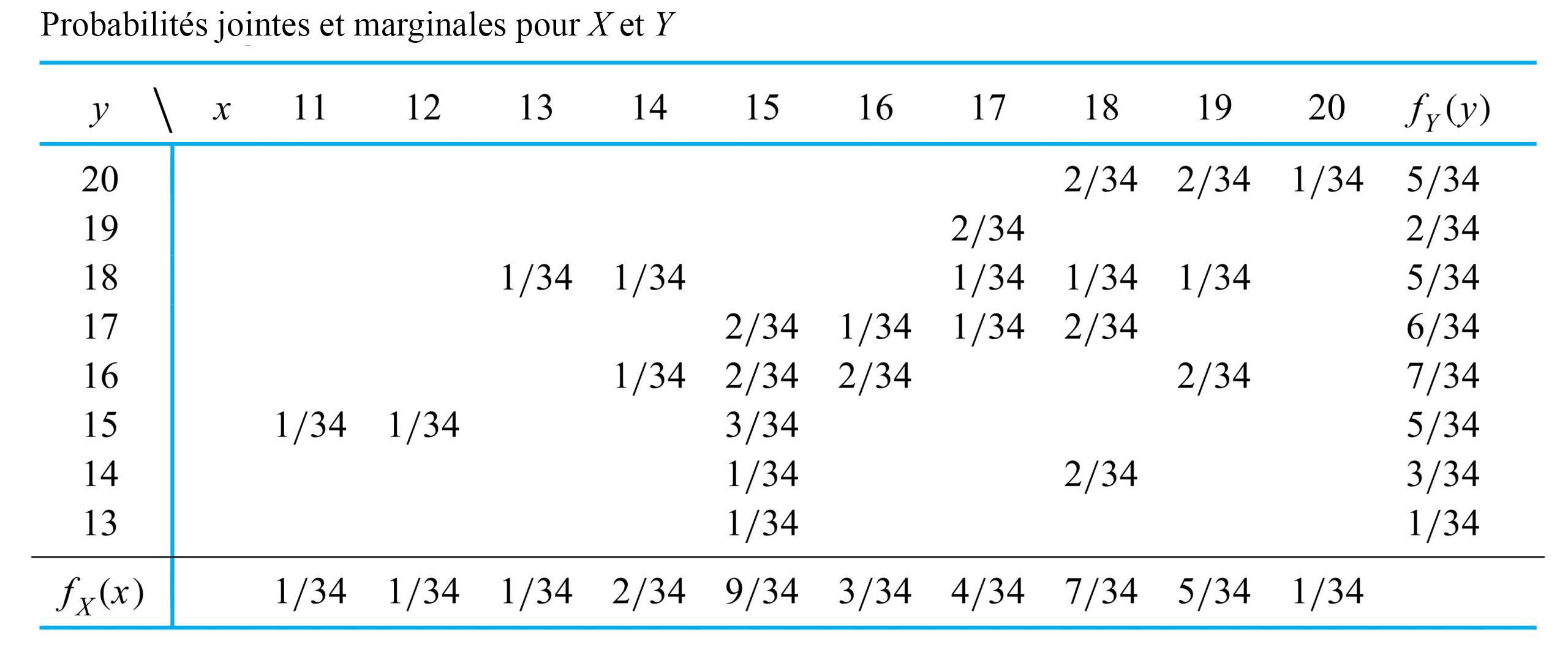

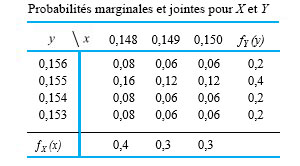

, qui calcule la probabilité que (simultanément). Autrement dit,

(simultanément). Autrement dit,![f(x, y)=P[X=x \text { et } Y=y] f(x, y)=P[X=x \text { et } Y=y]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/0b98ddcec1358e23f0edde7603a4572b.png)

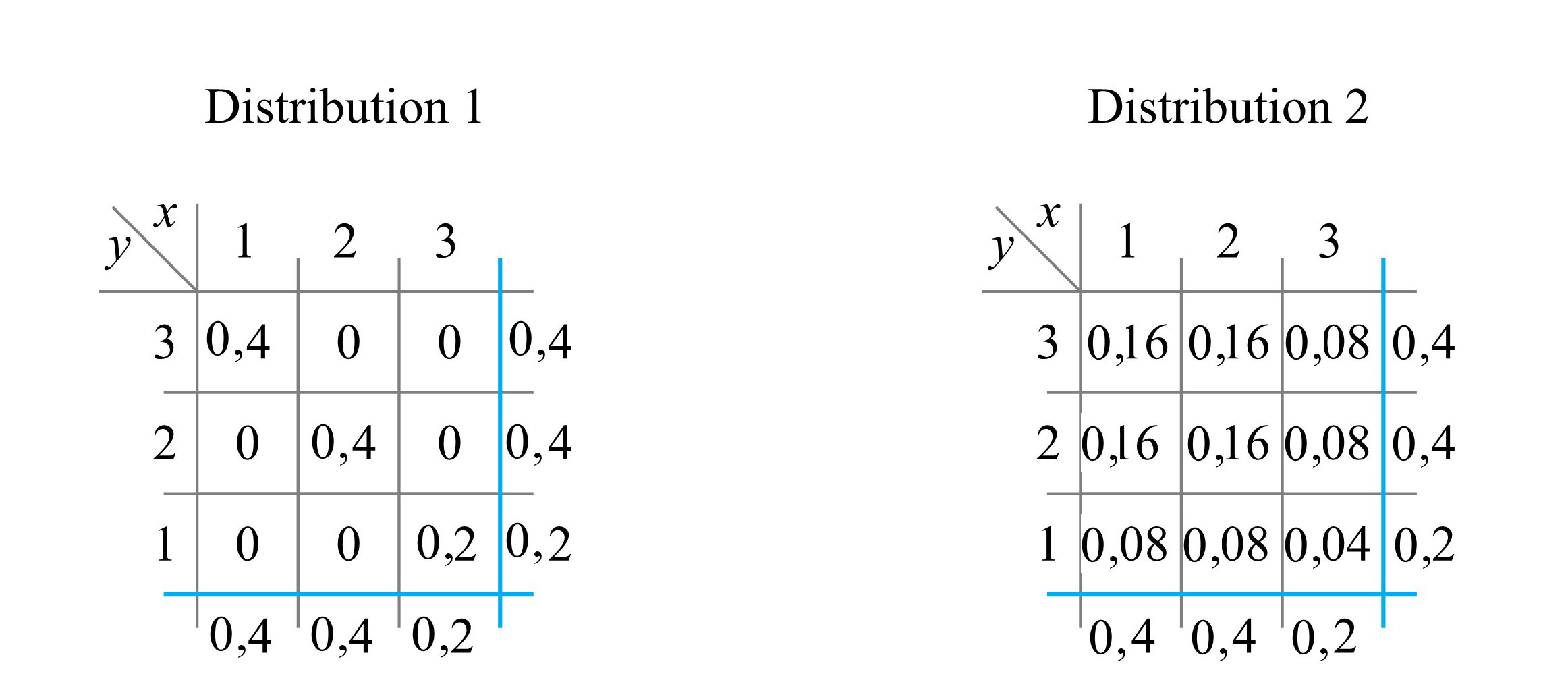

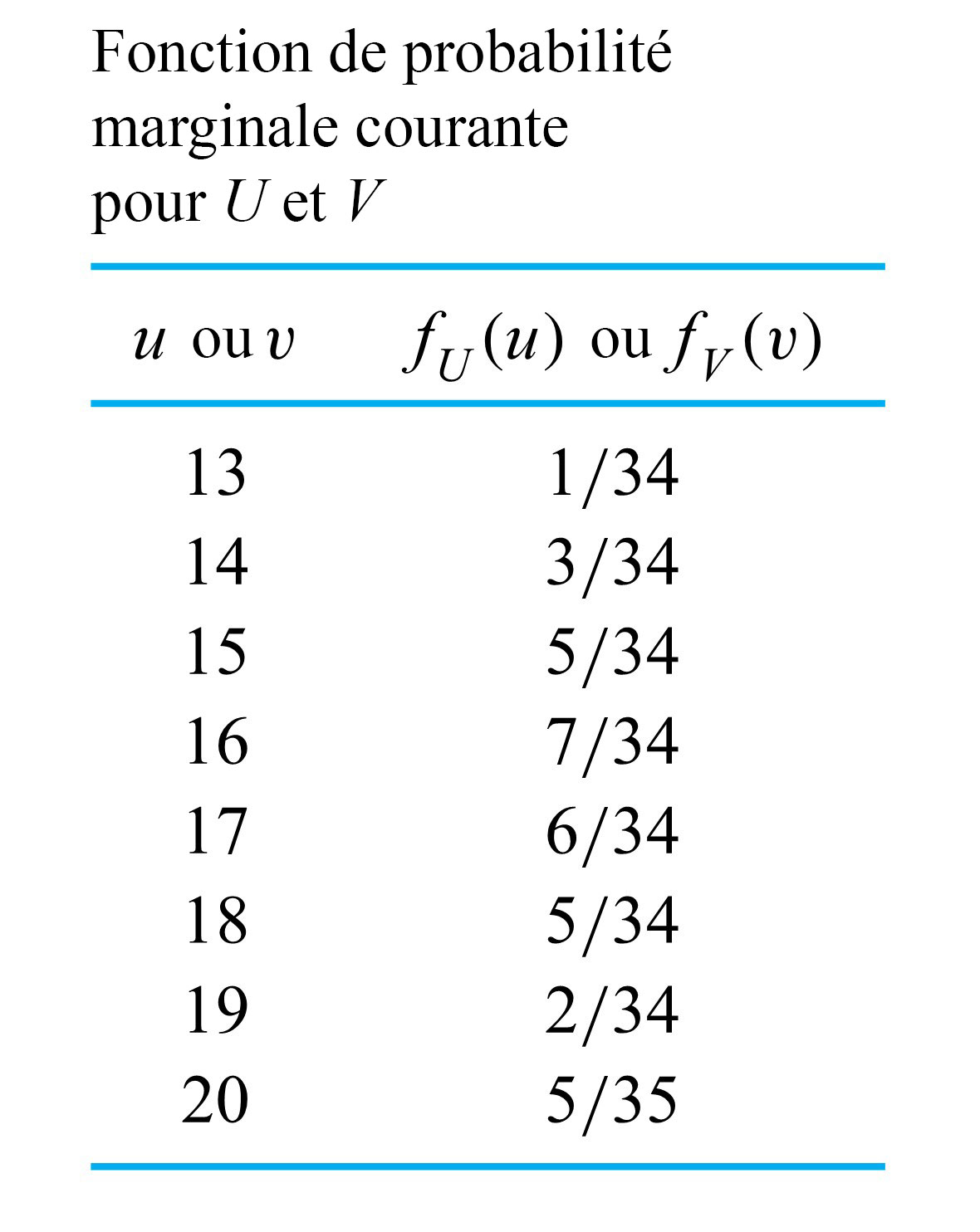

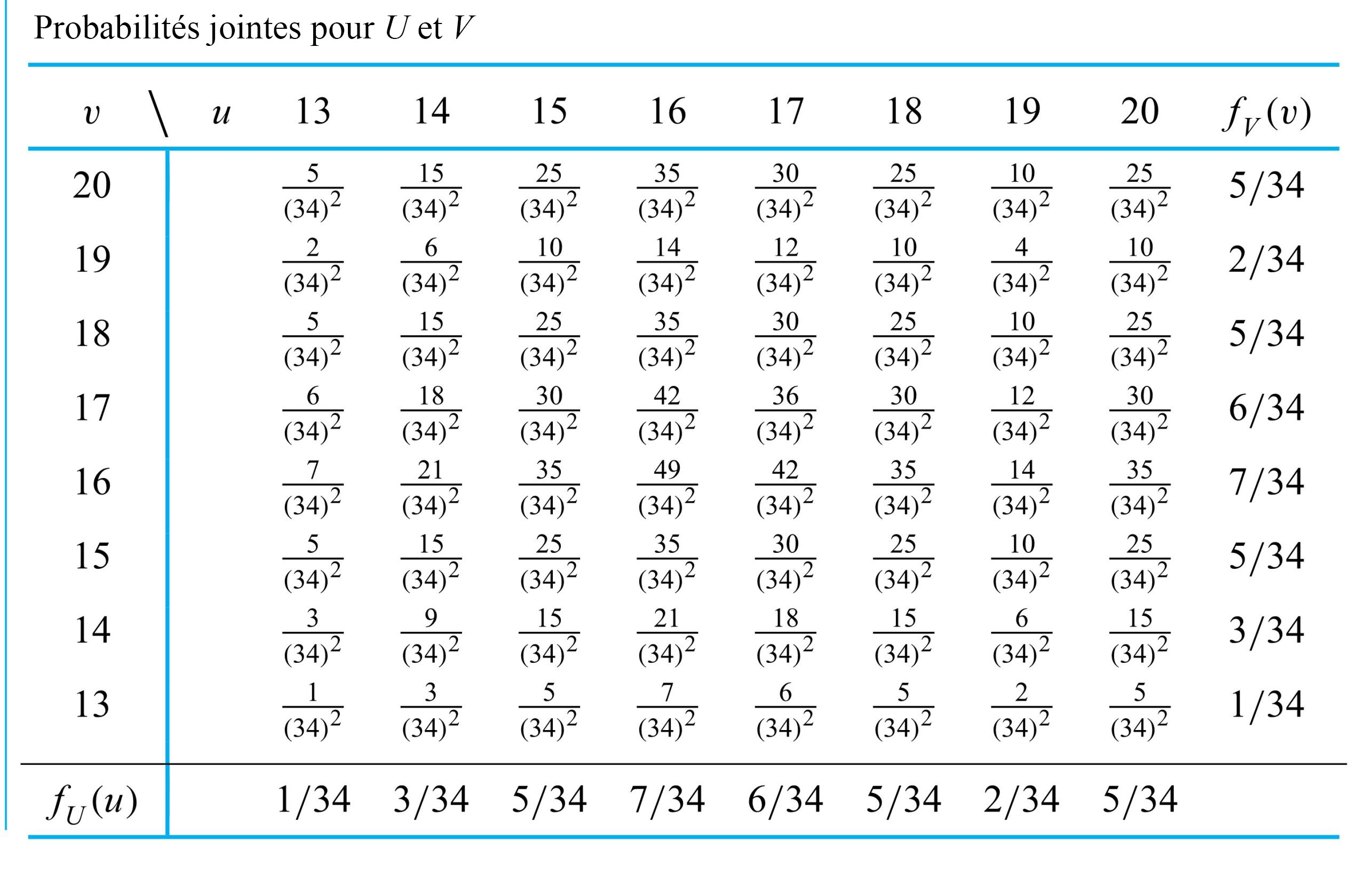

le prochain couple enregistré pour le boulon 3

le prochain couple enregistré pour le boulon 3 le prochain couple enregistré pour le boulon 4

le prochain couple enregistré pour le boulon 4 et

et ![Y=18] Y=18]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/7b60878193a2a3ebd3d9c6686c22d985.png) pourrait être

pourrait être  , la fréquence relative de cette paire dans l’ensemble de données. De même, les valeurs

, la fréquence relative de cette paire dans l’ensemble de données. De même, les valeurs![\begin{aligned}& P[X=18 \text { et } Y=17]=\frac{2 }{ 34} \\& P[X=14 \text { et } Y=9]=0\end{aligned} \begin{aligned}& P[X=18 \text { et } Y=17]=\frac{2 }{ 34} \\& P[X=14 \text { et } Y=9]=0\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/f043af9dc4c47fbf28ee933f1241c4d0.png)

![[0,1] [0,1]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/344478f605e0a63e4fb539fbfc216ad1.png) , et leur somme vaut 1. Pour obtenir la probabilité d’une configuration d’intérêt

, et leur somme vaut 1. Pour obtenir la probabilité d’une configuration d’intérêt ![\begin{aligned}& P[X\geq Y], \\& P[|X-Y|\leq 1], \\& \text { et } P[X=17]\end{aligned} \begin{aligned}& P[X\geq Y], \\& P[|X-Y|\leq 1], \\& \text { et } P[X=17]\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/3a431cdee21c01d58bfeb2e20efe60e4.png)

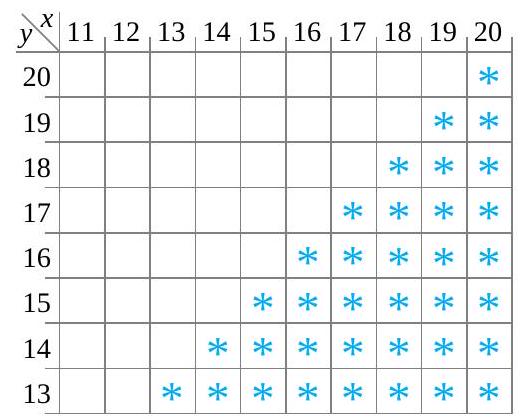

![P[X \geq Y] P[X \geq Y]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/af46a0fb553ac0a80758e888cfaa850b.png) , la probabilité que le couple du boulon 3 soit au moins aussi important que le couple du boulon 4. La figure 4.2.1.1 indique par des astérisques les combinaisons possibles de

, la probabilité que le couple du boulon 3 soit au moins aussi important que le couple du boulon 4. La figure 4.2.1.1 indique par des astérisques les combinaisons possibles de ![\begin{aligned}P[X \geq Y]= & f(15,13)+f(15,14)+f(15,15)+f(16,16) \\& +f(17,17)+f(18,14)+f(18,17)+f(18,18) \\& +f(19,16)+f(19,18)+f(20,20) \\= & \frac{ 1}{ 34}+\frac{ 1}{ 34}+\frac{ 3}{ 34}+\frac{ 2}{ 34}+\cdots+\frac{ 1}{ 34}=\frac{ 17}{ 34}\end{aligned} \begin{aligned}P[X \geq Y]= & f(15,13)+f(15,14)+f(15,15)+f(16,16) \\& +f(17,17)+f(18,14)+f(18,17)+f(18,18) \\& +f(19,16)+f(19,18)+f(20,20) \\= & \frac{ 1}{ 34}+\frac{ 1}{ 34}+\frac{ 3}{ 34}+\frac{ 2}{ 34}+\cdots+\frac{ 1}{ 34}=\frac{ 17}{ 34}\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/e8700d378546578de7dab9beaf219426.png)

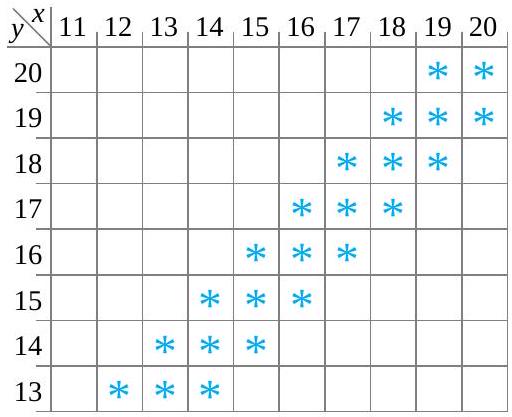

![P[|X-Y| \leq 1] P[|X-Y| \leq 1]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/e863f7444d8179376e25d920e88fbd40.png) -la probabilité que les couples des boulons 3 et 4 se situent à

-la probabilité que les couples des boulons 3 et 4 se situent à  l’un de l’autre. La figure 4.2.1.2 illustre les combinaisons de

l’un de l’autre. La figure 4.2.1.2 illustre les combinaisons de ![\begin{aligned}P[|X-Y| \leq 1]= & f(15,14)+f(15,15)+f(15,16)+f(16,16) \\& +f(16,17)+f(17,17)+f(17,18)+f(18,17) \\& +f(18,18)+f(19,18)+f(19,20)+f(20,20)=\frac{ 18}{ 34}\end{aligned} \begin{aligned}P[|X-Y| \leq 1]= & f(15,14)+f(15,15)+f(15,16)+f(16,16) \\& +f(16,17)+f(17,17)+f(17,18)+f(18,17) \\& +f(18,18)+f(19,18)+f(19,20)+f(20,20)=\frac{ 18}{ 34}\end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/65e181c2f20553b81748bdc1a694cbcd.png)

.

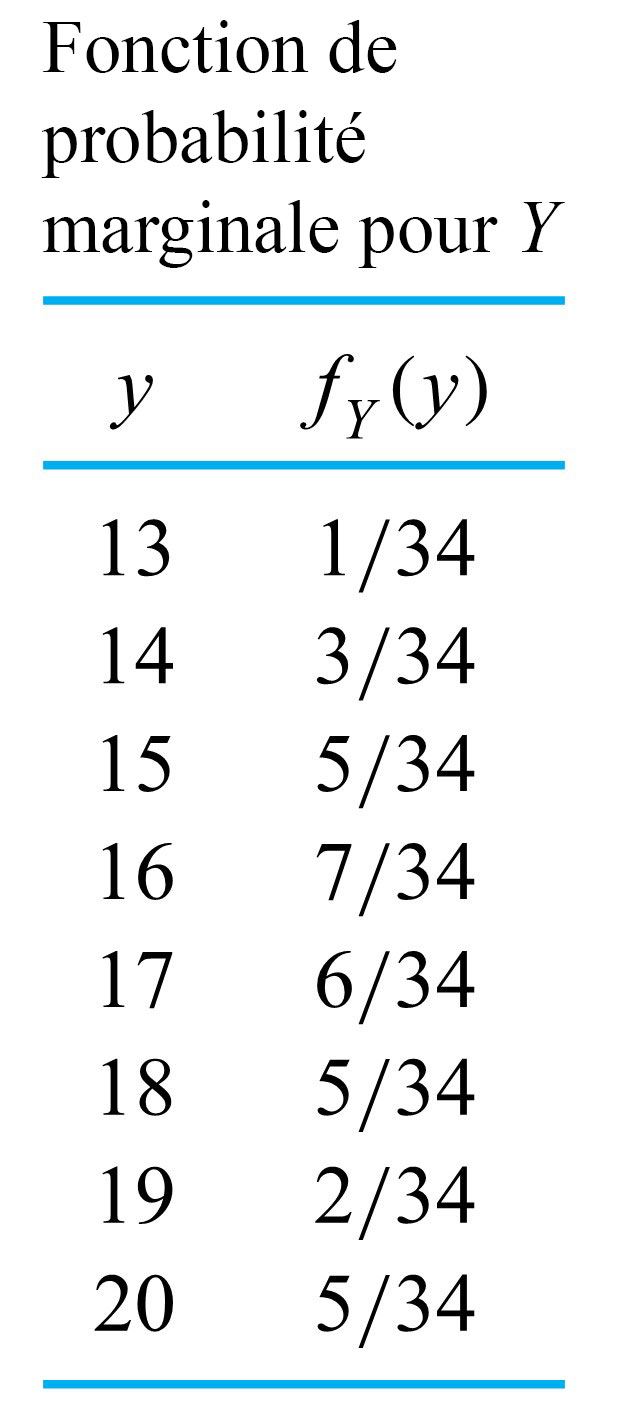

.![P[X=17] P[X=17]](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/0912a53b69eb7eb10e46c1f59352e883.png) , la probabilité que le couple mesuré sur le boulon 3 soit

, la probabilité que le couple mesuré sur le boulon 3 soit  , s’obtient en additionnant la colonne

, s’obtient en additionnant la colonne  dans le tableau 4.2.1.1. Autrement dit,

dans le tableau 4.2.1.1. Autrement dit,![\begin{aligned} P[X=17] & =f(17,17)+f(17,18)+f(17,19) \\ & =\frac{ 1}{ 34}+\frac{ 1}{ 34}+\frac{ 2}{ 34} \\ & =\frac{ 4}{ 34} \end{aligned} \begin{aligned} P[X=17] & =f(17,17)+f(17,18)+f(17,19) \\ & =\frac{ 1}{ 34}+\frac{ 1}{ 34}+\frac{ 2}{ 34} \\ & =\frac{ 4}{ 34} \end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/152ecf42295f0efb7bc4bd56de294bf7.png)

. On peut également additionner les lignes du même tableau pour obtenir les valeurs de la fonction de probabilité de

. On peut également additionner les lignes du même tableau pour obtenir les valeurs de la fonction de probabilité de  . On peut alors inscrire ces sommes dans les marges du tableau à double entrée, d’où l’appellation « distributions marginales ». L’encadré qui suit définit la terminologie utilisée dans le cas d’un problème à deux variables discrètes.

. On peut alors inscrire ces sommes dans les marges du tableau à double entrée, d’où l’appellation « distributions marginales ». L’encadré qui suit définit la terminologie utilisée dans le cas d’un problème à deux variables discrètes.

et

et  sont connues, y a-t-il alors une seule option pour

sont connues, y a-t-il alors une seule option pour

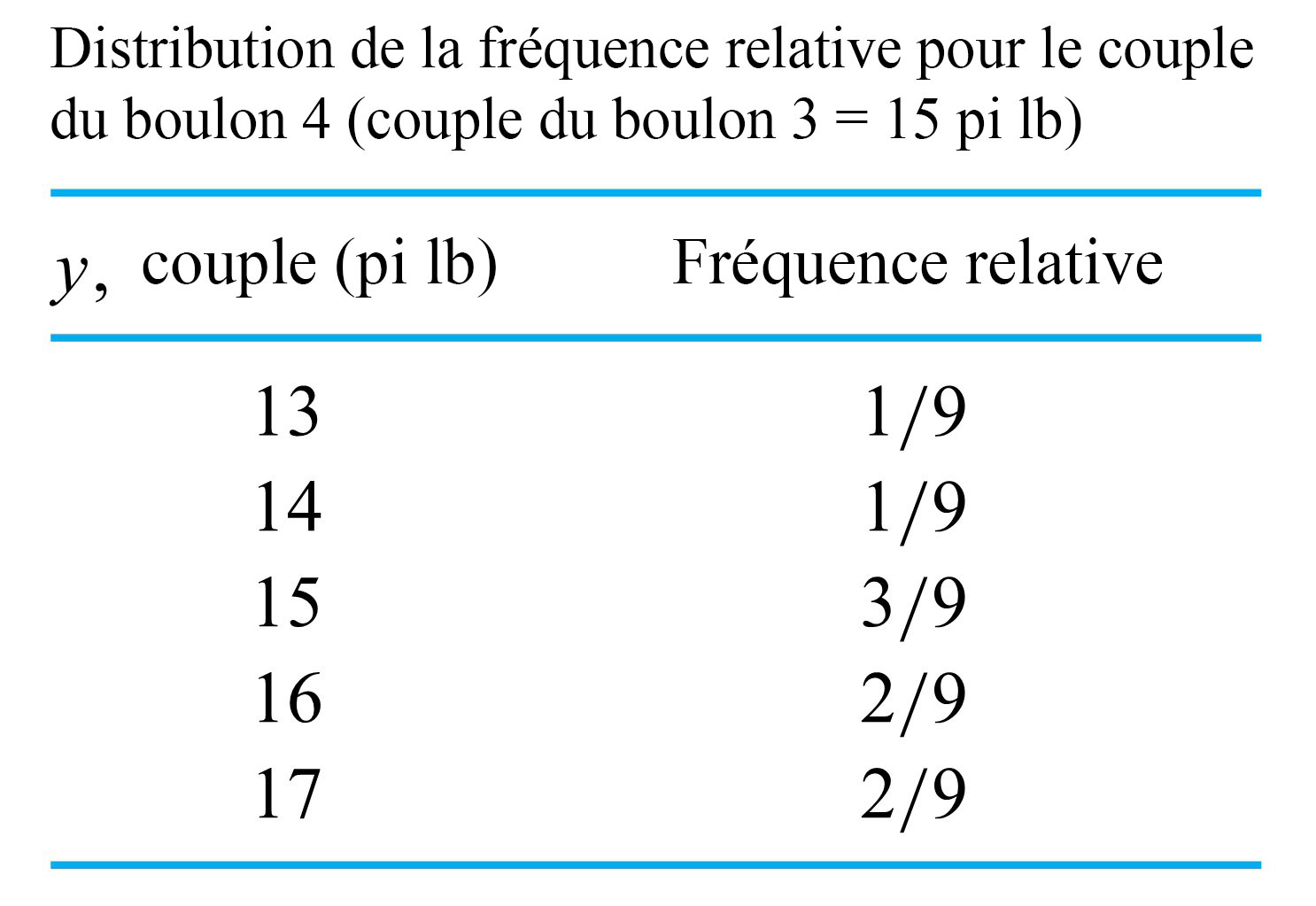

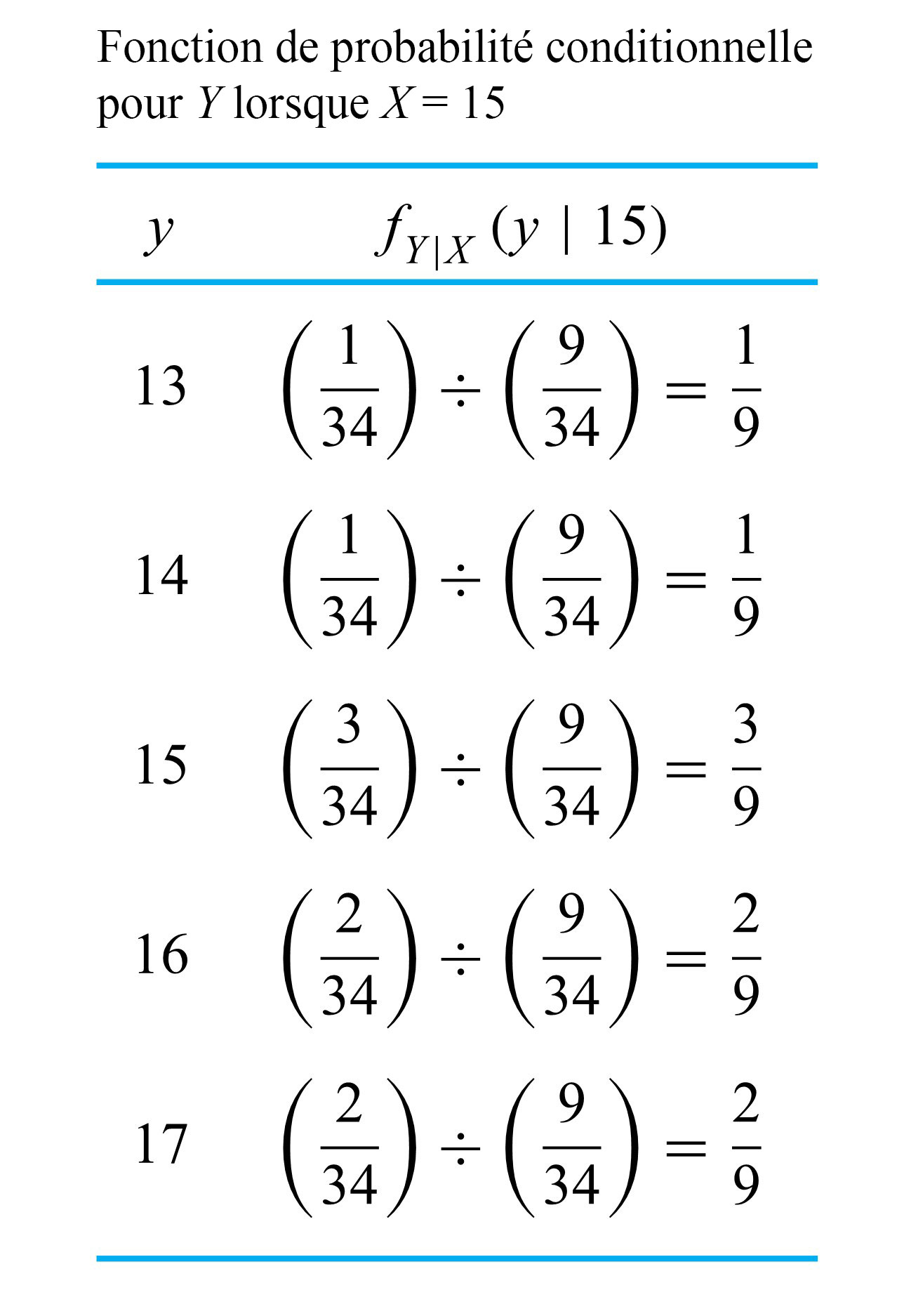

, un technicien qui vient de desserrer le boulon 3 et qui a mesuré le couple à la valeur

, un technicien qui vient de desserrer le boulon 3 et qui a mesuré le couple à la valeur  devrait avoir des attentes pour le couple du boulon 4

devrait avoir des attentes pour le couple du boulon 4  quelque peu différentes, à la lumière de la distribution marginale du tableau 4.2.1.3. Après tout, si on reprend les données du tableau 4.2.2.1, la distribution de la fréquence relative des couples des boulons 4 pour les composants dont le couple du boulon 3 est de

quelque peu différentes, à la lumière de la distribution marginale du tableau 4.2.1.3. Après tout, si on reprend les données du tableau 4.2.2.1, la distribution de la fréquence relative des couples des boulons 4 pour les composants dont le couple du boulon 3 est de  devrait modifier la distribution de probabilité de

devrait modifier la distribution de probabilité de

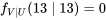

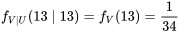

est la fonction de

est la fonction de

étant donné que

étant donné que  est la fonction de

est la fonction de

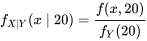

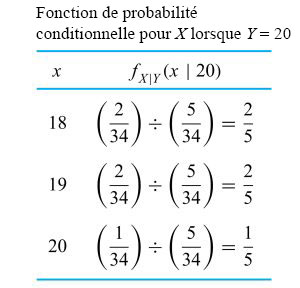

) pour les renormaliser (faire en sorte qu’elles totalisent 1). De même, l’équation 4.2.2.3 indique que si l’on considère uniquement la colonne

) pour les renormaliser (faire en sorte qu’elles totalisent 1). De même, l’équation 4.2.2.3 indique que si l’on considère uniquement la colonne  , la distribution conditionnelle appropriée pour

, la distribution conditionnelle appropriée pour

. Ainsi, en divisant les valeurs dans la colonne

. Ainsi, en divisant les valeurs dans la colonne

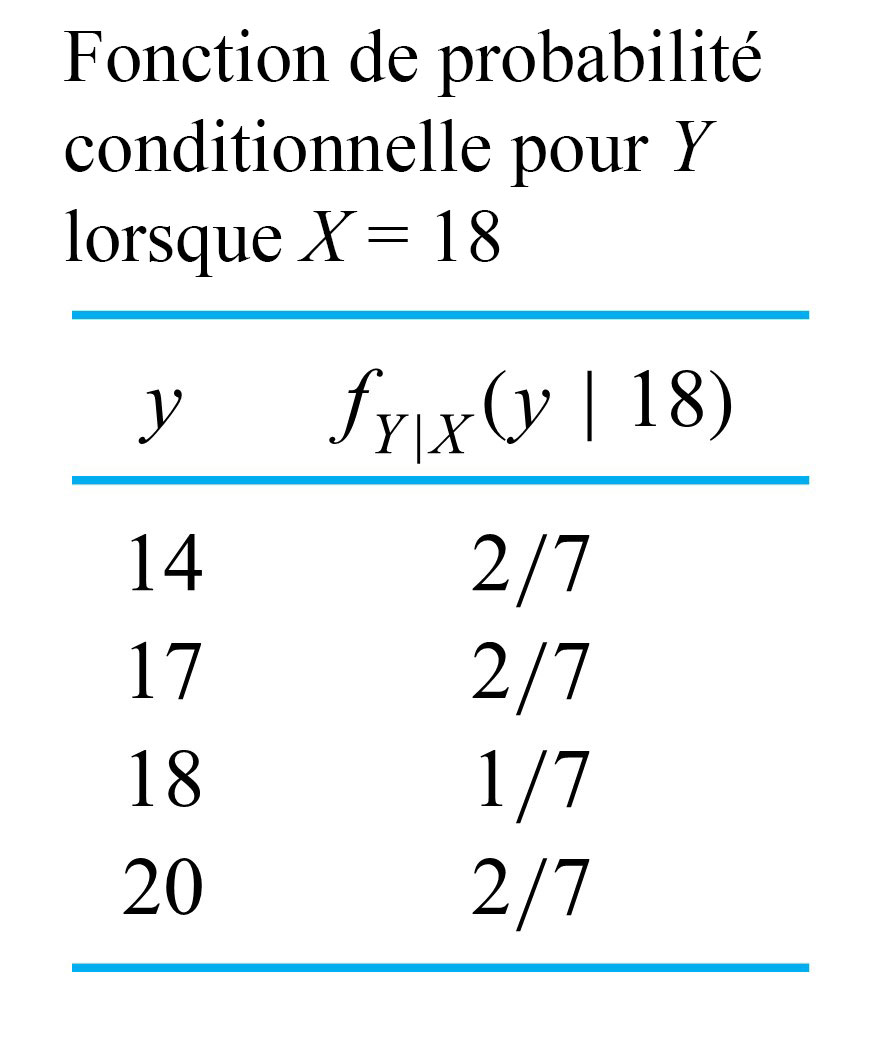

f_{Y \mid X}(y \mid 18) :

f_{Y \mid X}(y \mid 18) :

, présentée dans le tableau 4.2.2.3. Les tableaux 4.2.2.2 et 4.2.4.3 confirment que les distributions conditionnelles de

, présentée dans le tableau 4.2.2.3. Les tableaux 4.2.2.2 et 4.2.4.3 confirment que les distributions conditionnelles de

. Dans cette situation, l’équation 4.2.2.2 donne :

. Dans cette situation, l’équation 4.2.2.2 donne :

du tableau 4.2.1.2 divisées par la valeur marginale de

du tableau 4.2.1.2 divisées par la valeur marginale de  est répertoriée dans le tableau 4.2.2.4.

est répertoriée dans le tableau 4.2.2.4.

.

.  fournit des informations à propos de

fournit des informations à propos de

et tout

et tout

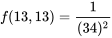

, il faut clairement que

, il faut clairement que![f(13,13)=P[U=13 \text { et } V=13]=0 f(13,13)=P[U=13 \text { et } V=13]=0](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/105fe4b3d7cbdef4eeb0ae8e8ae09cd5.png)

papiers, en suivant la fréquence relative du tableau 4.2.2.6. Ainsi, même si l’échantillonnage est effectué sans remplacement, les probabilités développées précédemment pour

papiers, en suivant la fréquence relative du tableau 4.2.2.6. Ainsi, même si l’échantillonnage est effectué sans remplacement, les probabilités développées précédemment pour

est beaucoup plus grande que la taille de l’échantillon

est beaucoup plus grande que la taille de l’échantillon  ont toutes la même distribution marginale et sont indépendantes, on dit qu’elles sont indépendantes et identiquement distribuées (iid).

ont toutes la même distribution marginale et sont indépendantes, on dit qu’elles sont indépendantes et identiquement distribuées (iid). et une fonction

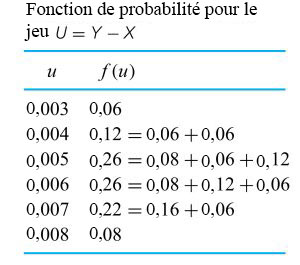

et une fonction  . L’objectif est de prédire le comportement de la variable aléatoire

. L’objectif est de prédire le comportement de la variable aléatoire

sont

sont  ,

,  constantes. La variable aléatoire

constantes. La variable aléatoire  a alors une moyenne de

a alors une moyenne de

, et les autres

, et les autres  .

. , et

, et

et de

et de  , ce n’est pas nécessaire de passer par l’étape intermédiaire consistant à obtenir la distribution de

, ce n’est pas nécessaire de passer par l’étape intermédiaire consistant à obtenir la distribution de  . Autrement dit, lorsque les variables aléatoires

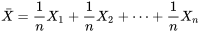

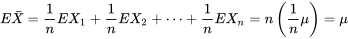

. Autrement dit, lorsque les variables aléatoires

et

et

» title= »\begin{aligned}\operatorname{Var( \bar{X} )} & =\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_1)} +\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_2)} +\cdots+\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_{n})} \\& =n\left(\frac{ 1}{n}\right)^2 \sigma^2=\frac{\sigma^2}{n}\end{aligned}

» title= »\begin{aligned}\operatorname{Var( \bar{X} )} & =\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_1)} +\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_2)} +\cdots+\left(\frac{ 1}{n}\right)^2 \operatorname{Var(X_{n})} \\& =n\left(\frac{ 1}{n}\right)^2 \sigma^2=\frac{\sigma^2}{n}\end{aligned} ayant la distribution de probabilité centrée sur la moyenne de la population

ayant la distribution de probabilité centrée sur la moyenne de la population ![\bar{X}[/latex] dans le cadre d’un échantillonnage aléatoire avec remplacement, sont également des descriptions approximatives du comportement de <img src="https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=&fg=000000&font=TeX&svg=1" alt="" title="" class="latex mathjax" />\bar{X} \bar{X}[/latex] dans le cadre d’un échantillonnage aléatoire avec remplacement, sont également des descriptions approximatives du comportement de <img src="https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=&fg=000000&font=TeX&svg=1" alt="" title="" class="latex mathjax" />\bar{X}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/8b4b6ad5b0b43eec0928cf7d1713308a.png) dans le cadre d’une échantillonnage aléatoire simple dans des contextes énumératifs. (Rappelons la discussion sur l’indépendance approximative des observations résultant d’un échantillonnage aléatoire simple dans une grande population.)

dans le cadre d’une échantillonnage aléatoire simple dans des contextes énumératifs. (Rappelons la discussion sur l’indépendance approximative des observations résultant d’un échantillonnage aléatoire simple dans une grande population.) .)

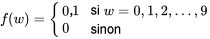

.) le dernier chiffre du numéro de série observé lundi prochain à 9 h.

le dernier chiffre du numéro de série observé lundi prochain à 9 h. le dernier chiffre du numéro de série observé le lundi suivant à 9 h.

le dernier chiffre du numéro de série observé le lundi suivant à 9 h. sont indépendantes, chacune avec la fonction de probabilité marginale :

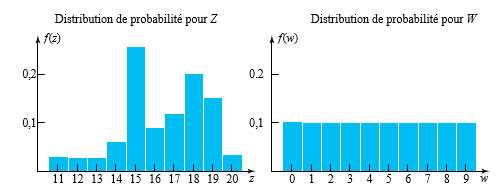

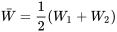

sont indépendantes, chacune avec la fonction de probabilité marginale :

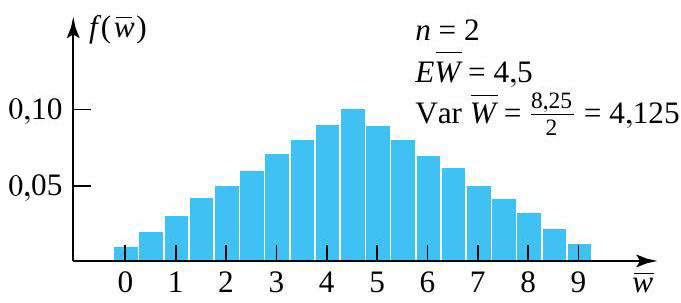

a la fonction de probabilité donnée au tableau 4.2.4.1 et illustrée à la figure 4.2.4.2.

a la fonction de probabilité donnée au tableau 4.2.4.1 et illustrée à la figure 4.2.4.2.

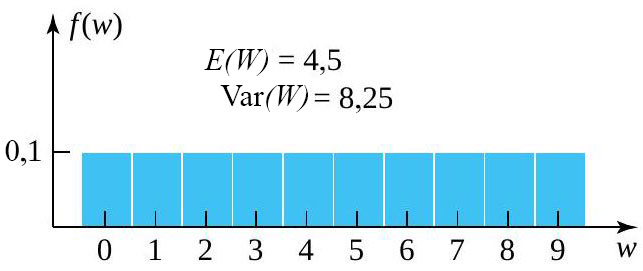

, avec

, avec

et une taille d’échantillon de

et une taille d’échantillon de  commence à prendre une forme de cloche – à tout le moins, plus que la distribution sous-jacente. La raison en est claire. Plus on s’éloigne de la moyenne ou de la valeur centrale de

commence à prendre une forme de cloche – à tout le moins, plus que la distribution sous-jacente. La raison en est claire. Plus on s’éloigne de la moyenne ou de la valeur centrale de  et

et  qui peuvent produire une valeur donnée de

qui peuvent produire une valeur donnée de  . Par exemple, pour que

. Par exemple, pour que  , il faut que

, il faut que  et

et  – autrement dit, il faut non pas une, mais deux valeurs extrêmes. En revanche, il existe 10 combinaisons différentes de

– autrement dit, il faut non pas une, mais deux valeurs extrêmes. En revanche, il existe 10 combinaisons différentes de  .

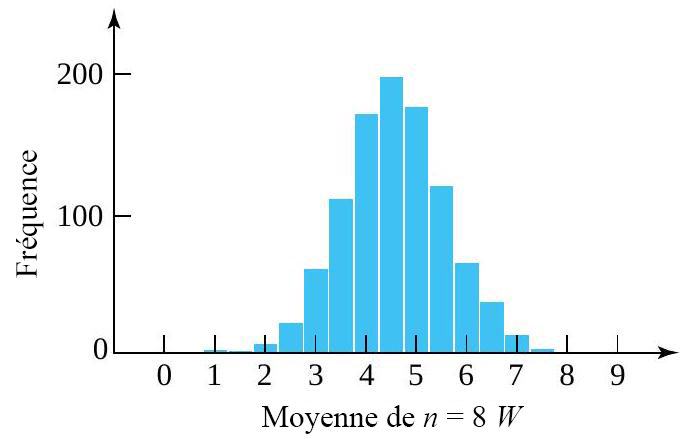

. (avec une distribution marginale qui a été simulée et chaque ensemble pondéré pour produire 1 000 valeurs simulées de

(avec une distribution marginale qui a été simulée et chaque ensemble pondéré pour produire 1 000 valeurs simulées de  . Remarquez le caractère en forme de cloche du graphique. (La moyenne simulée de

. Remarquez le caractère en forme de cloche du graphique. (La moyenne simulée de  , alors que la variance de

, alors que la variance de  , en étroite concordance avec les formules.)

, en étroite concordance avec les formules.)

.

. est généralement suffisant pour que

est généralement suffisant pour que  durées de service excessives pour obtenir :

durées de service excessives pour obtenir : le temps moyen de l’échantillon (au-dessus du seuil de

le temps moyen de l’échantillon (au-dessus du seuil de  ) nécessaire pour réaliser les 100 prochaines ventes de timbres.

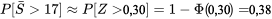

) nécessaire pour réaliser les 100 prochaines ventes de timbres. 17] » title= »P[\bar{S}>17] » class= »latex mathjax »>.

17] » title= »P[\bar{S}>17] » class= »latex mathjax »>. est plausible pour les temps de service excessifs individuels

est plausible pour les temps de service excessifs individuels

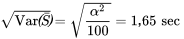

, selon nos équations. En outre, en tenant compte du fait que

, selon nos équations. En outre, en tenant compte du fait que

et

et ![P[\bar{S}>17] P[\bar{S}>17]](https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=P%5B%5Cbar%7BS%7D%3E17%5D&fg=000000&font=TeX&svg=1) .

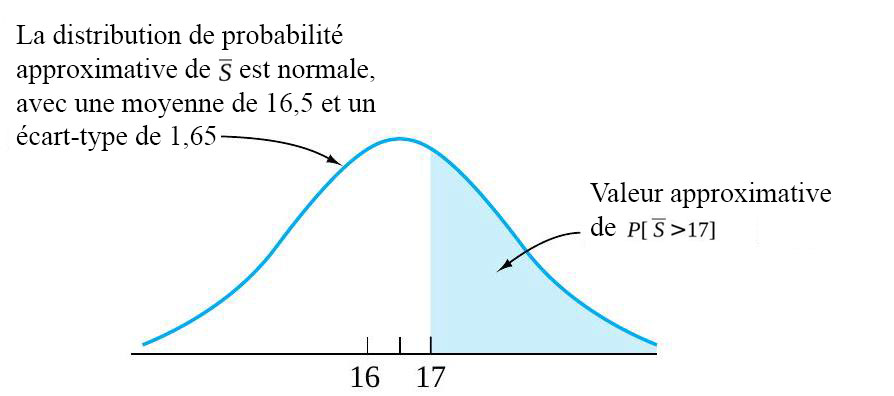

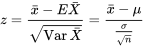

. avant de consulter la table normale standard. Dans ce cas, la moyenne et l’écart-type à utiliser sont (respectivement)

avant de consulter la table normale standard. Dans ce cas, la moyenne et l’écart-type à utiliser sont (respectivement)  et

et  . Les cotes

. Les cotes

17] \approx P[Z>0,30]=1-\Phi(0,30)=0,38″ title= »P[\bar{S}>17] \approx P[Z>0,30]=1-\Phi(0,30)=0,38″ class= »latex mathjax »>

17] \approx P[Z>0,30]=1-\Phi(0,30)=0,38″ title= »P[\bar{S}>17] \approx P[Z>0,30]=1-\Phi(0,30)=0,38″ class= »latex mathjax »>

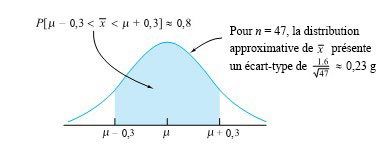

0,3 g

0,3 g

< z

< z

. Soit

. Soit

.

.

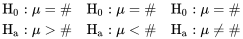

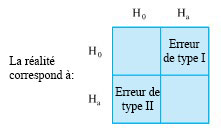

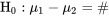

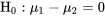

. Elle est de la même forme que l’hypothèse nulle correspondante, à l’exception du signe d’égalité qui est remplacé par ≠, > ou <.

. Elle est de la même forme que l’hypothèse nulle correspondante, à l’exception du signe d’égalité qui est remplacé par ≠, > ou <. \# & \mathrm{H}_{\mathrm{a}}: \mu\# & \mathrm{H}_{\mathrm{a}}: \mu

\# & \mathrm{H}_{\mathrm{a}}: \mu\# & \mathrm{H}_{\mathrm{a}}: \mu

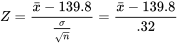

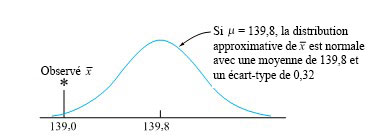

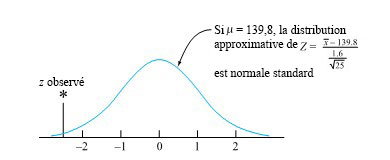

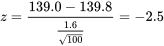

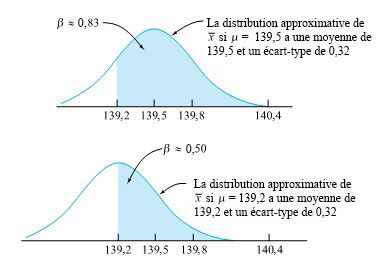

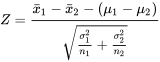

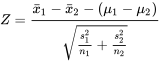

. En utilisant la forme 5.1.2.4, la distribution de référence sera toujours la même, à savoir la distribution normale réduite.

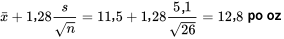

. En utilisant la forme 5.1.2.4, la distribution de référence sera toujours la même, à savoir la distribution normale réduite. 139,8 g.

139,8 g.

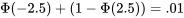

![\begin{aligned} & P[\text { une variable normale réduite } \leq-2,5] \\ & \quad+P[\text { une variable normale réduite } \geq 2,5] \\ & \quad=P[\mid \text { une variable normale réduite } \mid \geq 2,5] \\ & \quad=0,01 \end{aligned} \begin{aligned} & P[\text { une variable normale réduite } \leq-2,5] \\ & \quad+P[\text { une variable normale réduite } \geq 2,5] \\ & \quad=P[\mid \text { une variable normale réduite } \mid \geq 2,5] \\ & \quad=0,01 \end{aligned}](https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/1ea01517eb8ce96743c075f3c7345cb8.png)

.

.

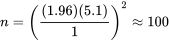

et la réalité, mais aussi de la taille de l’échantillon. Avec un échantillon de taille suffisante, tout écart par rapport à H0 peut être considéré comme « hautement significatif », qu’il ait une importance pratique ou non.

et la réalité, mais aussi de la taille de l’échantillon. Avec un échantillon de taille suffisante, tout écart par rapport à H0 peut être considéré comme « hautement significatif », qu’il ait une importance pratique ou non.

.

.

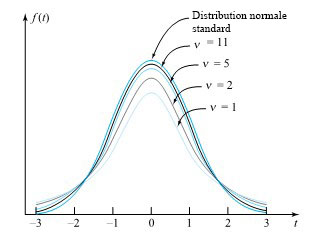

degrés de liberté et la distribution normale standard sont impossibles à distinguer.

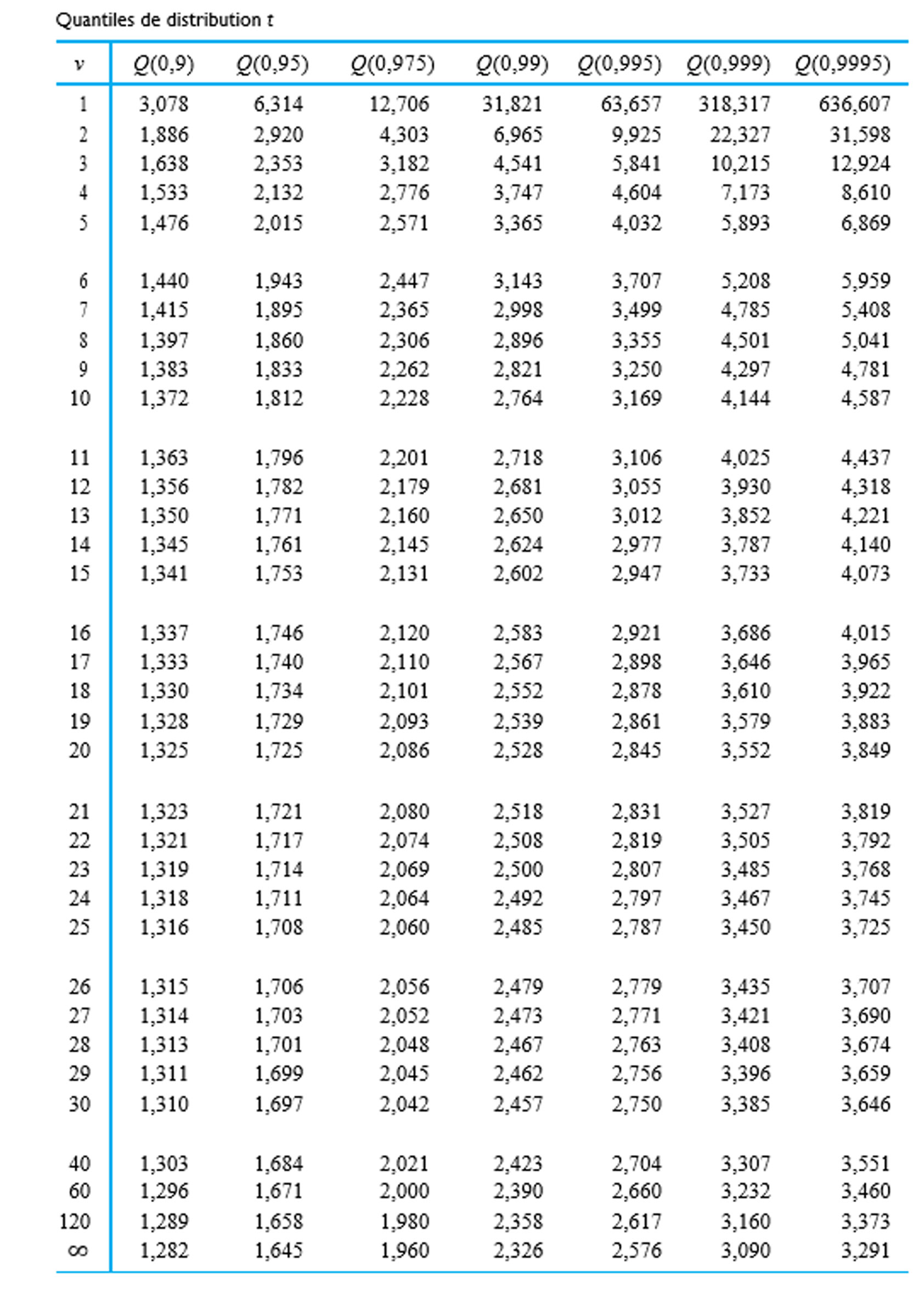

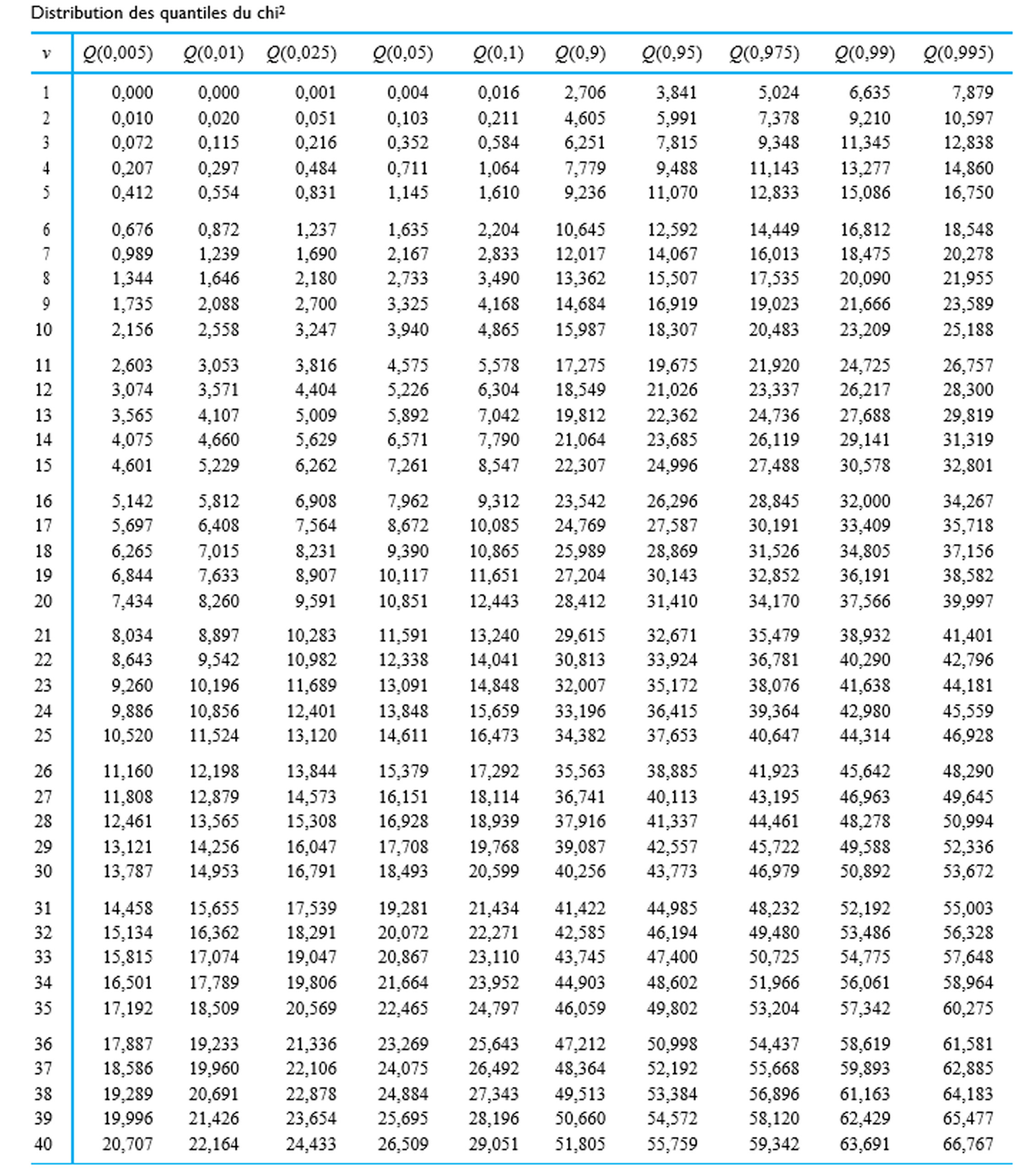

degrés de liberté et la distribution normale standard sont impossibles à distinguer. . On utilise plutôt des tables (ou des logiciels statistiques) pour évaluer les quantiles communs de la distribution t et ainsi obtenir des limites approximatives sur les types de probabilités nécessaires pour les tests d’hypothèse. La table A1.3 de l’annexe 1 des tables statistiques représente un tableau typique de quantiles t. Les colonnes représentent les probabilités cumulatives et les lignes, les valeurs du paramètre des degrés de liberté,

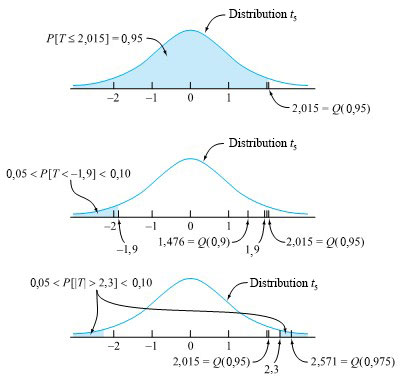

. On utilise plutôt des tables (ou des logiciels statistiques) pour évaluer les quantiles communs de la distribution t et ainsi obtenir des limites approximatives sur les types de probabilités nécessaires pour les tests d’hypothèse. La table A1.3 de l’annexe 1 des tables statistiques représente un tableau typique de quantiles t. Les colonnes représentent les probabilités cumulatives et les lignes, les valeurs du paramètre des degrés de liberté,  . Autrement dit,

. Autrement dit,

attribue une probabilité correspondant au niveau de confiance souhaité à l’intervalle compris entre -t et t. De même, l’hypothèse nulle

attribue une probabilité correspondant au niveau de confiance souhaité à l’intervalle compris entre -t et t. De même, l’hypothèse nulle

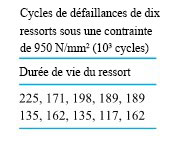

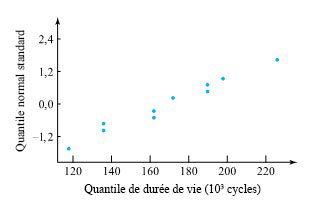

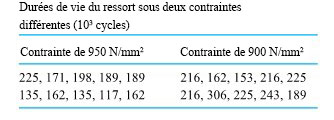

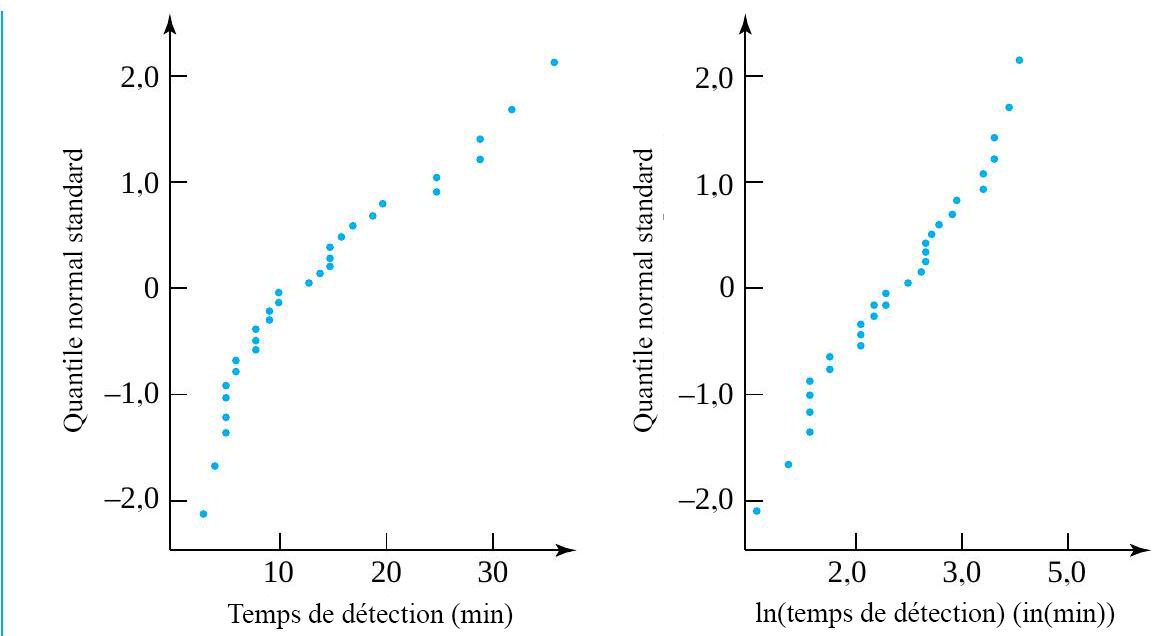

? » Comme il n’y a que de n = 10 observations, la méthode pour les grands échantillons vue au module 5.1 ne s’applique pas. Seule la méthode indiquée par l’expression 5.2.1.5 peut potentiellement être utilisée, et pour qu’elle convienne, les durées de vie doivent être distribuées normalement.

? » Comme il n’y a que de n = 10 observations, la méthode pour les grands échantillons vue au module 5.1 ne s’applique pas. Seule la méthode indiquée par l’expression 5.2.1.5 peut potentiellement être utilisée, et pour qu’elle convienne, les durées de vie doivent être distribuées normalement.

et on choisit t > 0 de sorte que

et on choisit t > 0 de sorte que![P[-t< \text{une variable aléatoire } t_9 < t] = 0,90 P[-t< \text{une variable aléatoire } t_9 < t] = 0,90](https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=P%5B-t%3C%20%5Ctext%7Bune%20variable%20al%C3%A9atoire%20%7D%20t_9%20%3C%20t%5D%20%3D%200%2C90&fg=000000&font=TeX&svg=1)

et

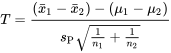

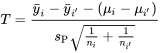

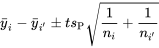

et  pour représenter les moyennes distributionnelles sous-jacentes correspondant aux première et deuxième conditions et

pour représenter les moyennes distributionnelles sous-jacentes correspondant aux première et deuxième conditions et  et

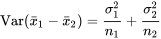

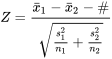

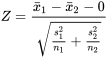

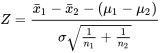

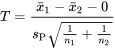

et  pour représenter les moyennes de l’échantillon correspondantes. Or, si les deux mécanismes de génération de données correspondent essentiellement et conceptuellement à un échantillonnage avec remplacement à partir de deux distributions, la partie 4 indique que

pour représenter les moyennes de l’échantillon correspondantes. Or, si les deux mécanismes de génération de données correspondent essentiellement et conceptuellement à un échantillonnage avec remplacement à partir de deux distributions, la partie 4 indique que  , et que

, et que . La différence entre les moyennes des échantillons

. La différence entre les moyennes des échantillons

et

et  sont grands (de sorte que

sont grands (de sorte que

ni

ni  . Heureusement, si

. Heureusement, si

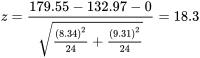

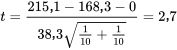

= 8,34 g,

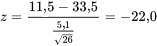

= 8,34 g,  = 9,31 g, le modèle de test d’hypothèse en cinq étapes conduit au récapitulatif suivant :

= 9,31 g, le modèle de test d’hypothèse en cinq étapes conduit au récapitulatif suivant :

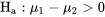

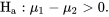

0″ title= »\mathrm{H}_{\mathrm{a}}: \mu_1-\mu_2>0″ class= »latex mathjax »>

0″ title= »\mathrm{H}_{\mathrm{a}}: \mu_1-\mu_2>0″ class= »latex mathjax »>

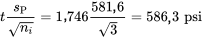

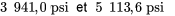

et

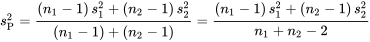

et  , la variance pondérée de l’échantillon,

, la variance pondérée de l’échantillon,

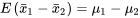

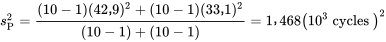

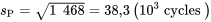

est égal à la racine carrée de

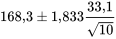

est égal à la racine carrée de  cycles et

cycles et

suivant des distributions normales avec

suivant des distributions normales avec

attribue à l’intervalle entre -t et t correspond à la confiance souhaitée. Dans les mêmes conditions, l’hypothèse

attribue à l’intervalle entre -t et t correspond à la confiance souhaitée. Dans les mêmes conditions, l’hypothèse

condition 1 et la contrainte de

condition 1 et la contrainte de  0 . » title= »\mathrm{H}_{\mathrm{a}}: \mu_1-\mu_2>0 . » class= »latex mathjax »>

0 . » title= »\mathrm{H}_{\mathrm{a}}: \mu_1-\mu_2>0 . » class= »latex mathjax »>

![P[\text{une variable aléatoire } t_{ 18} \geq 2,7] P[\text{une variable aléatoire } t_{ 18} \geq 2,7]](https://atu0g9ctah.execute-api.ca-central-1.amazonaws.com/latest/latex?latex=P%5B%5Ctext%7Bune%20variable%20al%C3%A9atoire%20%7D%20t_%7B%2018%7D%20%5Cgeq%202%2C7%5D&fg=000000&font=TeX&svg=1) se situe entre 0,01 et 0,005, ce qui constitue une preuve solide que la contrainte faible est associée à une durée de vie plus élevée en moyenne.

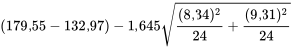

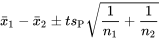

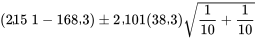

se situe entre 0,01 et 0,005, ce qui constitue une preuve solide que la contrainte faible est associée à une durée de vie plus élevée en moyenne. . Les bornes de l’intervalle de confiance pour \

. Les bornes de l’intervalle de confiance pour \

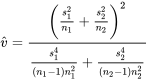

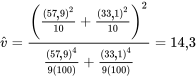

est telle que la distribution

est telle que la distribution  avec

avec  et

et

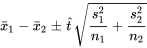

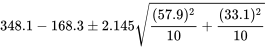

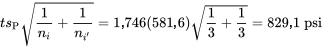

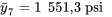

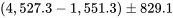

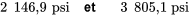

est donc 2,145. Les bornes à 95 % de l’expression 5.3.3.8 pour la différence (

est donc 2,145. Les bornes à 95 % de l’expression 5.3.3.8 pour la différence ( }) sont donc les suivantes :

}) sont donc les suivantes :

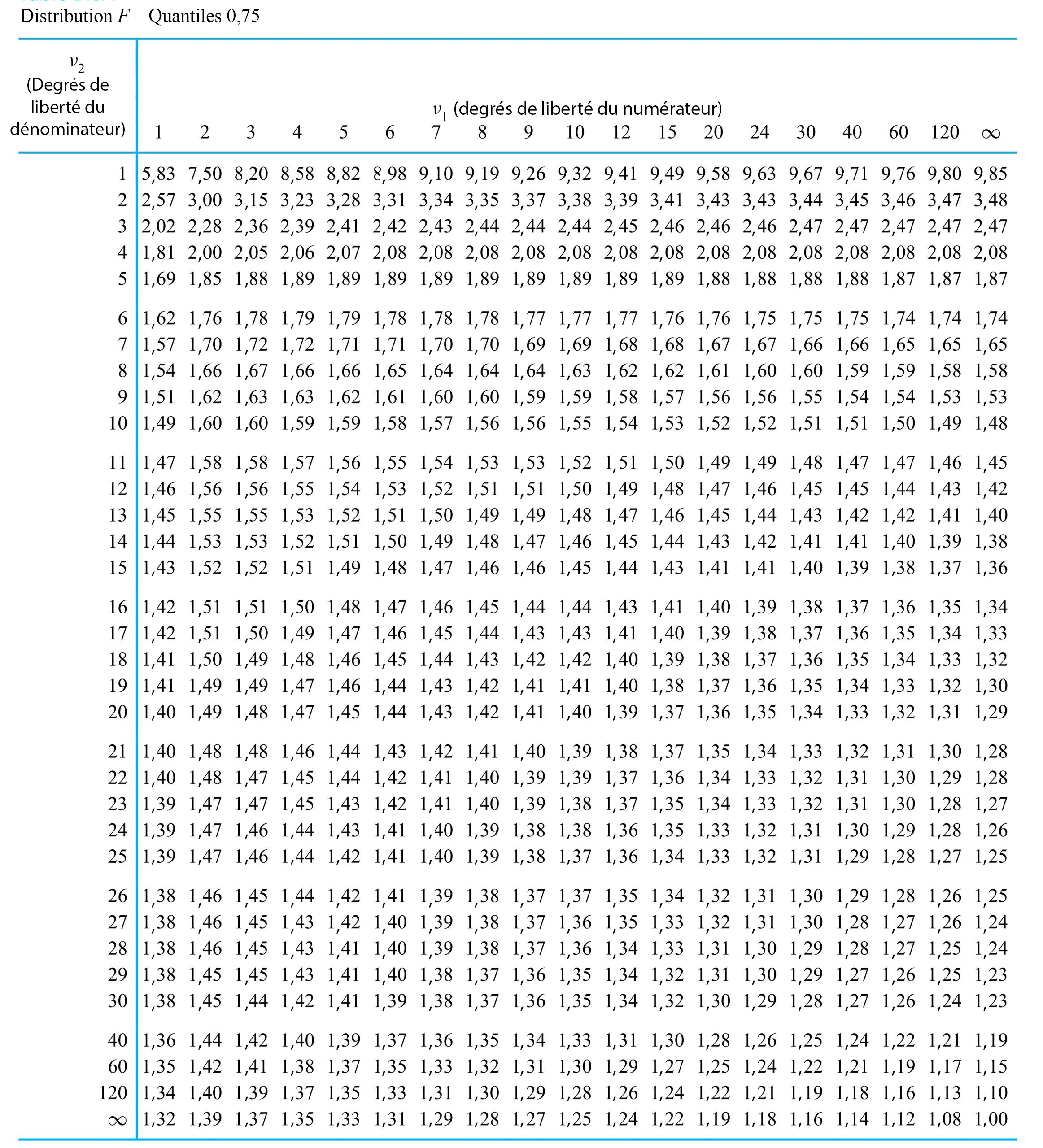

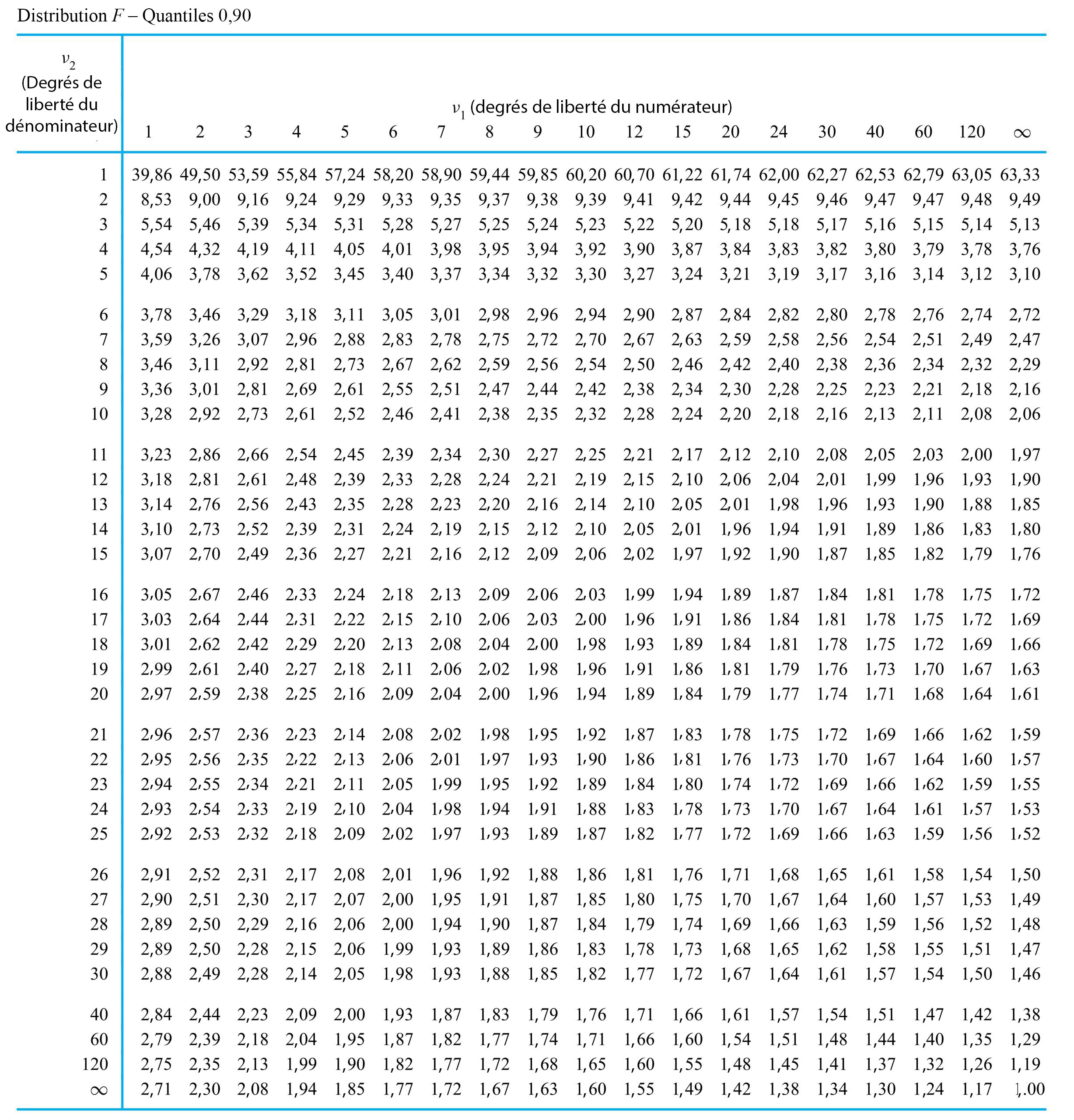

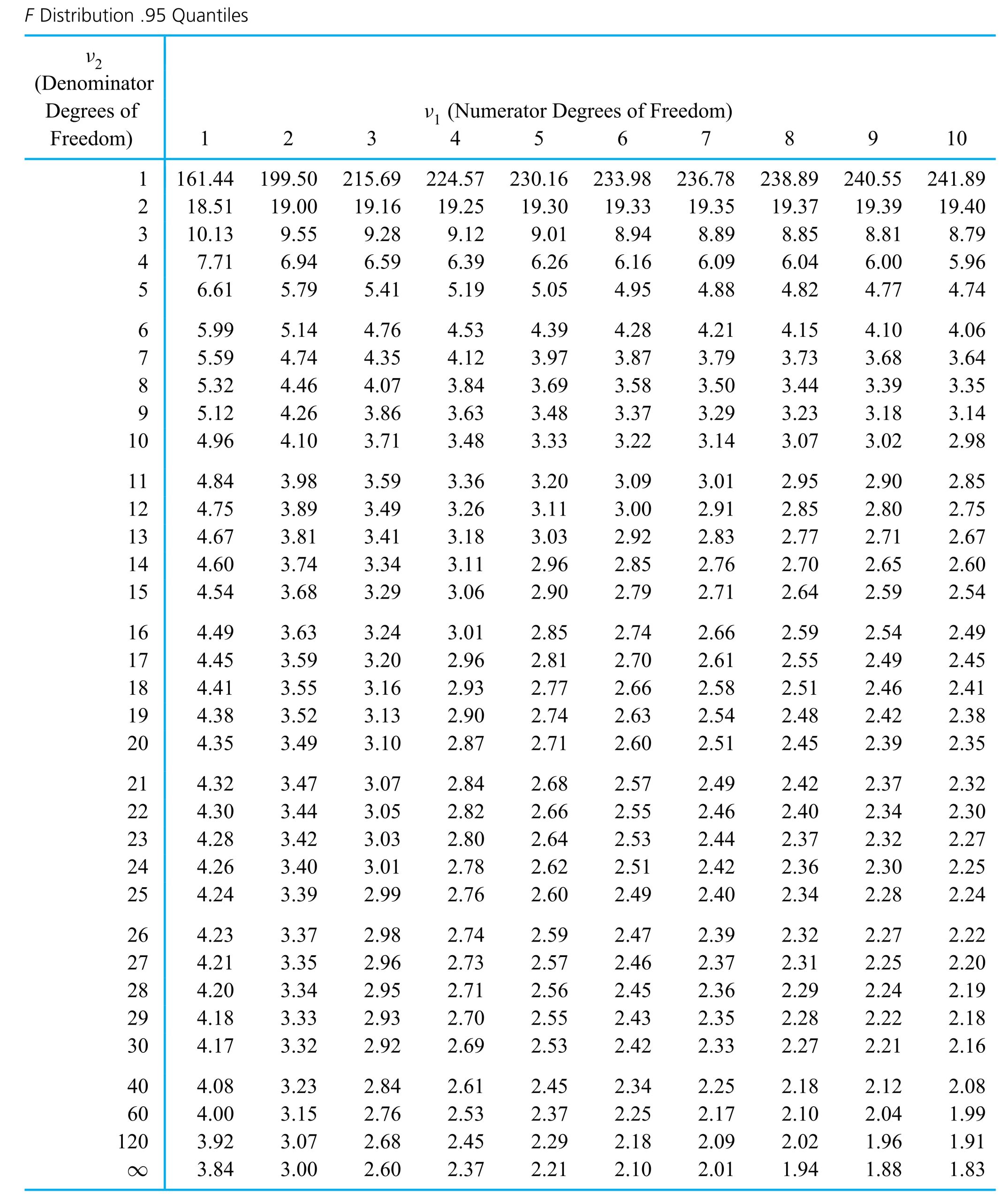

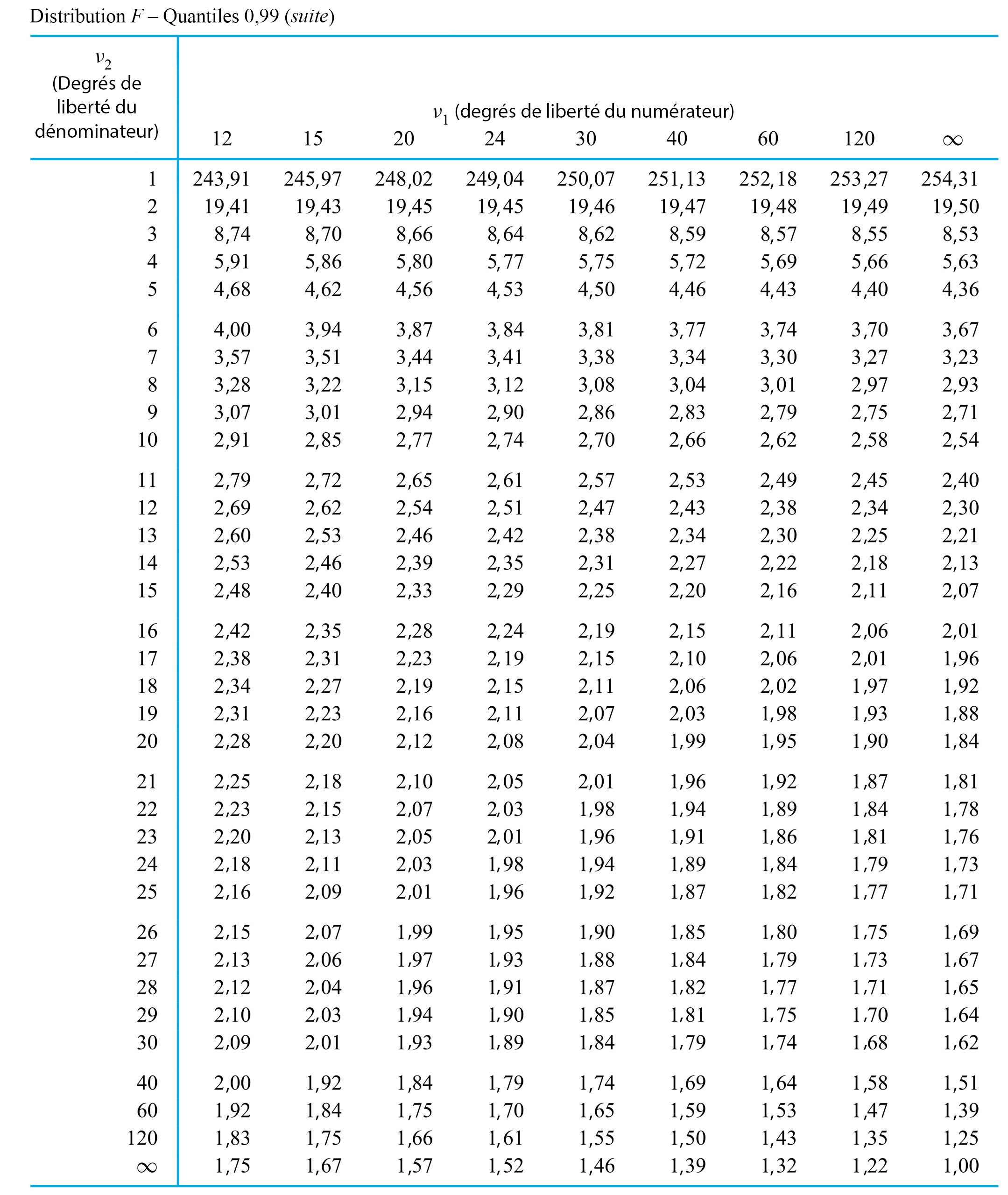

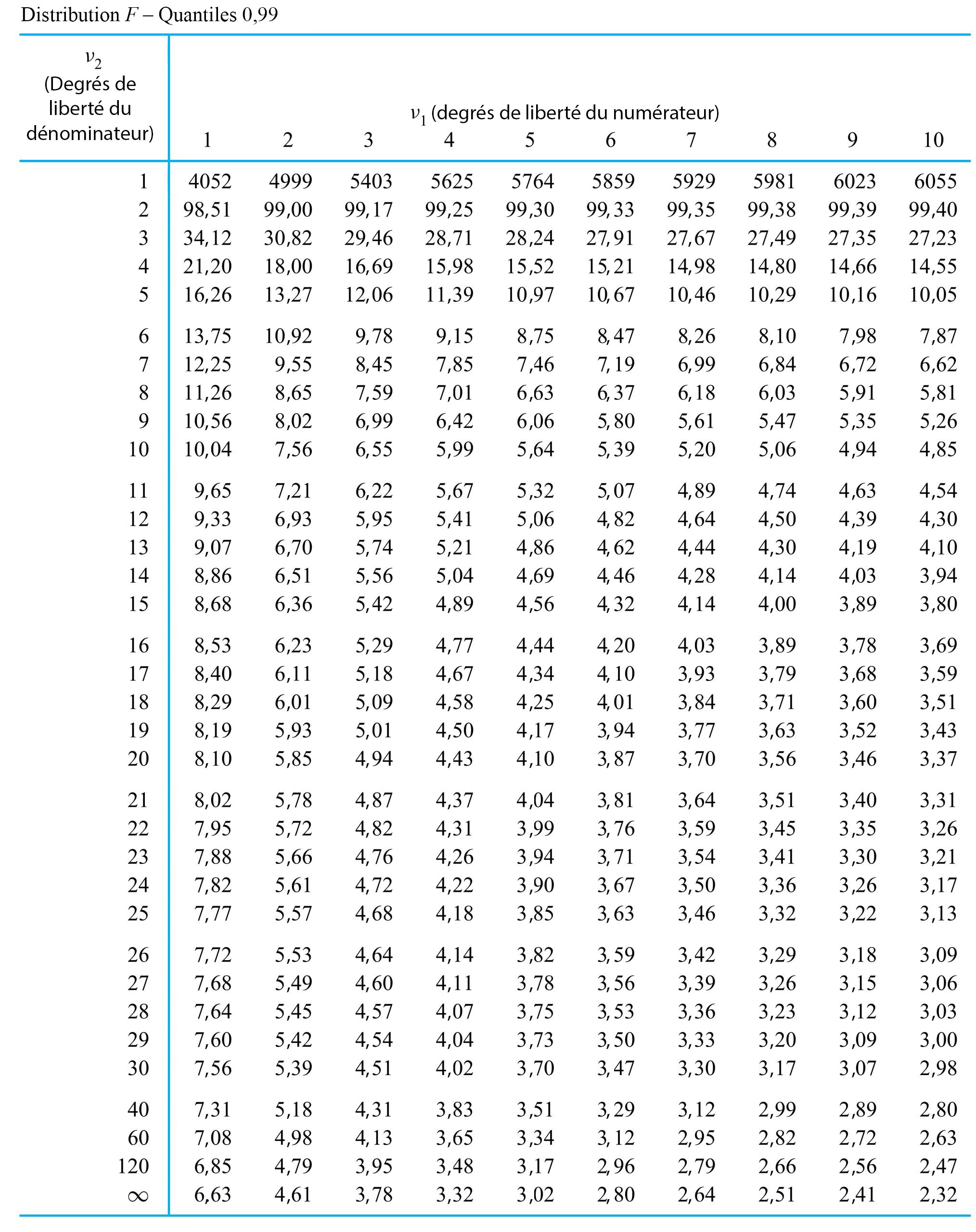

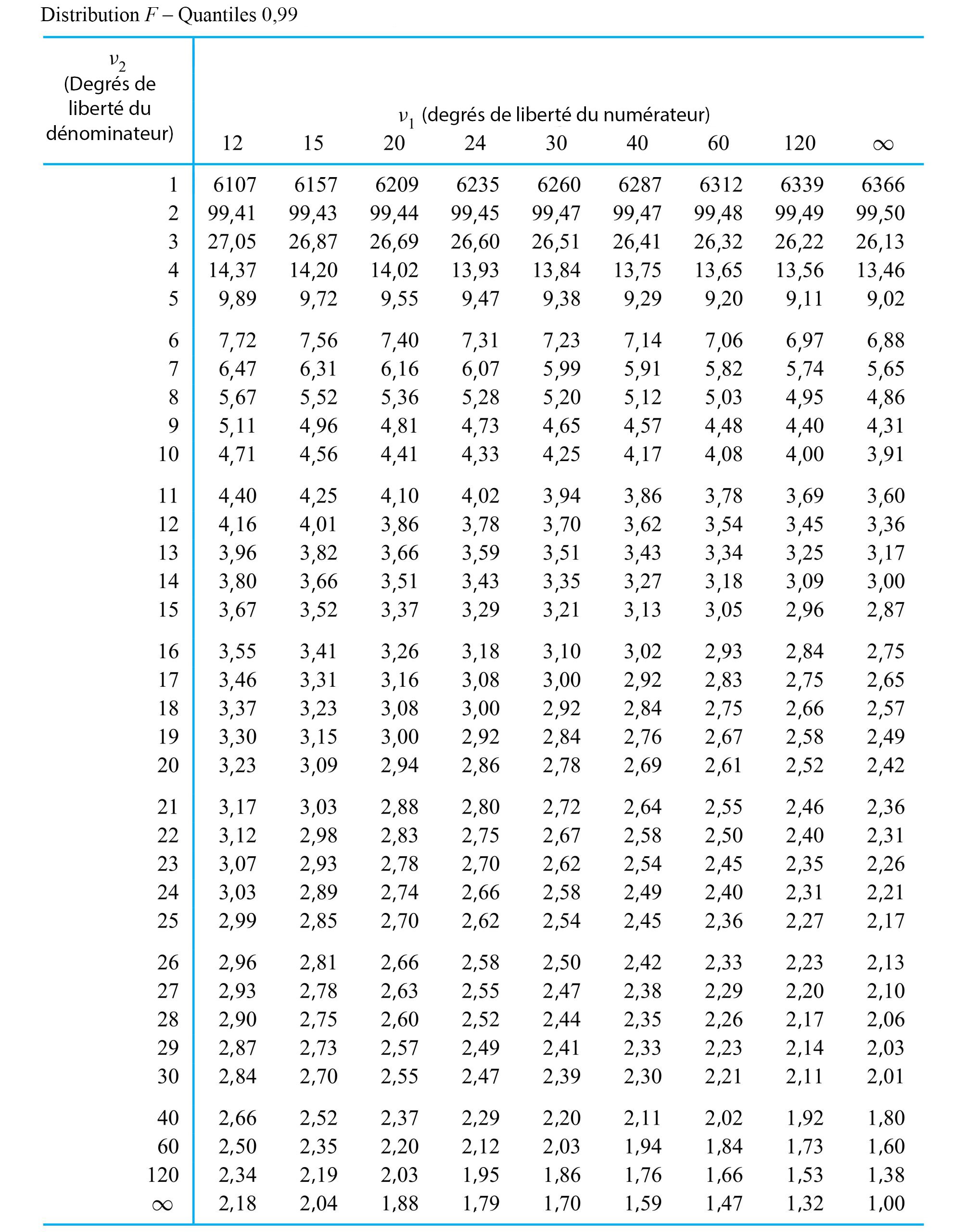

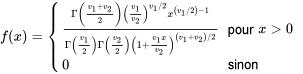

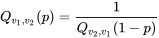

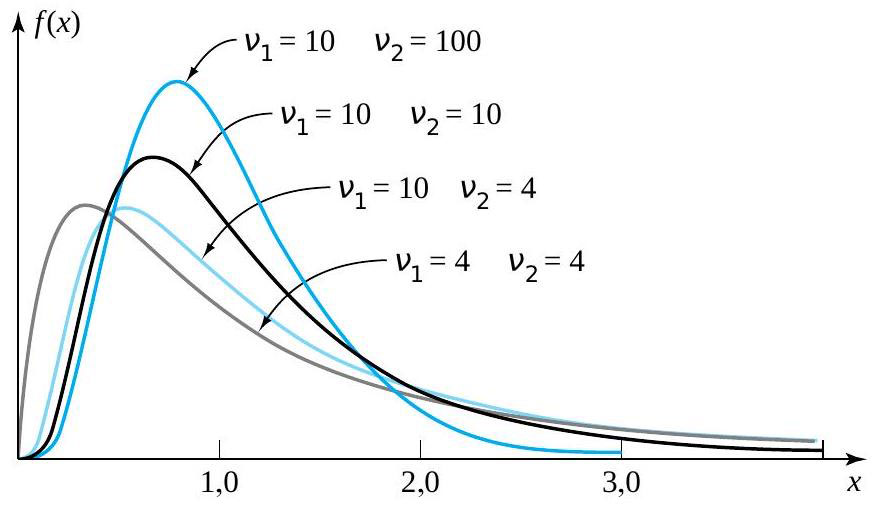

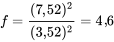

de Fisher-Snedecor avec paramètres de degrés de liberté du numérateur et du dénominateur

de Fisher-Snedecor avec paramètres de degrés de liberté du numérateur et du dénominateur  et

et  désigne une distribution de probabilité continue ayant pour densité de probabilité

désigne une distribution de probabilité continue ayant pour densité de probabilité 0 \\ 0 & \text { sinon }\end{cases} » title= »f(x)= \begin{cases}\frac{\Gamma\left(\frac{v_1+v_2}\right)\left(\frac{v_1}{v_2}\right)^{v_1 / 2} x^{\left(v_1 / 2\right)-1}}{\Gamma\left(\frac{v_1}\right) \Gamma\left(\frac{v_2}\right)\left(1+\frac{v_1 x}{v_2}\right)^{\left(v_1+v_2\right) / 2}} & \text { pour } x>0 \\ 0 & \text { sinon }\end{cases} » class= »latex mathjax »>

0 \\ 0 & \text { sinon }\end{cases} » title= »f(x)= \begin{cases}\frac{\Gamma\left(\frac{v_1+v_2}\right)\left(\frac{v_1}{v_2}\right)^{v_1 / 2} x^{\left(v_1 / 2\right)-1}}{\Gamma\left(\frac{v_1}\right) \Gamma\left(\frac{v_2}\right)\left(1+\frac{v_1 x}{v_2}\right)^{\left(v_1+v_2\right) / 2}} & \text { pour } x>0 \\ 0 & \text { sinon }\end{cases} » class= »latex mathjax »> .

. (le degré de liberté du numérateur) et

(le degré de liberté du numérateur) et  (le degré de liberté du dénominateur). Les valeurs de

(le degré de liberté du dénominateur). Les valeurs de  et

et  permet de déterminer les quantiles pour de faibles

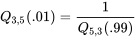

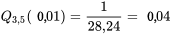

permet de déterminer les quantiles pour de faibles  la fonction quantile

la fonction quantile  la fonction quantile pour la distribution

la fonction quantile pour la distribution

. Cherchons les quantiles .95 et .01 de la distribution de

. Cherchons les quantiles .95 et .01 de la distribution de  » title= »P[V> » class= »latex mathjax »> 4,0] et <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/109e3ebc4e9893167fd000040c2f0f7b.png » alt= »P[V<0,3] » title= »P[V.

» title= »P[V> » class= »latex mathjax »> 4,0] et <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/109e3ebc4e9893167fd000040c2f0f7b.png » alt= »P[V<0,3] » title= »P[V. , colonne

, colonne  , ligne

, ligne  , on trouve dans un premier temps le nombre 5,41. Autrement dit,

, on trouve dans un premier temps le nombre 5,41. Autrement dit,  , ce qui équivaut à dire que <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/e87e037cb2d9dc42f354bdabcc0770e6.png » alt= »P[V<5,41]=0,95″ title= »P[V.

, ce qui équivaut à dire que <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/e87e037cb2d9dc42f354bdabcc0770e6.png » alt= »P[V<5,41]=0,95″ title= »P[V. de la distribution

de la distribution

et la ligne

et la ligne  de la table de quantiles

de la table de quantiles  , on obtient :

, on obtient :

4,0] » title= »P[V>4,0] » class= »latex mathjax »>, on constate (en utilisant la colonne [/latex]v_{1}=3[/latex] et la ligne

4,0] » title= »P[V>4,0] » class= »latex mathjax »>, on constate (en utilisant la colonne [/latex]v_{1}=3[/latex] et la ligne  ), dans la distribution

), dans la distribution  , puis utiliser l’expression (5.2.4.2). En utilisant les colonnes

, puis utiliser l’expression (5.2.4.2). En utilisant les colonnes  et

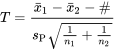

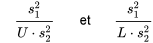

et  des distributions sous-jacentes. Autrement dit, lorsque

des distributions sous-jacentes. Autrement dit, lorsque  et <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/4271702ef47127321ec8a369ddc787e9.png » alt= »s_^

et <img src= »https://ecampusontario.pressbooks.pub/app/uploads/sites/4171/2024/03/4271702ef47127321ec8a369ddc787e9.png » alt= »s_^ . (

. (  degrés de liberté associés et figure dans le numérateur de cette expression, tandis que

degrés de liberté associés et figure dans le numérateur de cette expression, tandis que  a

a  degrés de liberté associés et figure dans le dénominateur, motivant le langage introduit à la définition 5.2.4.1)

degrés de liberté associés et figure dans le dénominateur, motivant le langage introduit à la définition 5.2.4.1) . Il est par exemple possible de choisir L et U, les bons quantiles F, de sorte que la probabilité que la variable (5.2.4.3) se situe entre L et U corresponde au niveau de confiance souhaité. (L et U sont typiquement choisis de manière à « répartir le manque de confiance » entre les queues

. Il est par exemple possible de choisir L et U, les bons quantiles F, de sorte que la probabilité que la variable (5.2.4.3) se situe entre L et U corresponde au niveau de confiance souhaité. (L et U sont typiquement choisis de manière à « répartir le manque de confiance » entre les queues  <U

<U

dans les encadrés (5.2.4.5) et (5.2.4.6) correspond à une hypothèse nulle où les variances sont égales. C’est le seul choix communément utilisé en pratique.)

dans les encadrés (5.2.4.5) et (5.2.4.6) correspond à une hypothèse nulle où les variances sont égales. C’est le seul choix communément utilisé en pratique.)

< # et

< # et  \#" title="\mathrm{H}_{\mathrm{a}}: \sigma_1^2 / \sigma_2^2>\#" class="latex mathjax"> sont (respectivement) les queues de distribution

\#" title="\mathrm{H}_{\mathrm{a}}: \sigma_1^2 / \sigma_2^2>\#" class="latex mathjax"> sont (respectivement) les queues de distribution  , la convention standard est de reporter deux fois la probabilité

, la convention standard est de reporter deux fois la probabilité  1" title="f>1" class="latex mathjax">, et de reporter deux fois la probabilité

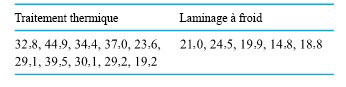

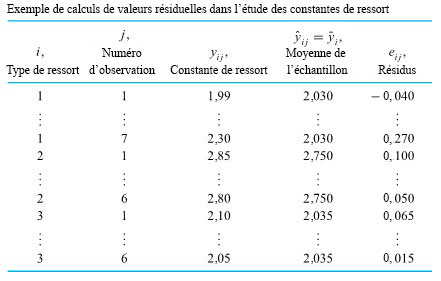

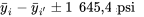

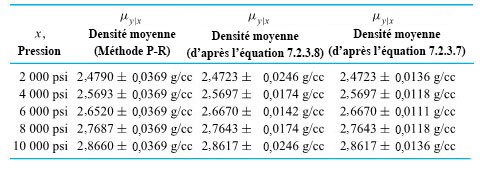

1" title="f>1" class="latex mathjax">, et de reporter deux fois la probabilité  étudiée si